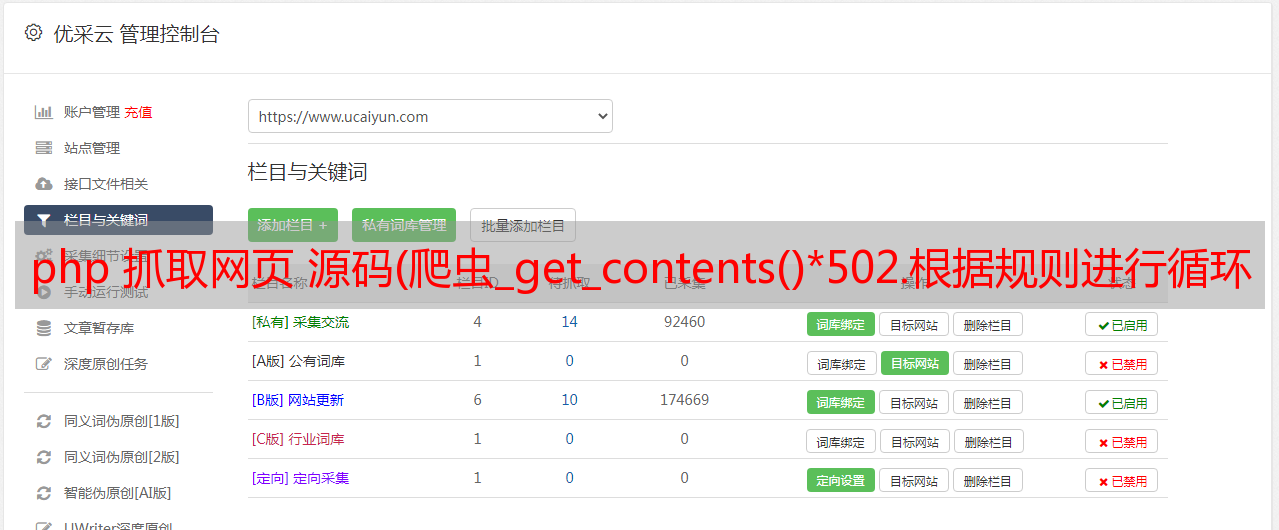

php 抓取网页 源码(爬虫_get_contents()*502.根据规则进行循环爬取内容3. )

优采云 发布时间: 2021-09-12 14:12php 抓取网页 源码(爬虫_get_contents()*502.根据规则进行循环爬取内容3.

)

爬虫是按照一定的规则自动抓取万维网上信息的程序或脚本。

我们通常使用搜索引擎浏览网页,有很多与预期信息不匹配的结果;并且信息量巨大,得到结果后需要花费大量的精力来过滤信息。爬虫诞生了,我们可以写一个脚本或者程序,让他按照我们的需要按照设定的规则抓取网页信息,过滤出我们需要的结果。

首先,PHP中可以获取网页的函数有很多,比如:file_get_contents()或者curl扩展,或者ob_get_contents()获取缓冲区等等,最实用最常用的就是file_get_contents( )。示例:

目标页面

代码和效果

打开文件后对比

所以,我们可以使用 file_get_contents() 来开发爬虫。

步骤:

1.解析url规则

首页:/f?ie=utf-8&kw=php

第二页:/f?kw=php&ie=utf-8&pn=50

第三页:/f?kw=php&ie=utf-8&pn=100

第一页后加&pn=0与第一页内容一样,所以每页pn参数会增加50

可以概括为:&pn=(当前页码-1)*50

2.按规则循环抓取内容

3. 根据需求定期匹配需要的内容(可根据实际需求做)

4. 积分结果(写入文件)

<p>//爬取前3页

for($i=1;$i