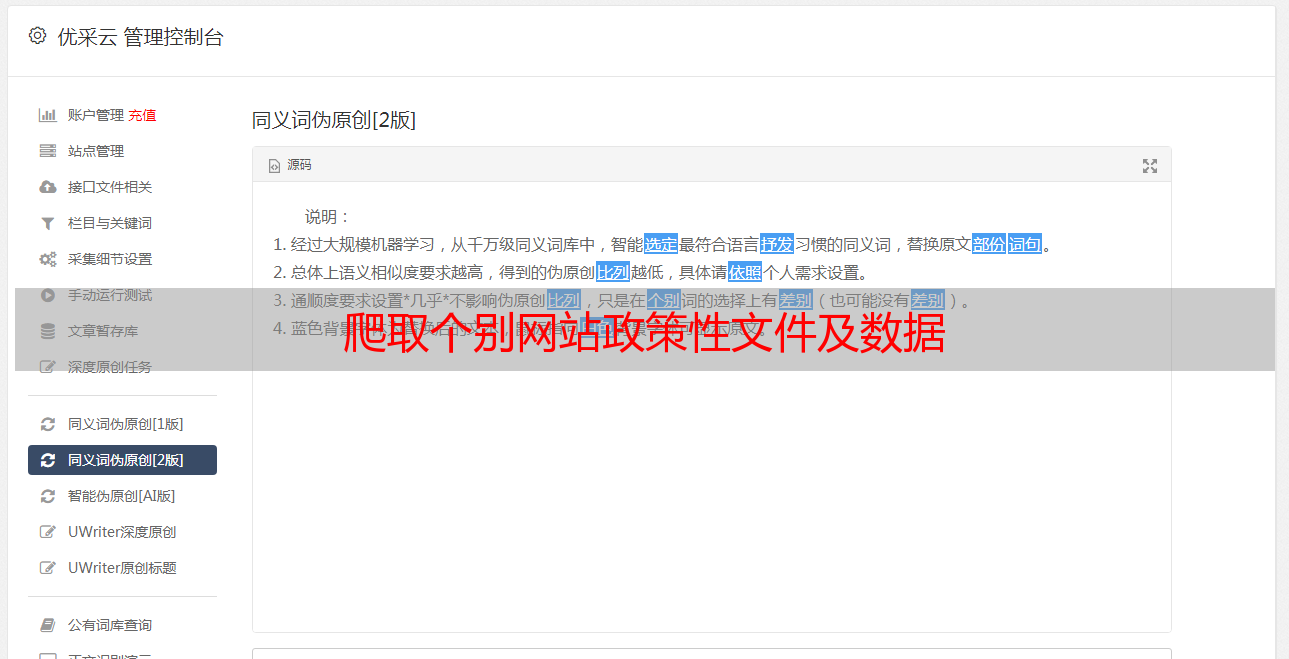

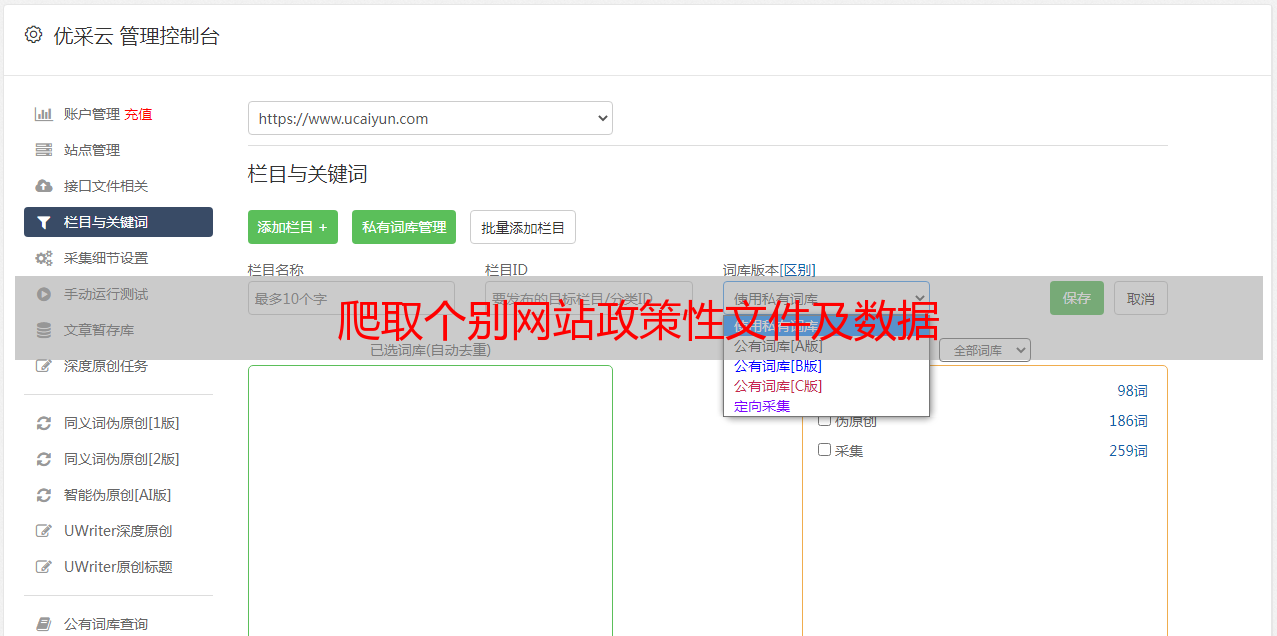

爬取个别网站政策性文件及数据

优采云 发布时间: 2020-08-22 02:11爬取个别网站政策性文件及数据

访问一些政府网站并获取网页

根据需求解析出其中的政策性文件以需求的数据

保存到本地,如果失败则记录在日志中

github:

一、需求介绍(示例北京)

需求介绍见文档%E9%9C%80%E6%B1%82

下面为一个区的需求示例

进入政府(部门)官网 找出其中的政府文件栏目,一般在信息公开中

进入政府文件网站红色画圈部份为须要采集的文章。

采集范围为:市政府文件、市政府办公厅文件、部门文件、区文件

进入文章页面

将网页其中的部份内容爬取储存到本地TXT(名称为文件标题)

需采集网页URL、文件信息、文件内容

将网页中的文件下载储存到相应文件夹中,以文章标题命。

具体参考示例

网页中有下载链接或则附件的也需下载到相应的文件夹中

二、代码

源代码:

爬虫泛型,主要用于下载网页(包括启动浏览器下载和程序下载网页),下载图片,获取某html标签的文字内容,下载某大标签的所有文字。 日志类,主要用于写日志,用于保存程序运行过程所需日志,运行后日志保存在logs文件中,以日期命名。craw****.py 主要对应于具体某地网站的网站数据抓取类。三、 运行

cd crawGovData/

python craw****.py # craw****.py 指具体的某市网站数据抓取类

如爬取太原市的数据

cd crawGovData/crawTaiyuann/

python crawTaiyuan.py

python crawTaiyuanFgw.py

python crawTaiyuanWjw.py

...

python crawTaiyuanjxw.py

环境python3requests2.18lxml4.2