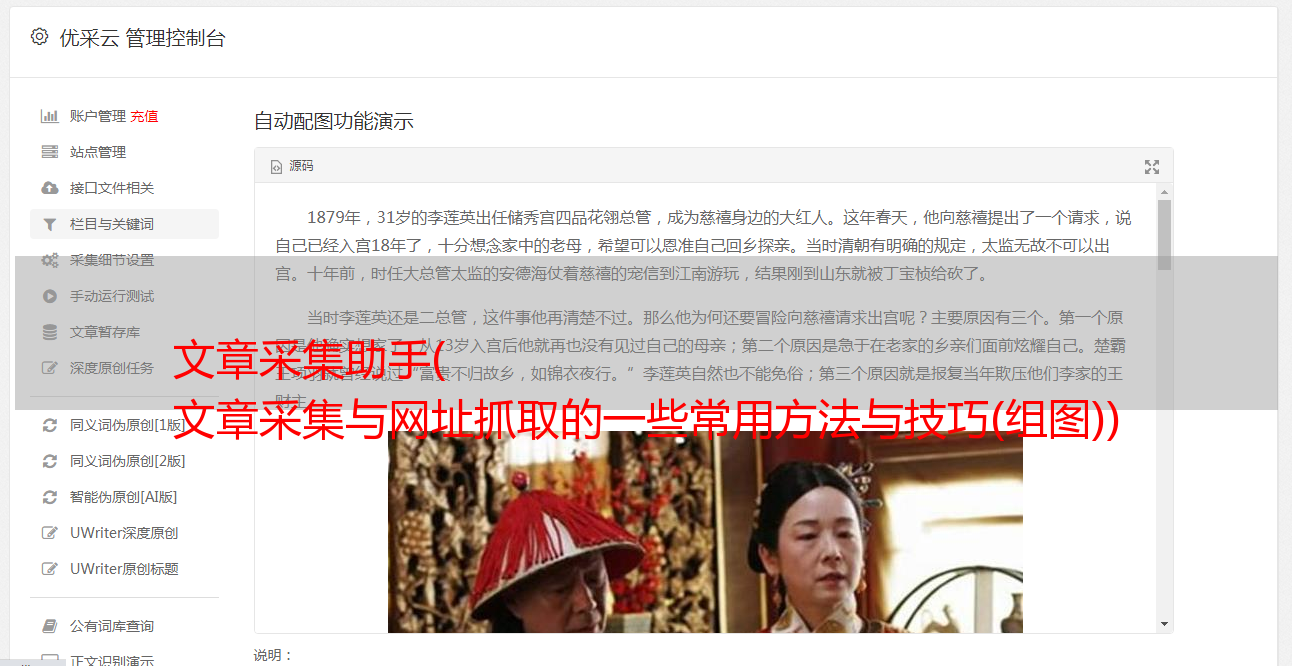

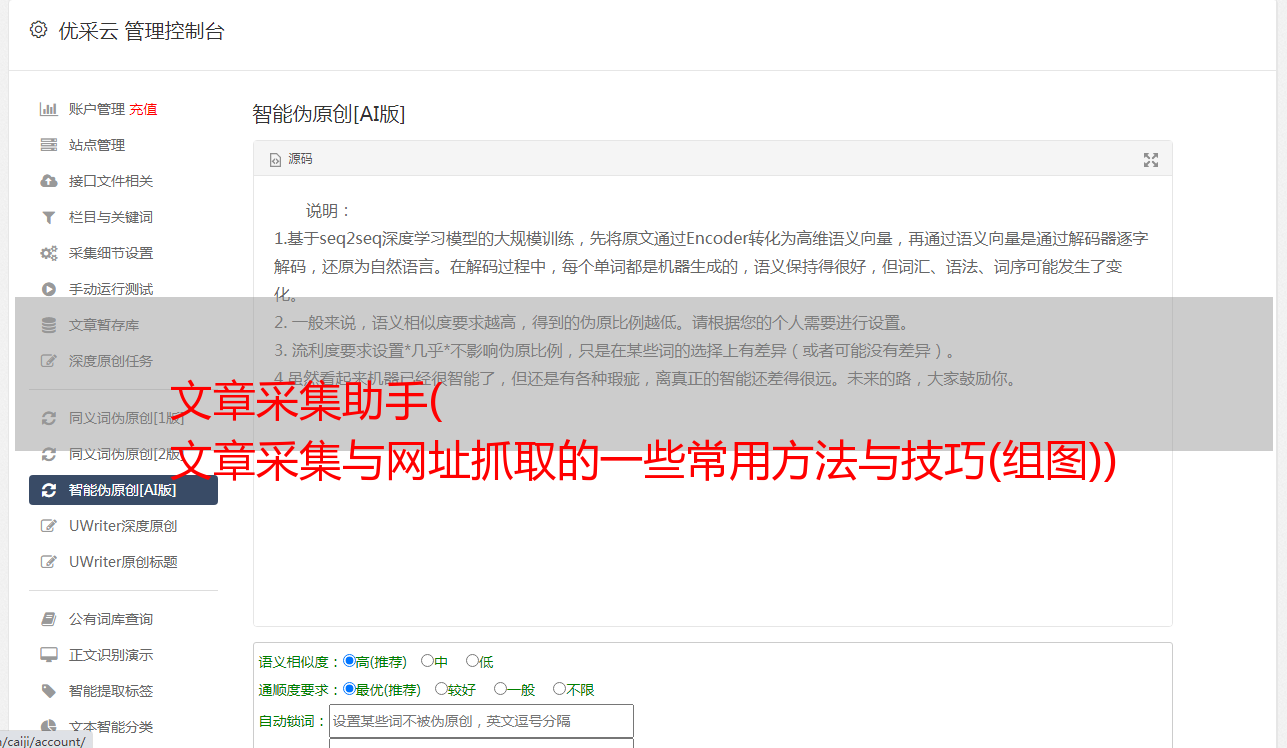

文章采集助手( 文章采集与网址抓取的一些常用方法与技巧(组图))

优采云 发布时间: 2021-09-04 21:02文章采集助手(

文章采集与网址抓取的一些常用方法与技巧(组图))

A5 bug 营销助理售后组大师众多。为了让您了解更多,我们定期组织交流分享活动,促进分享氛围,挖掘大师经验,帮助您建立联系,更快进步。我们致力于将昆虫售后群打造成互联网网站/营销大师群。在这里,您学到的不仅是昆虫。

未来没有惊喜。我们将在每周六晚上8:30举办一次分享活动。欢迎您准时参加。也欢迎您与我联系,与您分享您的经验。奖品会增加)。售后组有上百人,大家可以分享一点宝贵的经验。这意义重大。分享创造价值。今天的分享者是乐逍遥和二十二,就“文章采集和网址抓取”为大家带来一些常用的方法和技巧。

乐逍遥——文章的采集:

文章采集的第一部分是填写列表页的地址。这其实是一个常态。 Bug 是常规的采集,其实很简单。 [page]变量代表页码,页码

这个大家都知道,这里配置起来更方便。一般是一行链接代码。将 href 链接 URL 部分替换为 (.*?)。蠕虫软件采集规则采用标准正则表达式书写,前后括号表示这是提取的参数。其实不一定是(.*?),其他的写法比如([^"]*)也是可以的。

这意味着 (.*?) 替换地址,并且 (.*?) 这条常规规则替换地址。简单易懂。

第三部分,文章标题和正文提取,这部分是最难的。其实也不难,只要找出标题前后、正文前后的特征,然后结合起来就可以了。一般来说,标题可以用 (.*?) 代替。这个正则表达式的意思是匹配同一行上的所有字符(不包括换行符),除了它后面的字符串。通常,文本可以替换为 ([\s\S]*?)。这个表达式的意思是匹配所有字符(包括换行符,因为文本可能收录换行符),除了后面的字符。弦也。带括号的正则表达式意味着它应该被提取并用作参数。如果源代码中的标题在前面,则选择“标题在前面”,否则选择“标题在后面”。这里只允许两个带括号的正则表达式,其他部分也可以存在正则表达式,但不需要提取使用,所以不能加括号。至于正文和标题,可能有很多不相关的代码内容,可以用[\s\S]*代替,这个不用括号。无论代码的内容如何,您都可以使用 [\s\S]* 代替。这是要注意的。通常,文本可以替换为 ([\s\S]*?)。弄清楚这两个就可以了。 .

比如我们采集栏下的文章,你可以把第一部分写成这样:[page].html,然后找出网址,chongseo教你网站10个增加流量的技巧,正文一般情况下可以用([\s\S]*?)代替,然后开始测试采集,OK,成功。

二十二基本参数和网址抓取:

1、基本参数:

一个大项,线程,大家应该明白,不是越快越好。这取决于实际情况。比如注册的时候可以选择30-50个线程,但是在做博客群发的时候,也有问答群发帖。使用 1 个线程时。

B 大项目,重点是自定义邮箱设置。这种反应更有问题。让我说一点。 pop函数直接用于新注册的邮箱。您必须先登录邮箱,查看是否已激活。稍后再设置,以免出错。

需要关注C大项时,记住注册用户名是8-12。今天,有网友截图问会出什么问题。篇幅太长,没注意。

D大项,没什么好说的。每个人都进来并在小组中提问。如果这方面没有问题,我就不多说了,只谈爬取。

2、URL 抓取理解;第二,验证程序是你要抢网站的目标类型。目前bug都加了自动验证,一般大家选择这个很好;服务器类型的选择 一个GG,一个bd,一个yh。

bd资源和yh资源比较少。一般来说,GG的抓取量非常大。一般40条左右的规则抓到10000以上是没有问题的。获取它的唯一方法是搜索说明。 ,Bugs自带大量搜索说明,当然你也可以分析目前主流的cms程序写规则,比如DZ论坛程序,intitle:Powered by Discuz!,这个规则百度和百度都可以用GG抢DZ论坛。绑定验证程序时选择自动验证,这样DZ NT和DZ1.5-2.0都可以选择。

大量爬取怎么样?当然,一个规则肯定不好。让我们看看这个,由 Discuz 提供支持的北京! X1.5 inurl:forum.php,这个搜索命令只显示北京本地所有的DZ1.5论坛。百度只能抓取前7个页面,而GG可以抓取N个页面,但是GG抓取的时候,必须要使用国外IP进行抓取(这个你应该懂,天超),所以建议如果你想要很多抓取网址,花10多块钱买VPN包月,那么一个月100万个网址不是问题。就像由Discuz提供支持的北京!刚才提到的x1.5 inurl:forum.php,北京哪里找关键词,教你一个方法,去各大输入法网站下载词库。当然,我们已经下载了,不可能一一添加,必须批量导入指令。首先,我们先把下载的词复制到excel中进行处理。复制A列关键词,B列发布规则,然后将两种情况都复制到txt文本中,然后替换下一个空格。搜索内容约5个空格,替换为1个空格。那么最终的处理结果是这样的。

然后保存并开始导入错误。下一步是开始爬行。一般GG导入100多个条目,编码最多会出来10次左右。前提是你必须使用国外的IP。下来后可以试试。 100条规则大概可以爬取超过1.300万个网址,当然也一定和你写的规则有关,规则错了,一个爬不出来。好吧,抓住这些你想用来做bug的东西,平时多看看,多做点,随便点软件,点不差。先看说明书,再群分享。不要在小组中只问一个小问题。首先检查你做错了什么,是否按照说明操作,参数是否正确,然后再做一次。分享结束后,我们还进行了互动和提问。

Freedom Group:那么,您不关心关键字吗?

答案:您可以忽略它。批量导入的时候,关键字已经添加了,而且数量很多,比这里添加好。如果您想搜索单个关键字,则可以。

Freedom Group:由 Discuz 提供支持的化妆品! X1.5 inurl:forum.php,比如我在找化妆品网站,这是规定吗?

答:和化妆品有关的网站都会出来,当然一些无关的也会出来。

.﹎Plain:你能用英语告诉我一些关于URL爬取采集的事情吗?谢谢!

回答:我没有接触过英语。我只做百度。我可以给你一个方法!蠕虫会爬取英文 URL。你可以自己分析各大英文论坛的网址。最简单的方法就是查看你竞争对手的网站外链,蠕虫有这个规则,也是非常有用和实用的。