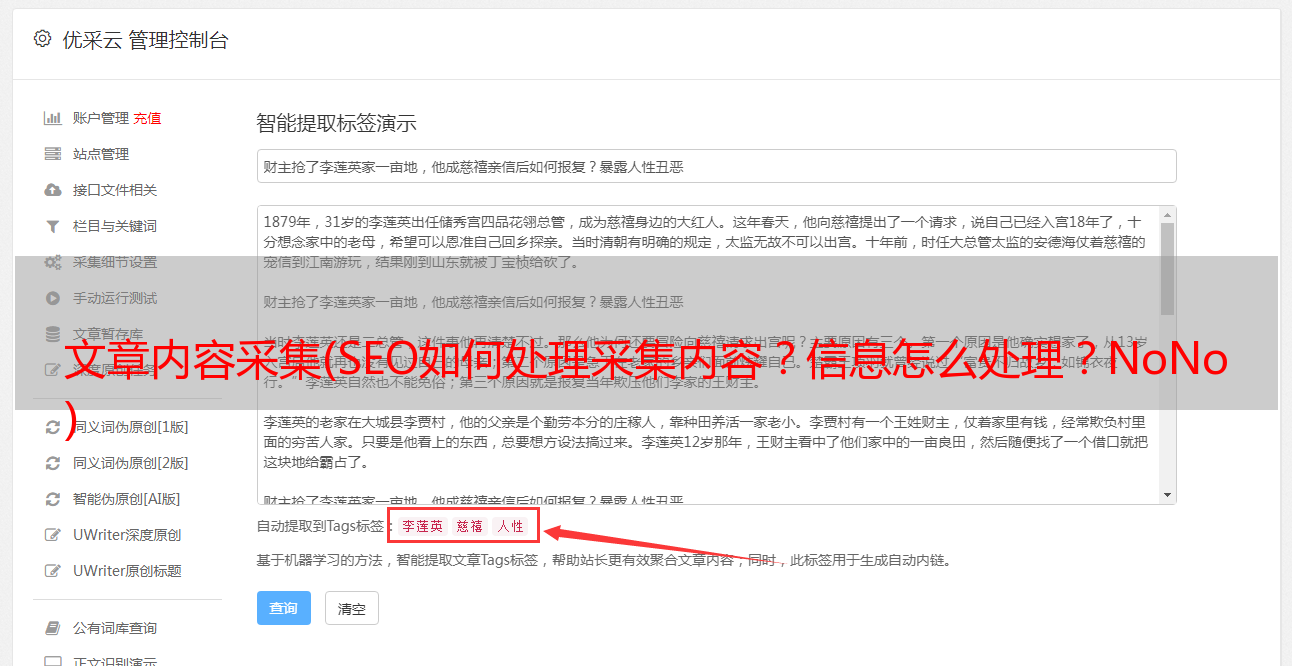

文章内容采集(SEO如何处理采集内容?信息怎么处理?NoNo )

优采云 发布时间: 2021-09-04 09:01文章内容采集(SEO如何处理采集内容?信息怎么处理?NoNo

)

本文信息本文由Method SEO顾问发表于2016-10-3114:10:40,共1204字,请注明:[GoGo闯]SEO如何处理采集内容(5)_【方法SEO顾问】,如果我的网站文章对你有帮助,就来百度口碑给个好评吧!

后台还有很多问题,本文是对其中两个问题的回答

文本提取

在【SEO如何处理采集Content①】的“Pan采集”部分,提到了文本提取,还有人说不知道怎么做。

这个东西可以在网上开源。谷歌搜索“{编程语言}文本提取算法”可以找到很多解决方案,比如:Readability、Boilerpipe、Diffbot……大部分算法已经打包好了。不用自己写就可以直接使用。我们是网站,不是技术,就是用现成的轮子。

所以有些人有另一个问题:我应该使用哪个?

不不不,这不是用轮子思考。首先,不可能每个算法都提取所有网页。其次,算法不止一种。

事情很简单。算法不会提取当前网页的文本。这很容易处理。不需要做任何其他事情。只需剪出一个算法,然后再试一次。如果这不起作用,则更改为下一个。一个可以提取文本。除非这个页面模板乱七八糟,什么都有,比如网站home page,没有明显的主内容块,这个是另外算的。

所以,如果在pan采集的过程中需要提取链接的body,最好先过滤掉首页url。

如果非要纠结用哪个,请参考:

内容去重

还有个问题,采集遇到重复的内容怎么办?

这个渣以前用过两种方法。

第一种:

首先,我们定义了有效内容需要满足哪些指标。比如字数必须大于150字才算有效内容,小于150字的删除不会存入数据库。那么大于150字的内容一般有4个以上标点符号。

XXXXXXX,XXXXXXXXX。XXX:“XXXXXX,XXXXXXXXXXXX。XXXXXX,XXXXXXXXXX,XXXXXXXX,XXXXXX。XXX?”

XXXX,XXXXXXX。XXXXXXX;XXXX;XXXXXXXX;XXXXXX,XXXXXXXXXX,XXXXXXXX,XXXXXX - XXX!

所以对于每个文章,从第二个标点符号开始,连续提取两个标点符号之间的文本,单词数大于7,直到提取三个文本段。

然后将这3个文本段合并为一个,去掉文本段重复的文章,只保留一个。因为相同的文章连续3个文本段基本上都是重复的,而且是完全重复的,没有变化。

第二种

使用现有的重复文本删除算法,还是谷歌搜索,一堆现成的方案,比如simhash、Shingling...

首先清理所有捕获的文本,去除不相关的词,如停用词、辅助词(死...),然后使用上述解决方案计算相似文档。

哪个更好?药渣感觉都好普通,不觉得哪个好,但都可以用。 . .

但是总是有问题。一旦文章的体积变大,比如几百万美金,程序就会运行得很慢,对CPU的消耗也很大。我该怎么办? ?

于是就沿用了第一种方法的思路,没有分析全文,只是找到每个文章最长的n句,再次做了hash签名,然后使用了上面提到的ready-使算法运行,n一般取3。不仅运行速度快了很多,最终找到类似文章的结果看起来比以前更好。