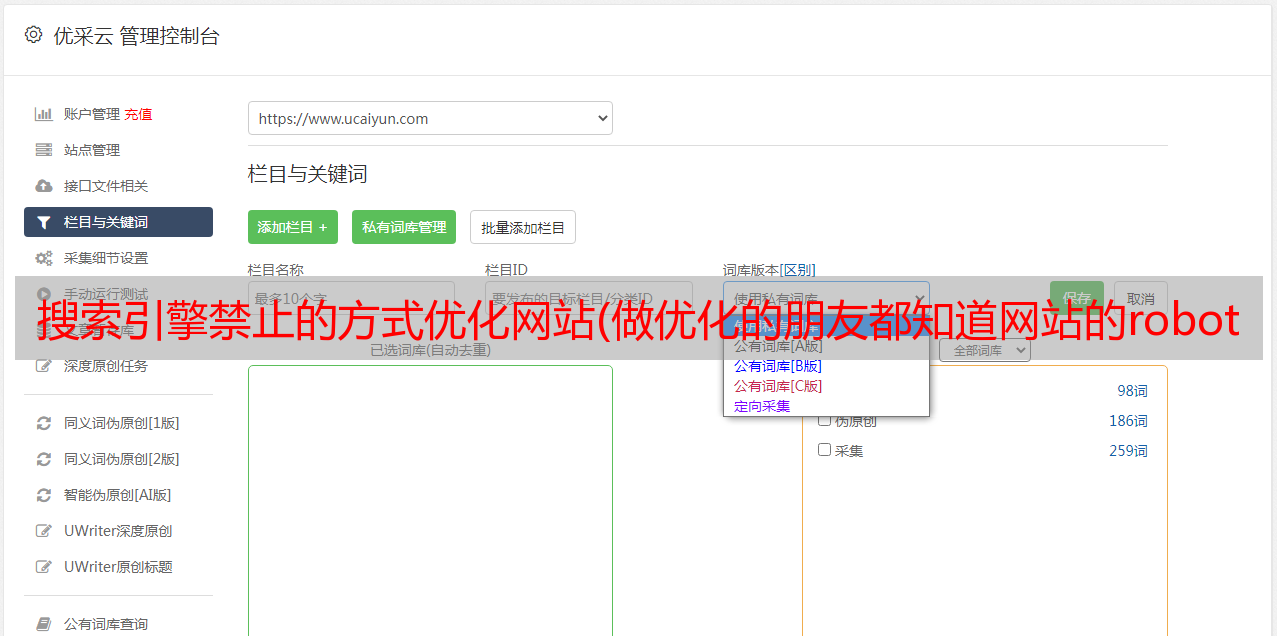

搜索引擎禁止的方式优化网站(做优化的朋友都知道网站的robots的目的是让搜索引擎知道)

优采云 发布时间: 2021-09-03 11:00搜索引擎禁止的方式优化网站(做优化的朋友都知道网站的robots的目的是让搜索引擎知道)

做优化的朋友都知道网站的robots的目的是让搜索引擎知道我们哪些网站目录可以收录,哪些目录禁止收录。一般蜘蛛访问网站时,会先检查你的网站根目录下是否有robots文件。如果有,就会根据这个文件进行爬取和判断。如果没有robots,那么网站的所有页面都可能是收录,这会给网站带来安全隐患。

比如在百度上搜索“织梦内容管理系统V57_UTF8_SP1”,就会出现一堆带有织梦程序的后台地址,将后台暴露给他人,带来极大的安全隐患。

下面木子网先给大家介绍一下robots.txt是做什么的?

Robots.txt 基本上每个网站都可以使用,并且在网站的根目录下。任何人都可以直接输入路径打开查看内容,如。如上所述,这个文件的目的是告诉搜索引擎哪些页面可以爬取,哪些页面不应该爬取。

如何使用robots.txt

在网站root目录下创建一个文件,命名为robots.txt,文件名必须是这个!然后在里面设置规则。

比如我有一个博客,我想设置没有搜索引擎收录本站。只需在robots.txt中设置以下两行即可。

用户代理:*

禁止:/

如果你想限制搜索引擎访问我们的网站background admin目录,规则应该改为:

用户代理:*

禁止:/admin/

更多关于robots.txt的使用规则超出了本文的范围。详情可以阅读上一篇文章《网站Robots文件编写优化详解》。

通过上面的方法,我们可以禁止搜索引擎收录我们的后台页面,但矛盾的是,任何人都可以访问robots.txt文件,包括黑客。为了禁止搜索引擎,我们还向黑客泄露了隐私。

和上面的例子一样,我们在robots.txt中做了限制,以防止搜索引擎访问收录admin页面。但是这个robots.txt页面任何人都可以查看,所以黑客可以通过robots了解我们网站后端或者其他重要的目录结构。

有没有办法在不泄露后台地址和隐私目录的情况下,利用robots.txt的功能屏蔽搜索引擎访问?

是的,就是用星号(*)作为通配符,截取部分目录名。比如下面的后台地址是admin:

用户代理:*

禁止:/a*/

或者使用以下方法:

用户代理:*

禁止:/ad

关键在第二句,这将阻止搜索引擎访问任何以“ad”开头的文件和目录。为了防止别人猜到你的后台目录,这里截取的时间越短越好。当然,如果你的后台目录是admin,还是有人猜的,但是如果你把admin改成admadm呢?还有谁会知道?

综上所述,为了防止搜索引擎收录网站进入后端目录和其他私有目录,我们将在robots.txt文件中禁用这些路径。为了不让robots.txt中的内容泄露网站的背景和隐私,我们可以使用以上两种机器人编写方式。最后,为了防止黑客猜测真实路径,我们可以非常规地重命名这些敏感目录,例如添加特殊符号“@”。

好的,关于robots.txt防止网站background和隐私目录泄露给黑客,就介绍这么多,希望对大家有帮助,谢谢!

详解网站optimization的robots文件的编写

在网站优化过程中,很多站长朋友都遇到过这样的问题,不希望搜索引擎收录页面是收录,如果网站后台页面或者配置文件等收录 ,那么网站的安全就受到威胁了。这时候就体现了网站robots.txt文件的功能。我们只需要在文件中屏蔽蜘蛛的访问,这样搜索引擎就不会爬取这些页面,不仅可以减轻蜘蛛的爬行压力,还能集中网站的权重,这对网站也是非常有利的@优化。

在正式介绍robots.txt的标准写法之前,先介绍一下robots的使用。从书面解释来看,robots 是指机器人。从文件后缀来看,是一个txt文档。结合这两点,我们可以看到这个文件是给搜索引擎的蜘蛛机器人看的。所谓robots.txt文件就是Robots协议(也叫爬虫协议、robot协议等)。它是搜索引擎蜘蛛抓取的第一个文件。通过这个文件,蜘蛛可以了解到网站可以被爬取。无法抓取这些页面。当然,我们也可以直接屏蔽蜘蛛的访问。接下来,木子网络为大家详细介绍robots.txt文件的编写。

robots.txt 声明:

User-agent: * 其中*代表所有类型的搜索引擎,*是通配符

Disallow: /admin/ 这里的定义是禁止爬取admin目录下的目录

Disallow: /require/ 这里的定义是禁止爬取require目录下的目录

Disallow: /ABC/ 这里的定义是禁止爬取ABC目录下的目录

禁止:/cgi-bin/*.htm 禁止访问 /cgi-bin/ 目录中所有后缀为“.htm”的 URL(包括子目录)。

Disallow: /*?* 禁止访问网站 中所有收录问号 (?) 的 URL

Disallow: /.jpg$ 禁止抓取网络上所有 .jpg 格式的图片

Disallow: /ab/adc.html 禁止爬取ab文件夹下的adc.html文件。

Allow: 这里定义了 /cgi-bin/ 以允许爬取 cgi-bin 目录下的目录

Allow:这里定义了/tmp,允许爬取整个tmp目录

允许:.htm$ 只允许访问带有“.htm”后缀的 URL。

允许:.gif$ 允许抓取网页和 gif 格式的图像

站点地图:网站Map 告诉爬虫这个页面是网站Map

编写robots.txt的例子:

1、禁止所有搜索引擎访问网站的所有部分

用户代理:*

禁止:/

2、禁止百度索引你的网站

用户代理:百度蜘蛛

禁止:/

3、 禁止 Google 将您的 网站 编入索引

用户代理:Googlebot

禁止:/

4、 禁止除 Google 之外的所有搜索引擎将您的 网站 编入索引

用户代理:Googlebot

禁止:

用户代理:*

禁止:/

5、禁止百度以外的所有搜索引擎索引你的网站

用户代理:百度蜘蛛

禁止:

用户代理:*

禁止:/

6、禁止蜘蛛访问某个目录

(比如禁止admin\css\images被索引)

用户代理:*

禁止:/css/

禁止:/admin/

禁止:/images/

7、允许访问目录中的某些 URL

用户代理:*

允许:/css/my

允许:/admin/html

允许:/images/index

禁止:/css/

禁止:/admin/

禁止:/images/

robots.txt 常用措辞示例:

例如1.禁止所有搜索引擎访问网站的任何部分

用户代理:*

禁止:/

示例2.允许所有机器人访问

(或者你可以创建一个空文件“/robots.txt”)

用户代理:*

禁止:

或

用户代理:*

允许:/

例子3.只禁止百度蜘蛛访问你的网站

用户代理:百度蜘蛛

禁止:/

例子4.只允许百度蜘蛛访问你的网站

用户代理:百度蜘蛛

禁止:

用户代理:*

禁止:/

例子5.禁止蜘蛛访问特定目录

本例中网站有3个限制搜索引擎访问的目录,即robots不会访问这三个目录。需要注意的是,每个目录必须单独声明,不能写成“Disallow: /cgi-bin/ /tmp/”。

用户代理:*

禁止:/cgi-bin/

禁止:/tmp/

禁止:/~joe/

示例6. 允许访问特定目录中的某些 URL

用户代理:*

允许:/cgi-bin/see

允许:/tmp/hi

允许:/~joe/look

禁止:/cgi-bin/

禁止:/tmp/

禁止:/~joe/

示例7.使用“*”限制对url的访问

禁止访问/cgi-bin/目录下所有后缀为“.htm”的URL(包括子目录)。

用户代理:*

禁止:/cgi-bin/*.htm

示例8.使用“$”限制对url的访问

只允许访问带有“.htm”后缀的 URL。

用户代理:*

允许:.htm$

禁止:/

示例9.禁止访问网站中的所有动态页面

用户代理:*

禁止:/*?*

例10.禁止百度蜘蛛抓取网站上的所有图片

只允许抓取网页,禁止抓取任何图片。

用户代理:百度蜘蛛

禁止:.jpg$

禁止:.jpeg$

禁止:.gif$

禁止:.png$

禁止:.bmp$

例11.只允许百度蜘蛛抓取.gif格式的网页和图片

允许抓取gif格式的网页和图片,不允许抓取其他格式的图片

用户代理:百度蜘蛛

允许:.gif$

禁止:.jpg$

禁止:.jpeg$

禁止:.png$

禁止:.bmp$

例12.只有百度蜘蛛禁止抓取.jpg格式的图片

用户代理:百度蜘蛛

禁止:.jpg$

写这些句子时,需要特别注意的一点是冒号 (:) 和 (/) 之间必须有一个空格。如果不添加此空间,它将不起作用。 robots.txt文件一般放在网站的根目录下,名字必须是robots.txt。

在阻止目录时请注意,如果是为了防止对目录的爬取,必须注意目录名中的“/”。不带“/”表示禁止访问目录的所有内容和收录目录名的文件。 “/”表示阻止访问目录的所有内容。这两点必须分清楚。详见“robots文件屏蔽目录有/斜杠与无斜杠的区别”。

为了让搜索引擎更快收录我们的内页,我们通常会制作一个百度地图或者谷歌地图,然后,Sitemap:+网站Map,这个命令可以快速引导搜索引擎蜘蛛来你的地图页面抓取网站内页。当网站的死链接太多处理起来很麻烦时,我们可以使用robots来屏蔽这些页面,避免网站因为死链接被百度降级。

在网站优化过程中,了解和控制搜索引擎蜘蛛非常重要。那么今天木子网就来介绍一下robots.txt文件的编写方法。希望对大家有帮助。