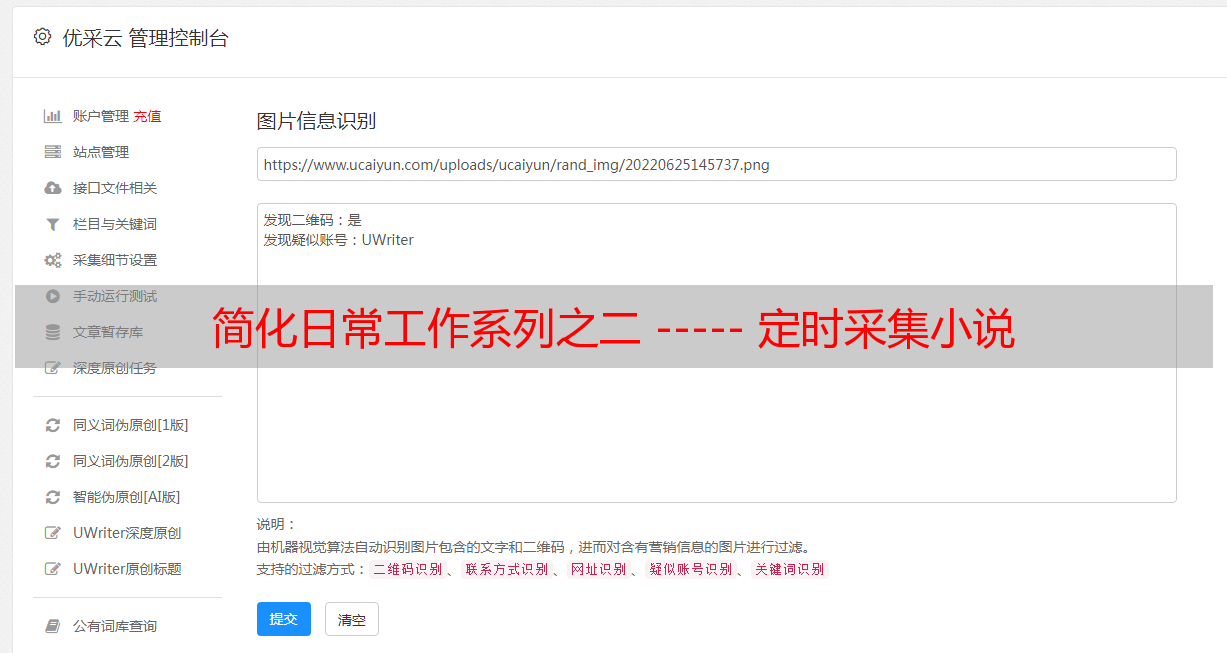

简化日常工作系列之二 ----- 定时采集小说

优采云 发布时间: 2020-08-13 15:042.去跑一遍采集小说的脚本任务

为了降低依赖,之前采集小说的实现是两部份:

第一部分:nodejs去目录页抓取章节的url,写入txt文件储存。

第二部份:php借助封装的curl类和剖析解析类去分别获取标题内容,写入HTML文件。

这样除了要使进行定时任务的物理机或docker上要有php环境也要有nodejs环境。由于我擅长php,所以改为两部份全部由php完成。采集的完整代码可以见上面写过的采集类等博客。

curl封装类beta版的博客记录:

优化curl封装类的博客记录:

如果不熟悉的同学,可以先看这部份博客后再阅读本文。

代码关键部份:

$menuUrl = 'http://www.zhuaji.org/read/2531/';

$menuContents = MyCurl::send($menuUrl, 'get');

$analyzer = new Analyzer();

$urls = $analyzer->getLinks($menuContents);

后面再循环去curl每位章节页面,抓取和解析内容并写入文件即可。

代码简约和可读性早已比较好了。现在我们考虑效率和性能问题。这个代码都是一次性下载完所有文件,唯一做去重判别都是在每次get到章节内容然后对比文件名是否存在。但早已做了一些无用费时的网路恳求。目前该小说有578章,加上目录被爬一次,一共要发起578+1次get恳求,以后小说都会不断降低章节,那么执行时间会更长。

这个脚本最大的困局就在网路消耗上。

此脚本效率不高,每次都是把所有章节的页面都去爬一次,网络消耗很大。如果是第一次下载还好,毕竟要下载全部。如果是每晚都执行,那么显然我是想增量地去下载前一天新增的章节。

又有几个思路可以考虑:

1.我们要考虑每次执行以后最后一个被存出来的页面的id要记录出来。然后下一次就从这个id开始继续下载。

2.中间断开也可以反复重新跑。(遵从第一条最后一句)

这样能够从新增的页面去爬,减少了网路恳求量,执行效率急剧增强。

其实这个问题就弄成想办法记录执行成功的最后一个章节id的问题了。

我们可以把这个id写入数据库,也可以写入文件。为了简单和少依赖,我决定还是写文件。

单独封装一个获取最大id的函数,然后过滤掉早已下载的文件。完整代码如下:

function getMaxId() {

$idLogFiles = './biggestId.txt';

$biggestId = 0;

if (file_exists($idLogFiles)) {

$fp = fopen($idLogFiles, 'r');

$biggestId = trim(fread($fp, 1024));

fclose($fp);

}

return $biggestId;

}

/**

* client to run

*/

set_time_limit(0);

require 'Analyzer.php';

$start = microtime(true);

$menuUrl = 'http://www.zhuaji.org/read/2531/';

$menuContents = MyCurl::send($menuUrl, 'get');

$biggestId = getMaxId() + 0;

$analyzer =new Analyzer();

$urls = $analyzer->getLinks($menuContents);

$ids = array();

foreach ($urls as $url) {

$parts = explode('.', $url);

array_push($ids, $parts[0]);

}

sort($ids, SORT_NUMERIC);

$newIds = array();

foreach ($ids as &$id) {

if ((int)$id > $biggestId) array_push($newIds, $id);

}

if (empty($newIds)) exit('nothing to download!');

foreach ($newIds as $id) {

$url = $id . '.html';

$res = MyCurl::send('http://www.zhuaji.org/read/2531/' . $url, 'get');

$title = $analyzer->getTitle($res)[1];

$content = $analyzer->getContent('div', 'content', $res)[0];

$allContents = $title . "

". $content;

$filePath = 'D:/www/tempscript/juewangjiaoshi/' . $title . '.html';

if(!file_exists($filePath)) {

$analyzer->storeToFile($filePath, $allContents);

$idfp = fopen('biggestId.txt', 'w');

fwrite($idfp, $id);

fclose($idfp);

} else {

continue;

}

echo 'down the url:' , $url , "\r\n";

}

$end = microtime(true);

$cost = $end - $start;

echo "total cost time:" . round($cost, 3) . " seconds\r\n";

加在windows定时任务或linux下的cron即可每晚享受小说的乐趣,而不用每次自动去浏览网页浪费流量,解析后的html文件存文字版更舒服。不过这段代码在低版本的php下会报错,数组简化写法[44,3323,443]是在php5.4以后才出现的。

之前下载完所有小说须要大约2分多钟。改进最终结果为:

效果明显,我在/etc/crontab上面设置如下:

0 3 * * * root /usr/bin/php /data/scripts/tempscript/MyCurl.php >> /tmp/downNovel.log

这个作者的小说真心不错,虽然后期写得太后宫和文字短缺,常到12点还在更新,所以把每晚定时任务放到凌晨3点采集之。