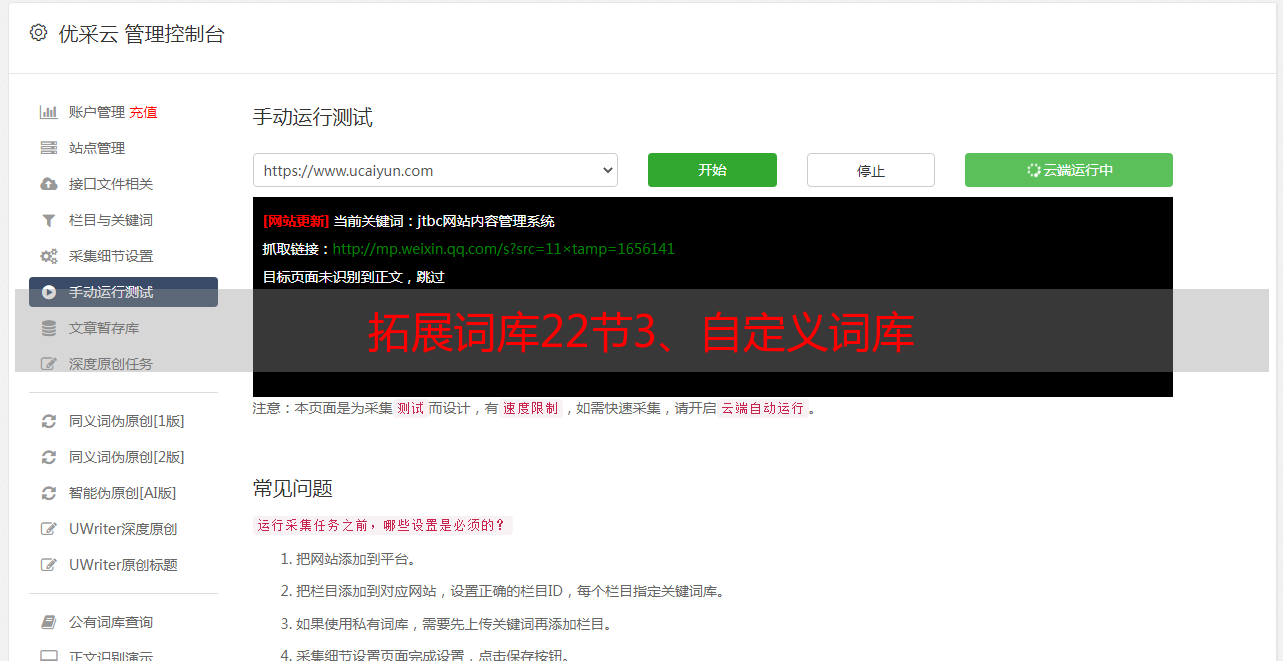

拓展词库22节3、自定义词库

优采云 发布时间: 2021-08-03 00:36拓展词库22节3、自定义词库

【ES从入门到实战】两个十三、全文搜索-ElasticSearch-分词-自定义扩展词库

接第 22 节

3),自定义词库

ik tokenizer 的默认分词不符合我们的需求。对于一些新的网络术语,ik tokenizer 将无法准确识别分词,例如:

POST _analyze

{

"analyzer": "ik_max_word",

"text": "乔碧萝殿下"

}

分词后显示如下,可以看到ik分词器无法识别“乔碧洛”是人名:

在此处插入图片说明

因此,您需要自定义和扩展词典。

自定义和扩展词库,可以修改ik tokenizer的配置文件,指定远程词库,让ik tokenizer向远程发送请求,获取一些最新词,让最新词将是最新的词源分解。

有两种实现自定义词库的方法:

自己实现一个服务,处理ik tokenizer的请求,让ik tokenizer向自定义项目发送请求搭建nginx服务器,将最新的词库放入nginx,让ik tokenizer发送请求到nginx,Nginx 将最新的词库返回给 ik tokenizer,以便 ik tokenizer 可以将原词库与新词库合并。

nginx安装参考六、Appendix-安装nginx

这里我使用第二种方法自定义词库。在创建它之前,您需要安装 nginx。相关内容请访问第 6 章。

在/mydata/nginx/html/路径下新建es目录,新建词库fenci.txt:

在此处插入图片说明

访问可以请求的词库内容:

在此处插入图片说明

修改/usr/share/elasticsearch/plugins/ik/config/中的IKAnalyzer.cfg.xml

在此处插入图片说明

/usr/share/elasticsearch/plugins/ik/config

IK Analyzer 扩展配置

http://192.168.56.10/es/fenci.txt

在此处插入图片说明

注意:如果打开IKAnalyzer.cfg.xml是乱码,可以先退出当前文件,在命令行输入vi /etc/virc,

然后在文件中添加set encoding=utf-8,保存退出,重新打开IKAnalyzer.cfg.xml。

在此处插入图片说明

原创xml:

IK Analyzer 扩展配置

重启 ES:

docker restart elasticsearch

再次在kibana中进行分词,可以看到之前无法识别的“乔碧洛”现在可以识别为一个词了:

在此处插入图片说明

如果以后有新词组,可以直接添加到上面的自定义词库fenci.txt中,重启ES即可。

由于之前安装nginx时重装了ES,所以需要设置ES的自动启动服务:

docker update elasticsearch --restart=always

参考文档分析

参考:

Elasticsearch 参考

弹性

全文搜索引擎Elasticsearch介绍