获取微信公众号文章的方法,你get到了吗?

优采云 发布时间: 2021-07-25 06:33

获取微信公众号文章的方法,你get到了吗?

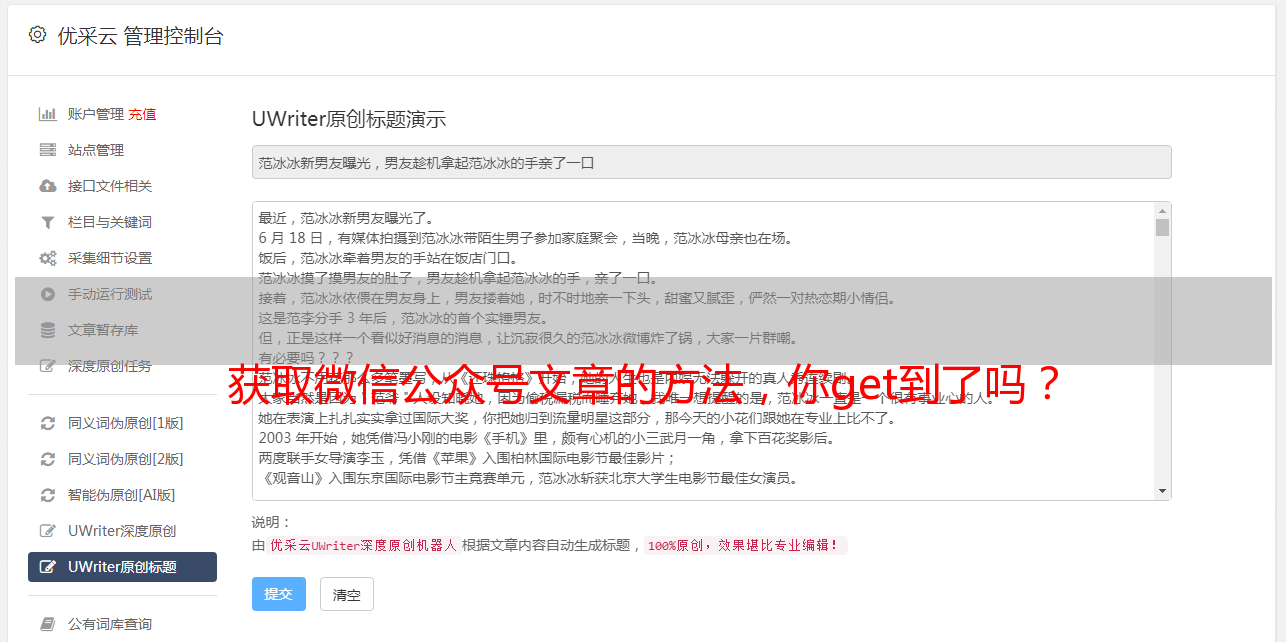

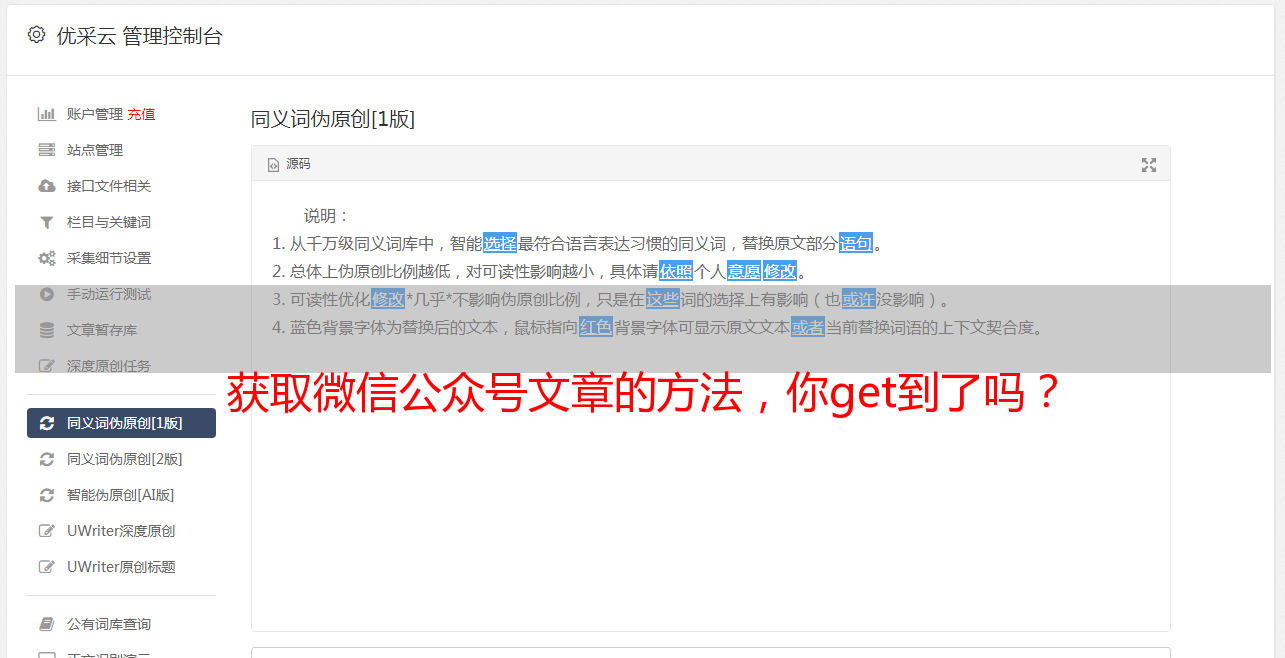

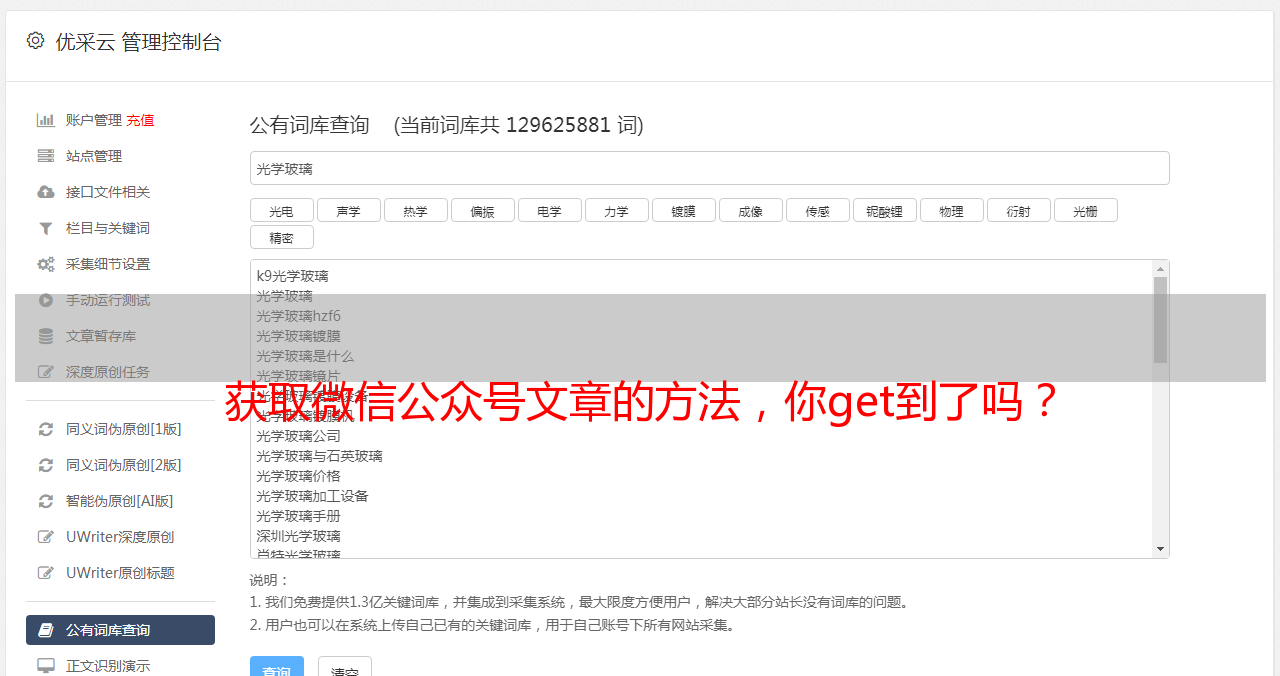

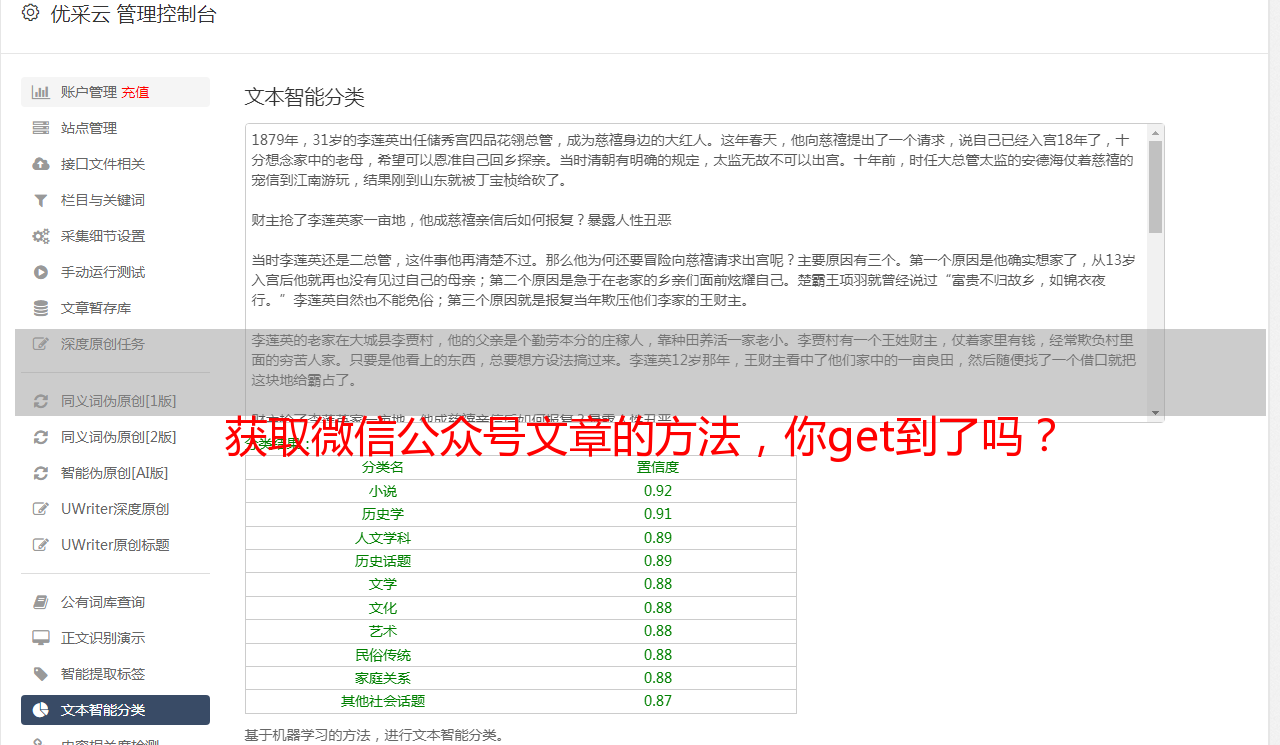

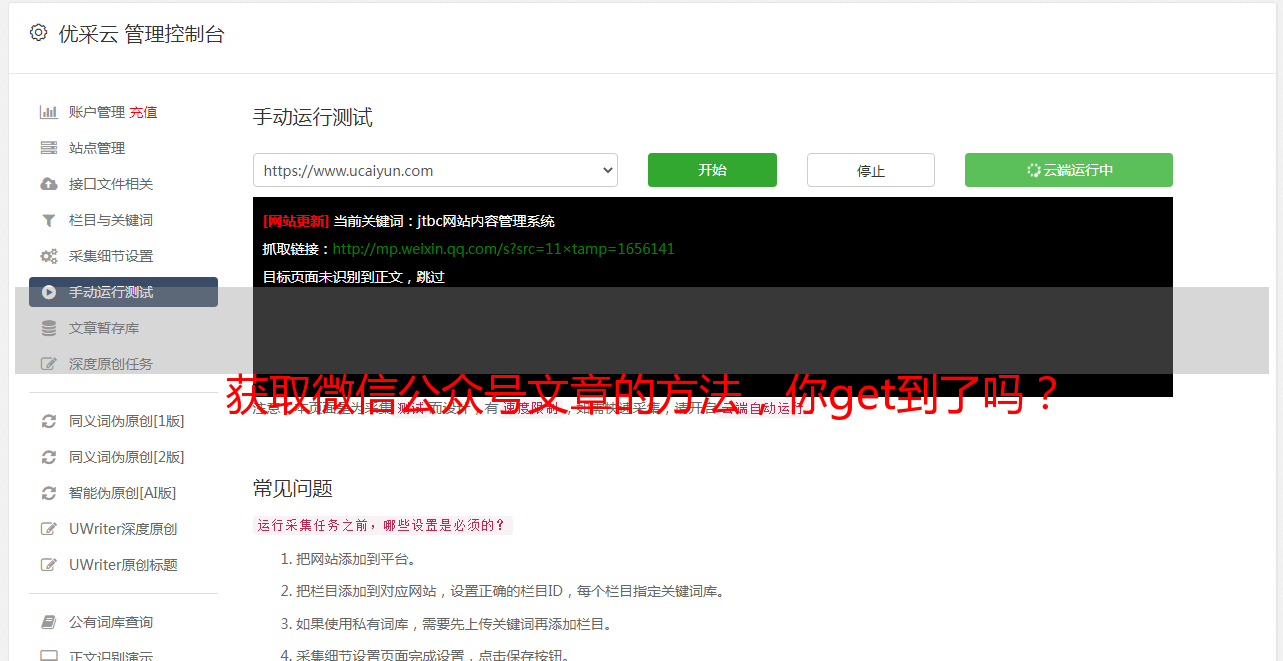

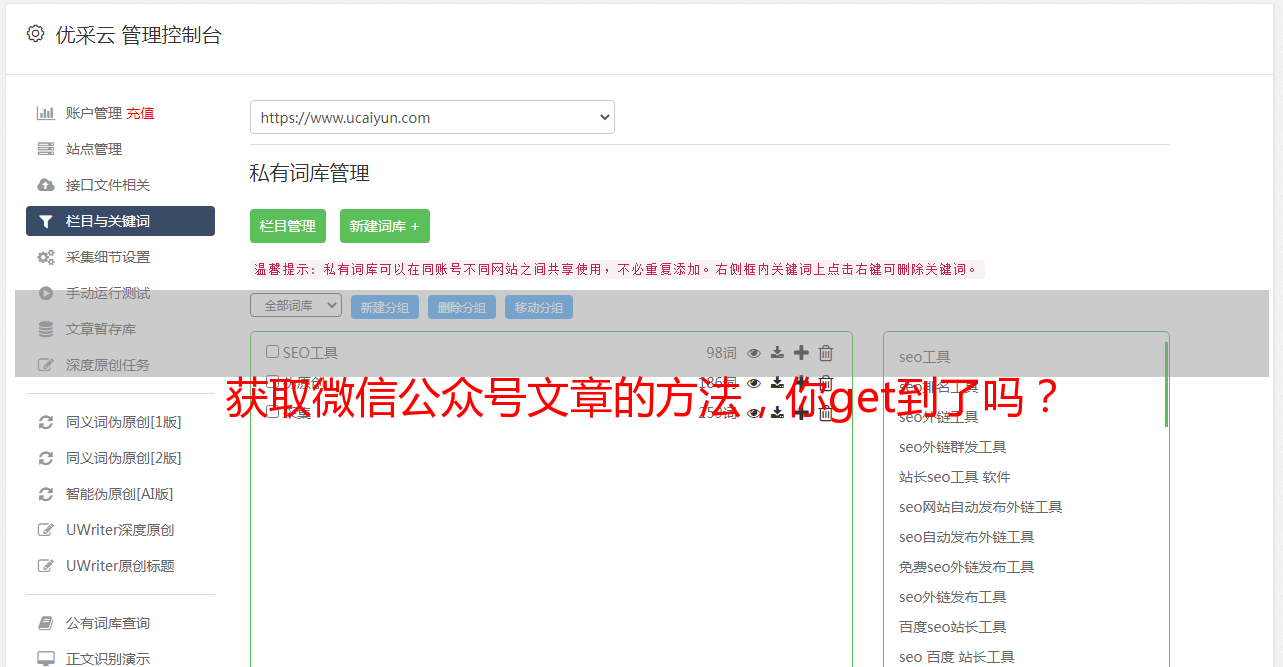

通过微信公众平台获取公众号文章的示例

之前是自己维护一个公众号,但是因为个人关系好久没有更新,今天上来想起来,却偶然发现了微信公众号文章的获取方式。

之前有很多获取方式,通过搜狗、清博、web、客户端等都可以,这个可能不是很好,但是操作简单易懂。

所以,首先你要有一个微信公众平台帐号

微信公众平台:

登录后,进入首页,点击新建群发。

选择自创图形和文字:

好像是公众号操作教学

进入编辑页面后,点击超链接

弹出一个选择框,我们在框中输入对应的公众号,就会出现对应的文章列表

你感到惊讶吗?可以打开控制台查看请求的接口

打开回复,有我们需要的文章链接

确认数据后,我们需要分析这个界面。

感觉很简单。 GET 请求携带一些参数。

Fakeid是公众号的唯一ID,所以如果想直接通过名字获取文章列表,还需要先获取fakeid。

我们输入公众号后,点击搜索。可以看到搜索界面被触发,返回fakeid。

这个接口需要的参数不多。

接下来我们就可以用代码来模拟上面的操作了。

但您还需要使用现有的 cookie 来避免登录。

目前我还没有测试cookies的有效期。可能需要及时更新 cookie。

测试代码:

import requests

import json

Cookie = '请换上自己的Cookie,获取方法:直接复制下来'

url = "https://mp.weixin.qq.com/cgi-bin/appmsg"

headers = {

"Cookie": Cookie,

"User-Agent": 'Mozilla/5.0 (Linux; Android 10; YAL-AL00 Build/HUAWEIYAL-AL00) AppleWebKit/537.36 (KHTML, like Gecko) Version/4.0 Chrome/70.0.3538.64 HuaweiBrowser/10.0.1.335 Mobile Safari/537.36'

}

keyword = 'pythonlx' # 公众号名字:可自定义

token = '你的token' # 获取方法:如上述 直接复制下来

search_url = 'https://mp.weixin.qq.com/cgi-bin/searchbiz?action=search_biz&begin=0&count=5&query={}&token={}&lang=zh_CN&f=json&ajax=1'.format(keyword,token)

doc = requests.get(search_url,headers=headers).text

jstext = json.loads(doc)

fakeid = jstext['list'][0]['fakeid']

data = {

"token": token,

"lang": "zh_CN",

"f": "json",

"ajax": "1",

"action": "list_ex",

"begin": 0,

"count": "5",

"query": "",

"fakeid": fakeid,

"type": "9",

}

json_test = requests.get(url, headers=headers, params=data).text

json_test = json.loads(json_test)

print(json_test)

这样可以得到最新的10篇文章。如果想获得更多的历史文章,可以修改数据中的“begin”参数,0为第一页,5为第二页,10为第三页(以此类推)

但如果你想*敏*感*词*爬行:

请自己安排一个稳定的代理,降低爬虫速度,准备多个账号,减少被屏蔽的可能性。

以上是本文的全部内容。希望对大家的学习有所帮助,也希望大家多多支持。

时间:2019-12-23

如何访问微信小程序公众号文章

前言随着小程序的不断发展,现在个人小程序已经开通了很*敏*感*词*,个人小程序直接打开公众号链接。群里看到的一个小程序,点击直接阅读文章了,所以琢磨了一下,写了一些源码。主要代码:

python爬取微信公众号文章的方法

最近学习了Python3网络爬虫开发实践(崔庆才),刚刚了解到他这里使用代理爬取了公众号文章这里,但是根据他的代码,出现了一些问题。这里我用了这本书前面提到的一些内容进行了改进。 (这个代码作者半年前写的,但腾讯的网站半年前更新了)下面我直接上传代码:TIMEOUT = 20 from requests import Request, Session, PreparedRequest import requests from selenium import webdrive

使用anyproxy提高公众号文章采集的效率

主要影响因素如下:1.网络环境差:2.微信客户端手机或模拟器崩溃:3.其他网络传输错误:因为我看重采集system 这个成本包括硬件投资、算力投资和人力占用。所以必须提高操作的稳定性。因此,如果采集中断,人工能量的成本必然会增加。所以针对这一点,我对 anyproxy 做了一些高级的改造,并利用其他工具来提高运行效率。以下是具体解决方法:一.code upgrade1)微信 浏览器白屏解决方法:修改文件requestHandler.js,或者在rule_default中

python下载微信公众号相关文章

本文示例分享python下载微信公众号文章的具体代码,供大家参考。具体内容如下: 从零开始学自动化测试,从公众号1.下载一系列文档1.搜索微信文章Keyword search2.解析搜索结果的前N页为获取文章titles和对应的url,主要使用Beautifulsoup Weixin.py import requests from urllib.parse import quote in requests和bs4 from bs4 import BeautifulSoup im

Python抓取指定的微信公众号文章

本文示例分享了python爬取微信公众号文章的具体代码,供大家参考。具体内容如下。此方法依赖于 urllib2 库。首先,你需要安装你的python环境。然后安装urllib2库程序的启动方法(返回值为公众号文章list): def openUrl(): print("启动爬虫,打开搜狗搜索微信界面") #加载页面url =' ;s_from=input&query=要爬取的公众号

python采集微信公号文章

本文示例分享了python采集微信公号文章的具体代码,供大家参考。具体内容如下。在python的一个子目录下保存2个文件,分别是:采集公号文章.py和config.py。代码如下:1.采集公号文章.py from urllib.parse import urlencode import pymongo import requests from lxml.etree import XMLSyntaxError from requests.exceptions import Connec

python抢搜狗微信公众号文章

<p>初学者学习python,抓取搜狗微信公众号文章保存到mysql mysql表中:代码:import requests import json import re import pymysql #创建连接conn = pymysql.connect(host='your database address', port =port, user='user name', passwd='password', db='database name', charset='utf8') # 创建一个游标 cursor = conn.cursor() cursor.execute("sel