探索代码Web数据源采集和分析系统

优采云 发布时间: 2020-08-08 20:182017年,Tanma Technology开发了一个大数据平台,用于金融行业的投资和融资交易. 在项目的早期,有必要为数据采集做准备并整理数据源,最后整理出许多需要采集的数据源. 为了确定数据源的数据量,是否有采集价值,采集价值有多大等,Probe Code Technology开发了一套Probe Code Web数据源采集和分析系统.

Web数据源采集和分析是对网站访问者行为的分析,包括网站访问量报告,电子邮件响应率,直接邮件活动数据,销售和*敏*感*词*,用户性能数据(例如,点击热点地图)或其他自定义需求信息等,然后进行行为分析,最后形成网络数据报告,以了解和优化网站;或爬网整个网站数据源信息,列,项目等以采集数据源,然后进行分析并形成信息数据报告,这些报告最终用于: 生成潜在客户列表;采集竞争对手要求的公司信息;捕获新兴业务数据;建立公司的产品目录;整合行业信息以协助业务决策;确定新客户,添加新订单;挖掘老客户以获取利益...简而言之,可以对网页上显示的内容进行采集和分析,以形成可视化的图像供企业使用.

搜索代码Web数据源采集和分析系统主要使用Ruby on Rails + vue.js + Bootstrap来实现数据源分析系统的后端和前端显示. 根据各个行业的需求,整体可以分为多个模块和各种形式进行可视化. 主要步骤: 1.从目标Web文档中获取要采集的信息; 2.确定要采集的信息类型是否为所需数据; 3.消除无用和重复的信息数据,并过滤和验证所需的信息数据; 4.保存所需的数据.

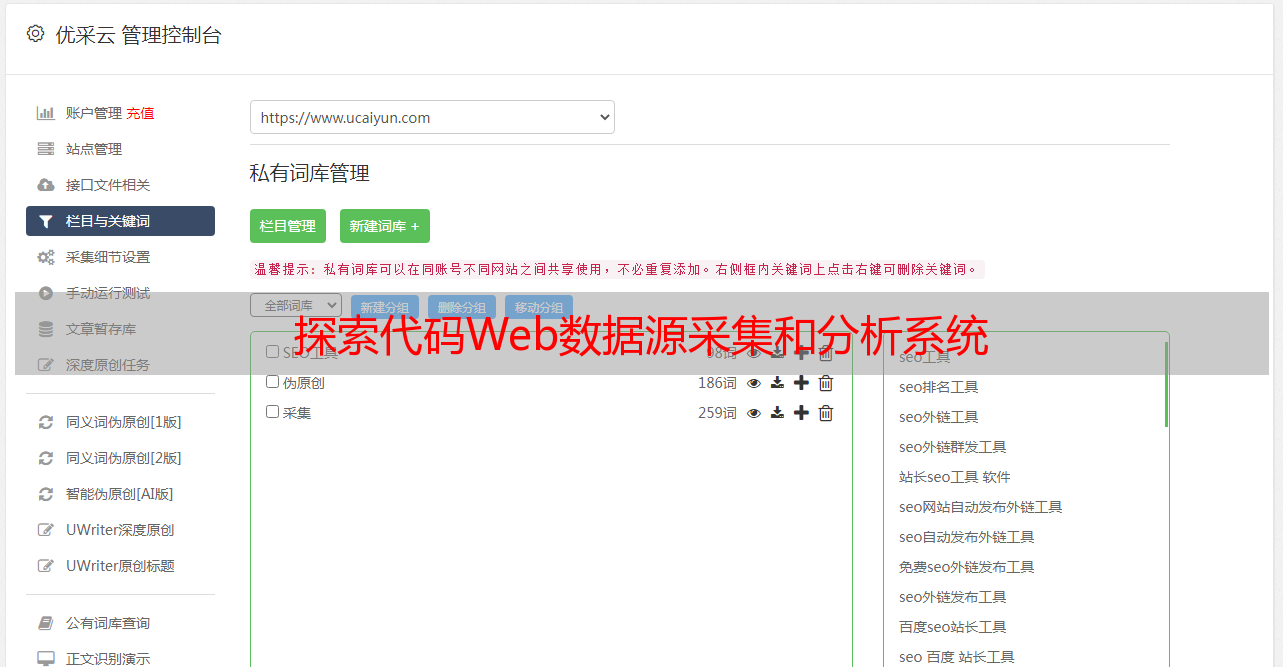

探索代码Web数据源采集和分析系统集合

其功能是使用云计算服务器协同工作以快速采集大量数据,而且还避免了计算机硬件资源的瓶颈. 另外,数据采集的要求越来越高,传统的邮政采集无法解决的技术问题也逐渐得到解决. 以Kapow / Dyson采集器为代表的新一代智能采集器可以模拟人类的思维和操作,从而完全解决了诸如ajax之类的技术问题,因为网页通常被设计为提供人浏览功能,因此可以模拟人的智能采集器非常有效顺利. 无论背景技术是什么,当数据最终显示在人的面前时,智能采集器都会开始提取数据. 最终,这使计算机的功能达到了极致,使计算机可以代替人工来完成Web数据采集的所有工作. 同时,大数据云采集技术被用于最大化计算机的计算能力.

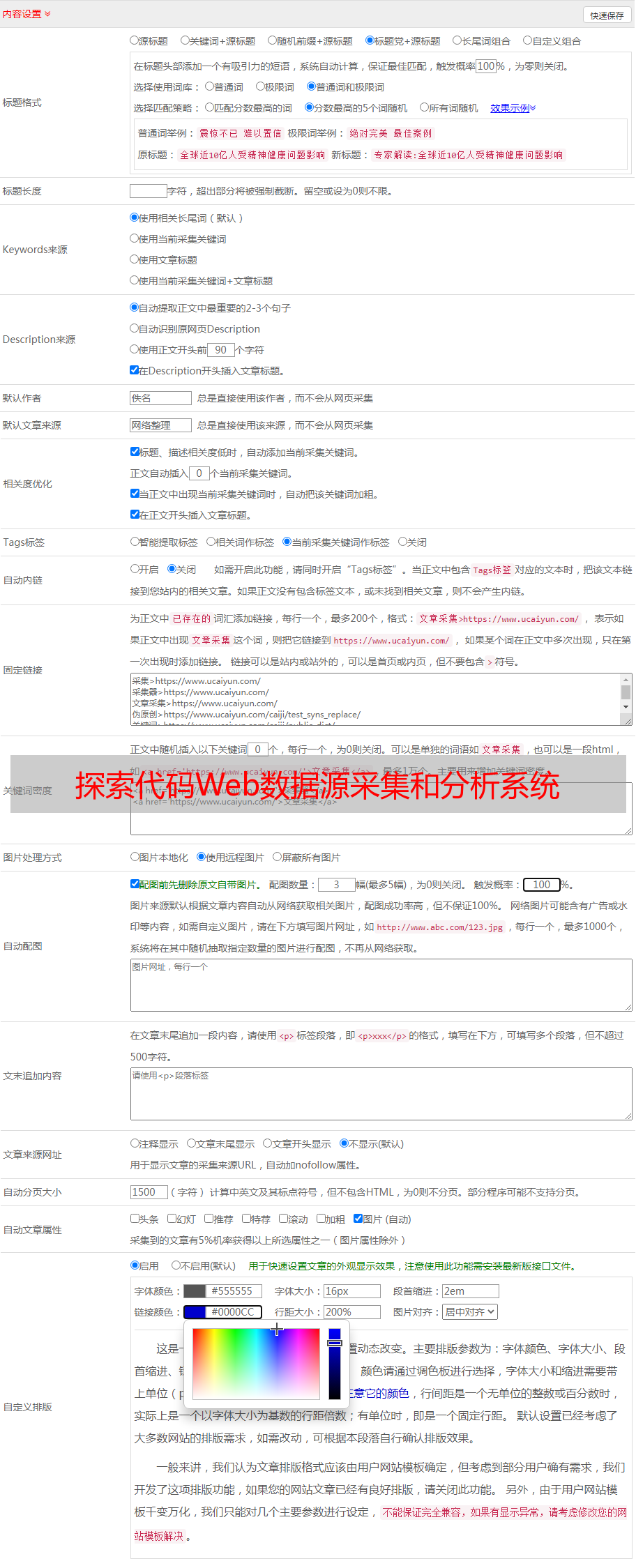

探索代码Web数据源采集和分析系统-分析

主要是通过对现有数据源进行分类和排序,列划分和字段分解以及对采集到的信息和数据进行智能分析来形成完整的数据源分析报告. 最后,通过对数据源的分析来发现数据,两者之间的关系,规律和取值范围为数据采用任务作了准备.

探究Web数据源采集和分析系统的优势:

1. 全方位采集

只要可以采集网页上可见的内容,则采集的内容数据包括文本,图片,Flash*敏*感*词*,视频和其他内容;

2,可以实现复杂对象的采集

文本和回复内容可以同时采集. 第一级页面和第二级页面的内容也可以轻松合并. 采集的内容可以分散在多个页面中,结果可能是复杂的父子表结构;

3. 采集速度比普通采集快

检测代码Web数据源采集分析系统采用尖端的先进技术,可以运行多个线程同时进行采集和采集,采集速度比普通采集快很多倍;

4. 精度高,覆盖范围广

只要可以在网页上看到内容,几乎所有内容都可以根据所需格式和所需信息数据采集.

5. 数据可视化,结果输出多样化

所采集的信息和数据可以通过TMDash可视化并呈现给企业,易于阅读和理解.

在互联网时代,先进的大数据,人工智能和深度学习技术已经实现了互联网平台的数据接口. 探测Web数据源采集和分析系统可以提供专业的数据采集服务,以准确地采集和分析所需的信息和数据.

注意: Web数据源采集系统的原理类似于搜索引擎的采集器,并且是合法的.