网站数据收集全攻略,轻松应对反爬挑战

优采云 发布时间: 2024-03-21 22:36身为一名熟捻的互联网资源搜集师,经过长期且丰富的实践磨砺,我已具备独特见解与深厚技巧,诚挚在此贡献关于网站资料收集的心得体会,助您更有效地收集必要信息。

1.确定采集目标

在着手采集前,明确定义您的核心需求。您须收集何种类型的数据?是否针对某些特定站点进行信息搜集?在确定目标之后,有助于更为精确地制定采集方案。

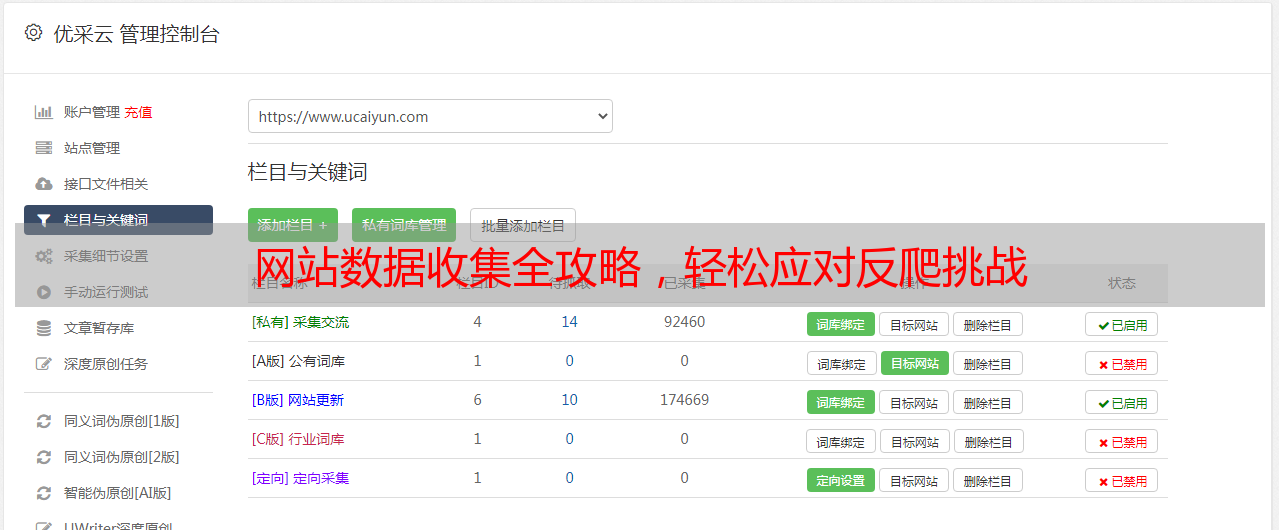

2.寻找合适的工具

运用得当的工具在采集过程中至关重要。当前市场上存在众多优质的采集工具,包括爬虫软件以及相关数据插件等。应依据自身需求与技能基础,挑选适宜的工具进行熟知及应用。

3.分析网站结构

在启动网站采集工作前,务必对目标站点进行全面剖析与研究,详细了解其架构及页面布局构造。掌握网站的组件构成、网址格式以及信息存取模式将有助于你更精准地设计采集方案,减免不当误差现象的出现。

4.制定采集规则

依据目标网站架构及所需,运用适宜的采集规则。此举需确定采集范围、定义筛选标准以及调控请求频率等。如此,既可提升采集效能,又能降低受封锁之虞。

5.处理反爬机制

众多网站为抵御爬虫而设立了如图码认证和IP访问限制等多项防范措施。而针对此类难题,您可运用代理IP及图像验证码识别等先进技术绕开反爬机制,保证数据搜集的顺利开展。

6.数据清洗与整合

在收集之后,数据须经过清理与整合方能用于进一步的分析和处理过程。去重、规范化、整合多源数据等环节,显得尤为关键。借助于专业的数据处理工具以及相应的编程语言,能实现上述作业的高效率运作。

7.高效利用API

除直接摘录网页源码外,亦可运用相应网站所提供之API接口来获取所需资料。经由API接口的调用,我们得以省去冗杂的页面解析工序,从而获取更为规范化且实时更新的数据资源。

8.定期更新与监控

鉴于网页内容易变,有必要定期开展更新与监控采集任务。精心设置适宜的更新周期,并对采集错误及异常进行及时修正,确保采集数据精准无误且时效性强。

关于网络采集的心得与技巧分享完毕,希望有所裨益于您在信息搜集领域的工作。切记,唯有掌握技巧并勤奋实践,方能成就卓越的网络采集者。祝您事业有成!