如何轻松实现批量采集和保存文章,五步教你搞定

优采云 发布时间: 2024-03-20 07:41如何实现批量采集并保存文章是许多人都关注的问题。作为网络爬虫工程师,在此提供专业方法——

1.确定采集目标

在开始采集前,必须明确所收集信息的来源及主题。例如,可选择权威性的新闻平台、知名博主的博客以及热门论坛等作为参考对象。一旦目标确立,即可开展相应的采集工作。

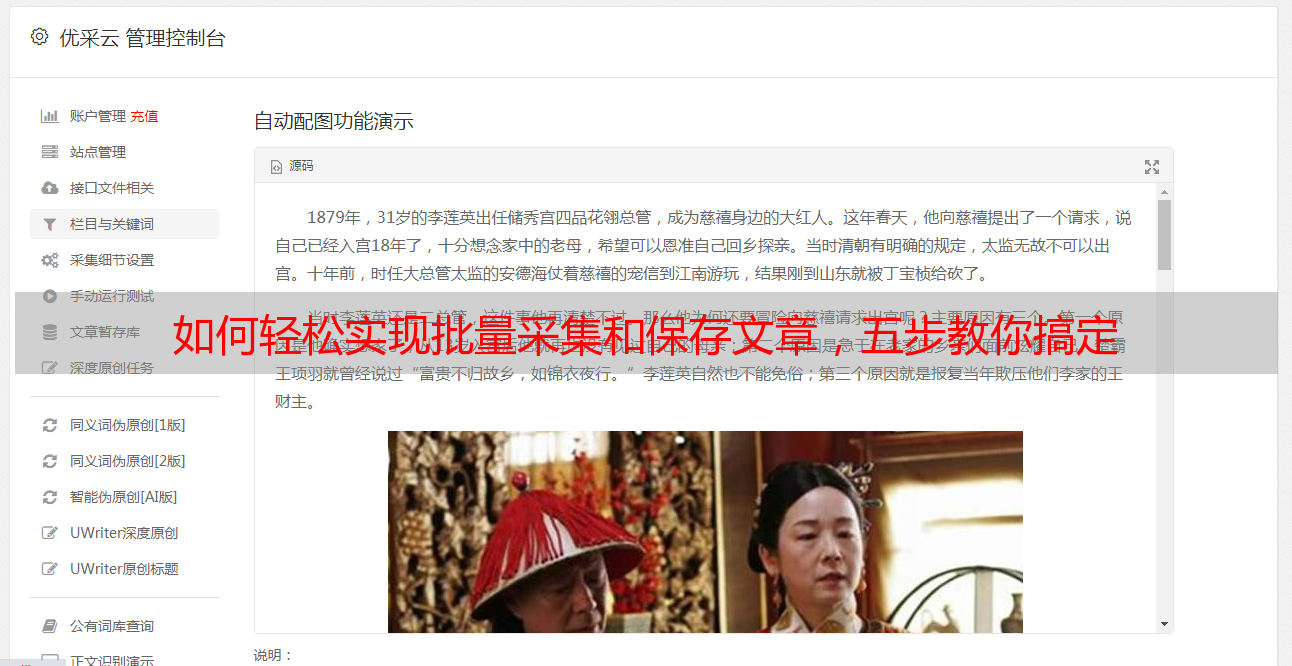

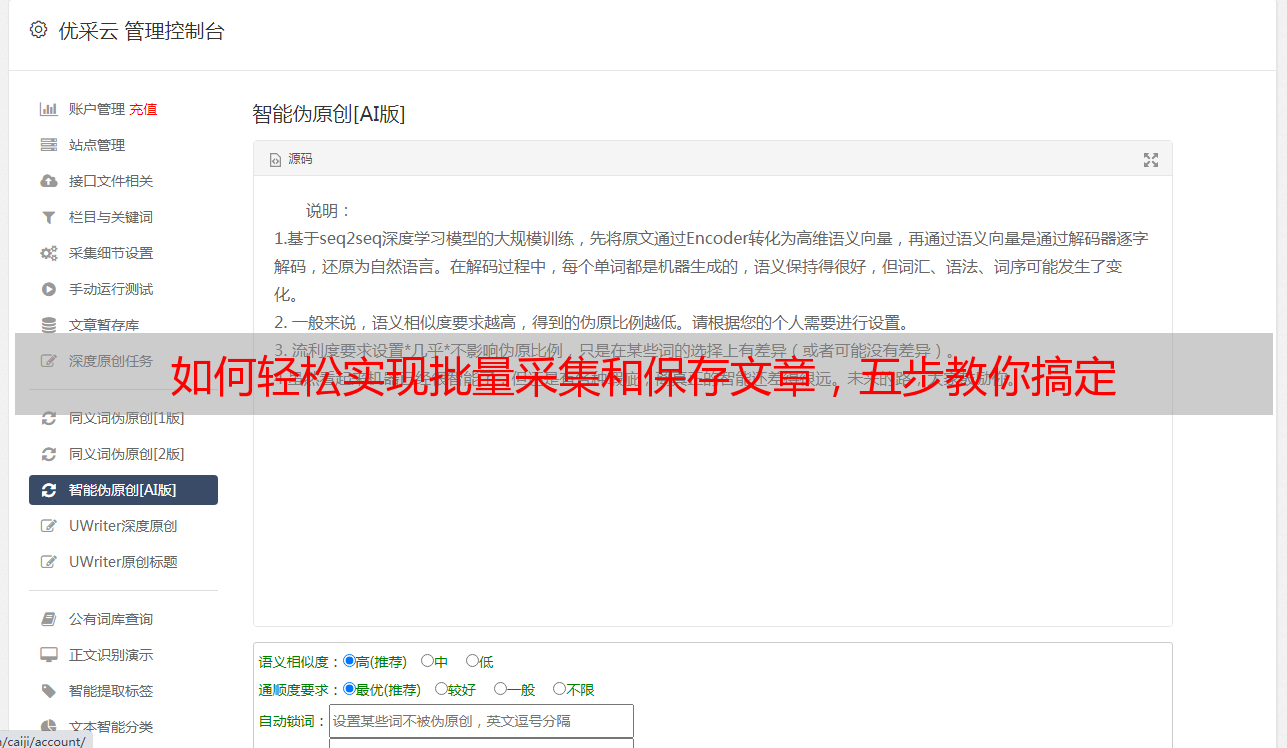

2.选择合适的工具

选取适当收集和存储文章的工具至关重要,建议参考众多开源爬虫框架,如Scrapy及Beautiful Soup等,依自身需求选择合适工具。

3.编写爬虫程序

在这之后,依据网络站点的构造及规律,运用特定软件编程实现批量抓取文章并进行存储工作。利用解析HTML制度、XPath、正则表达式等技术,提炼出所需信息,并保存在本地文档或者*敏*感*词*库内。

4.设置合理的请求频率

实施批量取样时,为减少对目标站点压力过大,必须注意设定适当频率。其方法有二:调整请求间歇时段与并发连接数量。

5.处理异常情况

在进行海量抓取和储存文章工作时,难免遭遇异常状况,如网络链接中断或页面解析故障。因此,有必要在程序内实施有效的异常处理策略,以确保运行的稳健性与可靠性。

6.定期更新和维护

定期更新与维护现有的采编程序至关重要,以应对可能出现的网站结构及规则变更。

7.遵守法律和道德规范

在进行文章批量采集与存储任务时,务必遵循相关法律法规以及道德准则,恪守原创作者权益,严禁侵害他人合法权益。同时,需运用合适的技术手法进行采集,以免对目标站点造成过多负荷。

本文将阐述有关于批量采集文章并储存的策略,以期为各位提供实质性的帮助。如您对此主题尚存疑虑或欲深入探索,敬请随时联系我们,感谢您的关注!