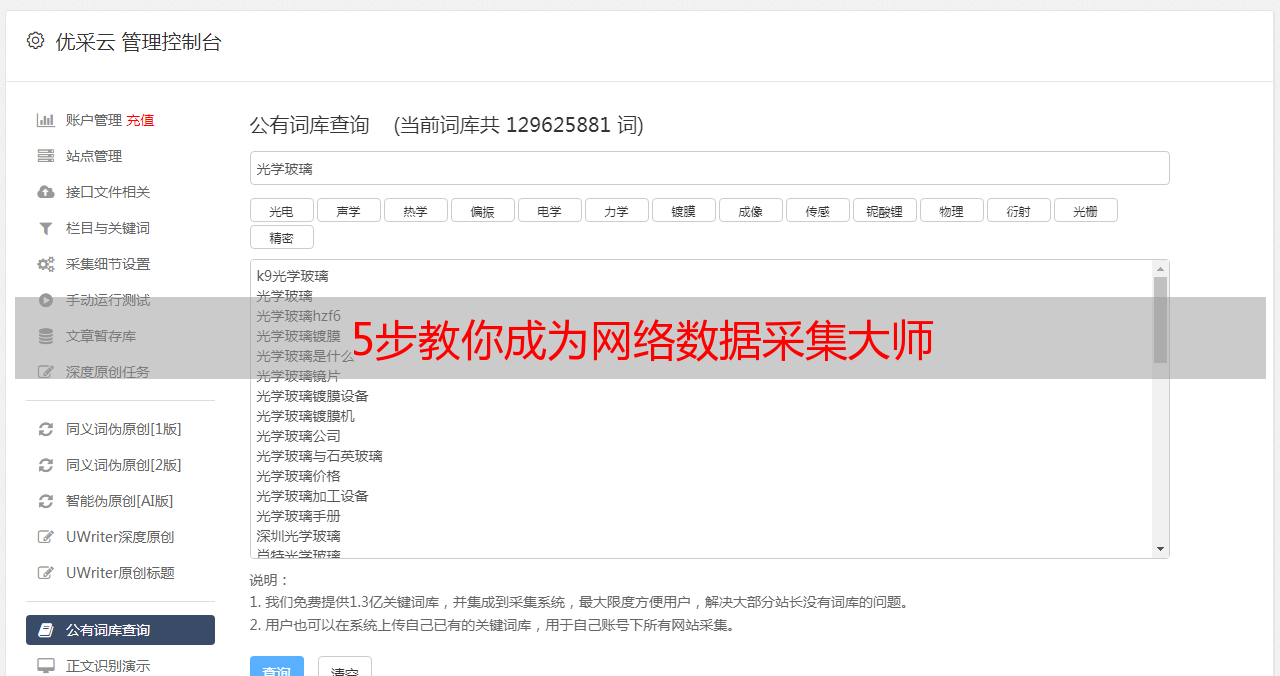

5步教你成为网络数据采集大师

优采云 发布时间: 2024-03-20 01:57掌握批量网页内容采集技术,对于专职于网络信息采集与处理者而言,至关重要。身为专业网络分析师,我在此领域历经多年磨砺,具备丰硕实践经验,现得以与各位同仁分享。

1.确定采集目标

采集中需先确立目标,如获取新闻资讯?收集市场数据?或学术论文?依照目标选择恰切的网页采集工具及方法。

2.选择合适的工具

市场上众多web数据采集器,其中以Python的BeautifulSoup及Scrapy为代表。根据实际需要与技术能力,选取适合的工具体验并精通操作方式。

3.设定合理的参数

网页采集作业中,需精心设计一系列参数,如采集深度与爬取速率等,以适应特定网站规模及我们的实际需求。确保合理设置这些参数可防止给目标站点带来过重负担。

4.编写爬虫代码

依据所需工具及预定参数,以严谨且结构分明的编程格式创立爬虫程序码。在程序编写中需保持统一性与可读性,同时务必处理可能出现之异常状况,确保数据收集的精准性与稳定性。

5.数据清洗和整理

在处理网页文本时,必须实施必要的数据清理及整理工作以提升其后续分析价值。此类工作包括运用适宜的科技及工具进行洗礼、去除重复项以及规范化数据的操作,从而显著提高数据的品质与可用性。

6.定期更新和维护

网络信息日新月异,因此,对采集系统定期进行更新及维护显得尤为重要。对获取的数据进行及时核查,解决潜在问题,并依据实际需求调整相关参数与代码。

7.遵守法律和道德规范

于网络数据采集过程中,务必严格遵循相关的法律法规及道德标准,保证对网站版权以及隐私权的充分尊重。严禁未经授权盗用他人信息及侵害其合法权益。

透过这篇七要点导览,我们希冀协助您在大批量网页摘取信息方面更为得心应手。唯有掌握精髓及实用技能,方能提升效率、保障数据精确性,从而于现代信息化环境下抓住更多机遇,迎接更大挑战。

注意事项:

请在理论分析、知识积累、实践经验以及客观事实等各方面展开论述,注意排除任何带有推销、推荐、营销、广告或宣传意味的文字表述。