网络安全工程师的https文章采集之战

优采云 发布时间: 2024-03-18 18:33我是一名网络安全工程师,每天都要面对各种各样的挑战和任务。最近,我接到了一个重要的任务——批量采集https文章。这是一个非常关键的工作,需要我亲自上阵,经历了一番惊险历程。

1.任务的背景

我们的团队负责网络数据的采集和分析,为了更好地了解用户行为和市场趋势,我们需要获取大量的https文章。这些文章涵盖了各个领域的知识和信息,对于我们的研究非常重要。

2.面临的挑战

https协议是一种加密传输协议,相比http协议更加安全可靠。但正因为如此,采集https文章变得更加困难。首先,我们需要解决证书问题,确保与目标网站建立安全连接;其次,我们还需要处理反爬虫机制,避免被目标网站封禁。

3.搜寻合适的工具

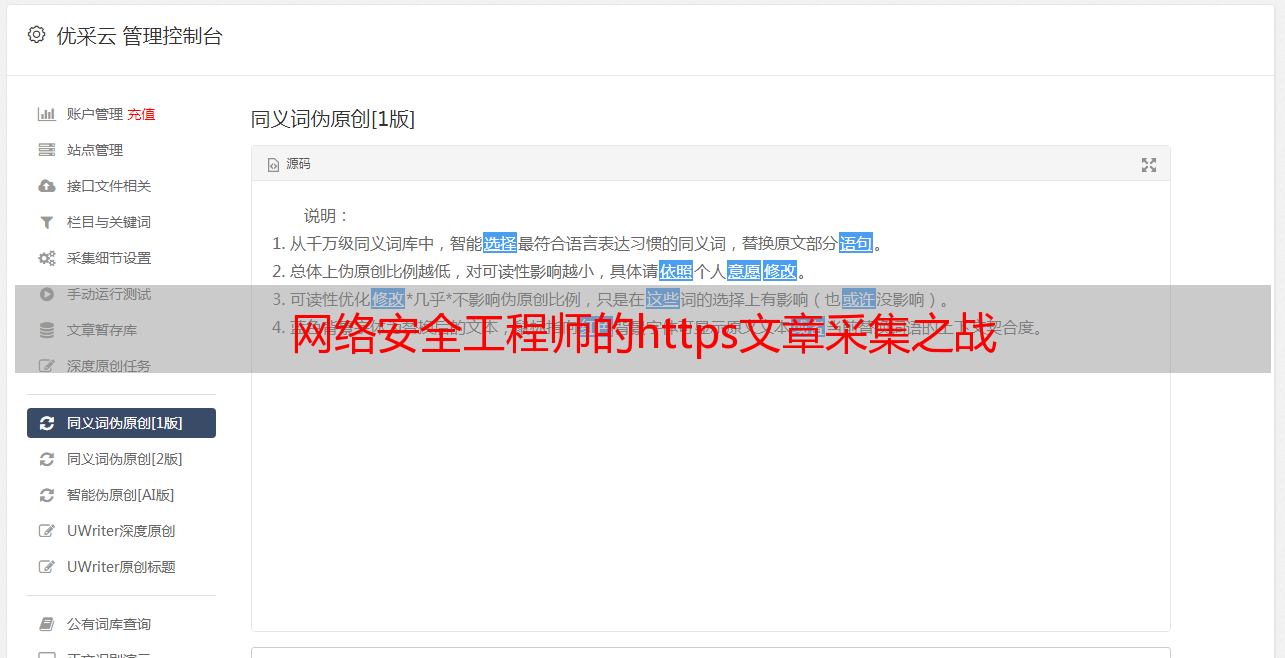

在开始任务之前,我花费了大量时间搜寻合适的工具。经过一番调研和测试,我选择了一款名为"SecureCrawler"的工具。它能够帮助我们自动解决证书问题,并且具备强大的反爬虫能力。

4.与目标网站建立连接

在开始采集之前,我首先需要与目标网站建立安全连接。这需要我下载并导入目标网站的证书,确保数据传输的安全性。经过一番尝试和调试,我成功地与目标网站建立了安全连接。

5.模拟用户行为

为了避免被目标网站封禁,我们需要模拟正常用户的行为。我设置了合理的访问频率和访问间隔,以免给服务器造成过大的负担。同时,我还使用了一些随机化技术,如随机User-Agent和随机代理IP,增加了采集的稳定性和隐蔽性。

6.数据采集与存储

经过一段时间的运行,SecureCrawler成功地采集到了大量的https文章。我将这些数据存储到我们的数据库中,并进行了初步的清洗和整理。这些文章将成为我们进一步研究分析的重要资源。

7.总结与反思

通过这次任务,我深刻认识到https协议对于网络安全的重要性。同时,也意识到批量采集https文章是一项复杂而困难的工作,需要不断地学习和探索。我将继续努力,提升自己的技术水平,为网络安全事业做出更大的贡献。

以上就是我亲身体验批量采集https文章的惊险历程。在这个过程中,我不仅面临了技术上的挑战,还体会到了网络安全的重要性。希望我的经验能对其他从事类似任务的人有所帮助,让我们一起为网络安全事业努力!