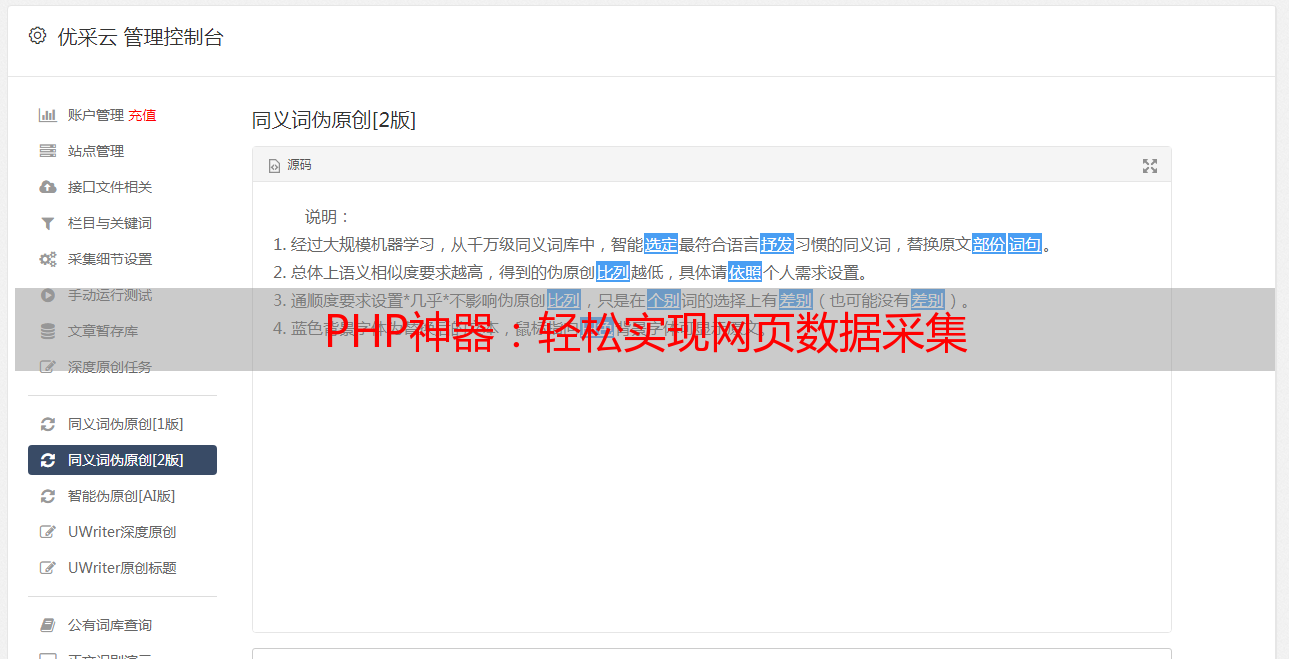

PHP神器:轻松实现网页数据采集

优采云 发布时间: 2024-03-18 01:50PHPs(即超级文本预处理程序)作为卓越且广泛应用的开源通用脚本编程语言,具备优异的网络开发能力。在此基础上,尤其在网页编程领域得到了极高的推崇,诸如信息取样等任务亦得以很好的执行。本文主要针对如何使用PHP实现文章内容的取样进行详细阐述与讨论。

一、使用cURL库进行网页抓取

cURL,一个具备丰富功能的网络请求库,利用其模拟浏览器Http请求来实现获取网页源代码的目标。借助此工具,我们可以有效地抽取目标网页关键内容和所需文章数据。

二、解析HTML源码

在深谙网页HTML源码后,我们需要对其进行深度剖析,进而抽取出所需文章的核心内容。在此过程中,可借用PHP中DOMDocument类对HTML文件进行精准解析,再通过XPath表达式正确定位并提取特定元素信息。

三、过滤和清洗数据

回收文本文档后,执行去除标签、消除无效数据及编辑文书格式等规范化步骤,以获得更整齐有序的文档形式。

四、处理异常情况

在数据采集实践中,不可避免地会遇到诸如网络延迟超时或页面不存在之异状。为保障系统高效运作,需在编程环节嵌入完备的异常处理策略。

五、定时采集

借助 PHP 的定时任务技术,便可轻松实现在特定时间采集文章内容的需求。此技术提供了自动设置控制器周期的能力,方便完成文章采集工作。

六、存储和展示

文章资料可以采集并存储于数据库中作进一步的精细处理及展示;同时,借助PHP模版引擎,这些文章也能成功实现个性化的表达和呈现。

七、注意法律合规

在采集学术资料时,必须遵守相关规定,确保对原作者的合法权益进行充分尊重。严禁将他人作品用于任何形式的商业盈利或造*敏*感*词*身财产损害行为。

八、关注网站反爬虫策略

在网络发展的大背景下,反爬虫策略已然成为众多网站的必备安全防护手段,防止非法访问和数据搜集。对于文章采集工作而言,必须遵循相关网站规定,最大程度减轻对其产生的不必要压力。

本文深入探讨PHP技术在文章内容采集方面的实践与策略,旨在服务广大用户。对于此领域的任何疑惑或者更深度的交流需求,请随时和我们取得联系。