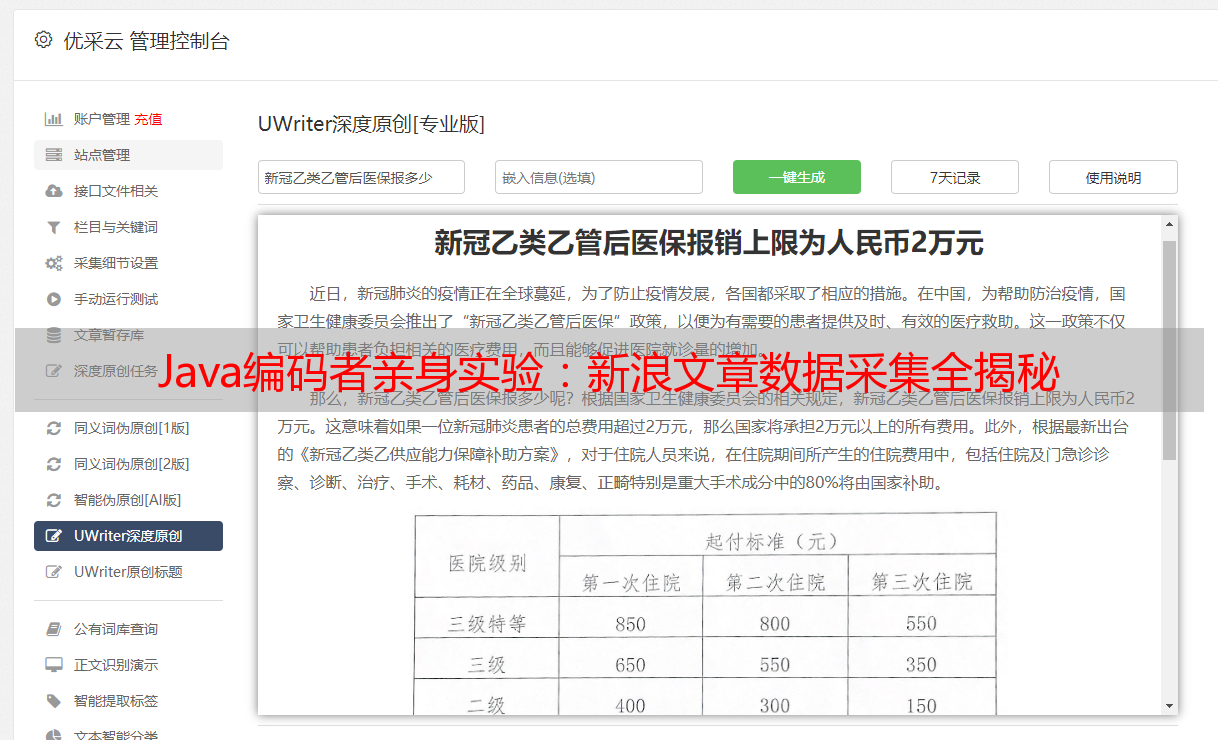

Java编码者亲身实验:新浪文章数据采集全揭秘

优采云 发布时间: 2024-03-14 01:53java采集新浪文章,我亲身体验了一次

随着当前互联网高速发展,我们对于信息获取的倾向已逐渐转向网络。作为一名编码者,我对网络数据采集和处理充满热爱。最近,我利用Java技术成功地从新浪网收集文章资料,进行了详细的数据分析及加工工作。在此过程中,我深深体会到了这种语言在数据抓取方面的出色表现和高度灵活性。

1.背景介绍

新浪网乃我国综合性门户翘楚之一,信息丰富多元,覆盖新闻、娱乐和财经等领域。我们期望通过收集其网站上的各类文章,掌握关键信息如文字内容、发布时间以及作者等以供随后的数据分析与挖掘使用。

2.选择合适的工具

首先选择合适的数据采集工具,由于Java在网络编程领域具有明显优势,故拟以此作为基础构建网络抓取工具以便实现预期目标。

3.分析网页结构

为开展爬虫编程项目,我们须先深入研究并充分理解新浪网站的结构布局。通过对源码的细致解读和开发者工具的运用,发现其正文信息被包含于HTML标签内,每则激活的文字皆具有对应的 URL 超链标志。

4.使用Jsoup库进行网页解析

为精炼网页内容分析,采用尖端的Java HTML解析器Jsoup应对HTML文件作业。它既具备免费开放的性质又展现出极高的效率,让我们轻松获取网页中的各种关键元素,例如此文主题、内容与发布日期等信息。

5.编写爬虫程序

在精细的网页分析和工具精选之后,便着手进行了抓取爬山蛇的编码阶段。借助Java网络协议,可以轻松调用HTTP请求与获取HTML页面;随后利用强大的Jsoup库对HTML进行深度解析,分离出重要信息以供储存或后续使用。

6.处理反爬机制

针对防范爬虫工具极可能引起的网站负载过高之虑,大量网站采取了反爬措施。对于设计爬取程序的过程中,必须保持严谨态度尽量规避此风险。建议采用讲究请求时间间隔以及模拟人类真实访问习惯等方法降低频繁访问可能引发的威胁。

7.数据存储和分析

我们对收集到的资料进行存储,以便将来深度加工使用。为了更好地实现这一目的,我选择把MySQL视为数据的核心存储区。在Java提供的JDBC帮助下,我们能够以高效便捷的方式将数据导入,同时也可以迅速检索查找。通过对收集自新浪网络文章内容的分类和分析,我们能明确各类别文章受到的瞩目程度以及它们的演变趋势。

8.异常处理和日志记录

在数据获取环节中,突遇网络连线中断或网页解析失误等意外状况不可避免。为保证系统顺畅运作和数据安全可靠,需建立完善的异常情况处理机制,并准确记录日志记载以便快速查找并解决潜在隐患。

9.总结与展望

通过亲身实践,我深刻领悟到了Java数据采集的高效性与灵活性。凭借其丰富的网络接口和强大的第三方库,数据采集得以简化且高效执行。今后,我会更加努力学习和应用Java在数据处理方面的知识,以便更好地支撑各类数据分析需求。

10.参考资料

建议访问jsoup官网,网址为https://jsoup.org/。

《Java8 API参考手册》全面权威,官方信息查阅地址:https://docs.oracle.com/javase/8/docs/api/。

这次实验实训让我更充分地领悟到Java在抓取新浪新闻中的价值。凭借众多灵活实用的工具和框架,Java使数据搜集变得高效精准。编写爬虫程序不仅可以迅速把握新浪网文章动态,也能够对获取到的信息进行深层次分析和处理。这一实践进一步加深了我对Java在数据研究领域应用的信心,同时也诱发了更深的探究欲望,期望能为喜爱数据采集的人群带来深远影响。