零基础教学!打造自动文章采集网站,从需求到实战经验一网打尽

优采云 发布时间: 2024-03-12 11:23在长达数年的网络技术实践过程中,我曾面对一项挑战性的任务,即打造一款自动化文章采集网站。这让我有机会分享自己的实战经验与心得体会。

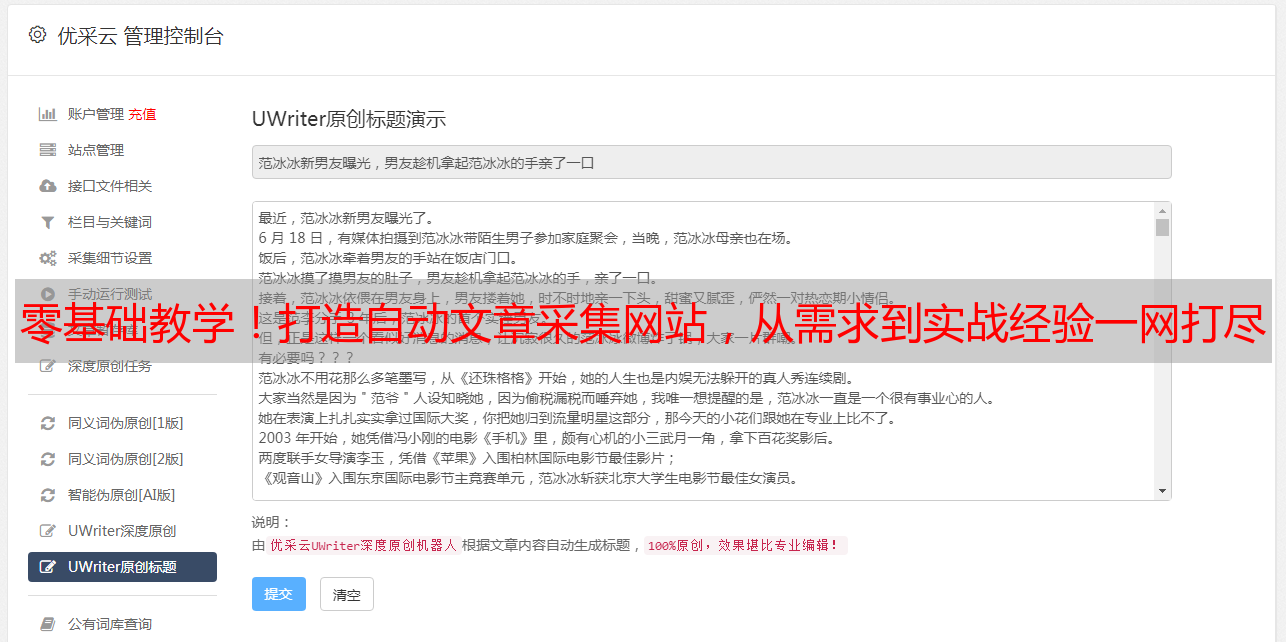

1.确定需求

研发之初,须先把握需求本质。需坚持你欲收集之文章及其所需领域节点尽在掌控之中。此环节需详知目标网站布局及规矩。

2.寻找合适的工具

要实现在线文章自动化采集,可用Python编码编写爬虫软件,或者借助现有的Scrapy等爬虫框架,抑或是采用第三方API或插件等方式进行。

3.编写爬虫程序

依据需求和精选之编撰工具,我们引启动步开发爬虫程序。该程序需具备自动查询目标网站、解析网页架构、抽取关键字段以及将信息储存至数据库或者档案中的功能。

4.处理反爬机制

诸多网站均设有防护策略以规避文章被爬取行为。为获取文章数据,需妥善应对此类措施。可采用使用代理IP、定制请求头部及模拟登录等方式进行处理。

5.定时任务和增量采集

为确保文章信息的前沿性,可采纳设定定时任务的方式,周期性运行采编软件。此外,为防止已经采集过的文章再次被采集,推荐采用增量采集模式。

6.数据清洗和处理

在采集过程中,所获取的数据可能包含噪音及非标准格式因素,此时进行数据清洗显得尤为必要。可以运用常规的正则表达式技术以及专门的字符串处理函数来实行有效的数据清理与规范化操作。

7.界面设计和用户体验

除了卓越的功能性外,优质的网站还需关注界面设计与使用者体验。实施精良的页面布局,搭载实用的搜索及排序功能,皆可显著提高使用者参与度。

8.监控和维护

网站启动后,应加强监控与维护工作,确保正常运作,如定期检查采集任务状态,应对异常状况,同时根据用户反馈调整站点功能以持续优化服务体验。

以下为8点专业经验分享,设计实现的过程需步步深入,方能开发出具备强大功能、卓越用户体验的自动采集文章网站。请坚信,成功离您并不遥远,只需坚持不懈的努力,便可收获丰硕成果。