信息泛滥时代:如何高效处理大批量网站文章采集?

优采云 发布时间: 2024-03-05 15:51随着网络环境的加速进步,我们已然步入了信息泛滥的时代。面对此种境况,新闻传播界面临着如何高效执行大型网站文章采编工作这一难题。为此,本文将针对利用已有技术及工具,高效处理大批量网站文章采集问题展开论述。

1.网站选择:

实施大型网站文本搜集前,首要任务是挑选采集中即定目标网站。依据所需信息类别以及覆盖程度,甄别合宜的新闻媒体、行业消息及专家博客等站点作为数据源头。与此同时,以权威性、可靠性为考量,同时选取内容丰富的网站,以便保证所捕获的文章具备高品质。

2.数据抓取:

数据抓取乃是针对大量网站文章实现批量采集的重要环节。运用爬虫技术,可实现对目标网站的自动化抓取,从而获取所需文章资讯。然而,实施此过程之际务必遵守相关法律规定及职业道德准则,以保证合规性以及尊重网站主人的权益

3.数据清洗:

若*敏*感*词*网站文章采集产生了大量噪点及冗余信息,则这些数据必须经过精密清洗及整理,剔除无效成分,完成数据格式转化的过程。如此一来,后续数据处理将提升速率与精准度。

4.数据存储:

对于大型资讯采集平台,恰当地选取数据管理模式至关重要。可选用数据库、文档系统乃至云储存等各项先进技术以实现信息管理。此外,应严格重视数据安全及定期备份工作,保障信息之稳固可靠以及易复原性。

5.数据分析:

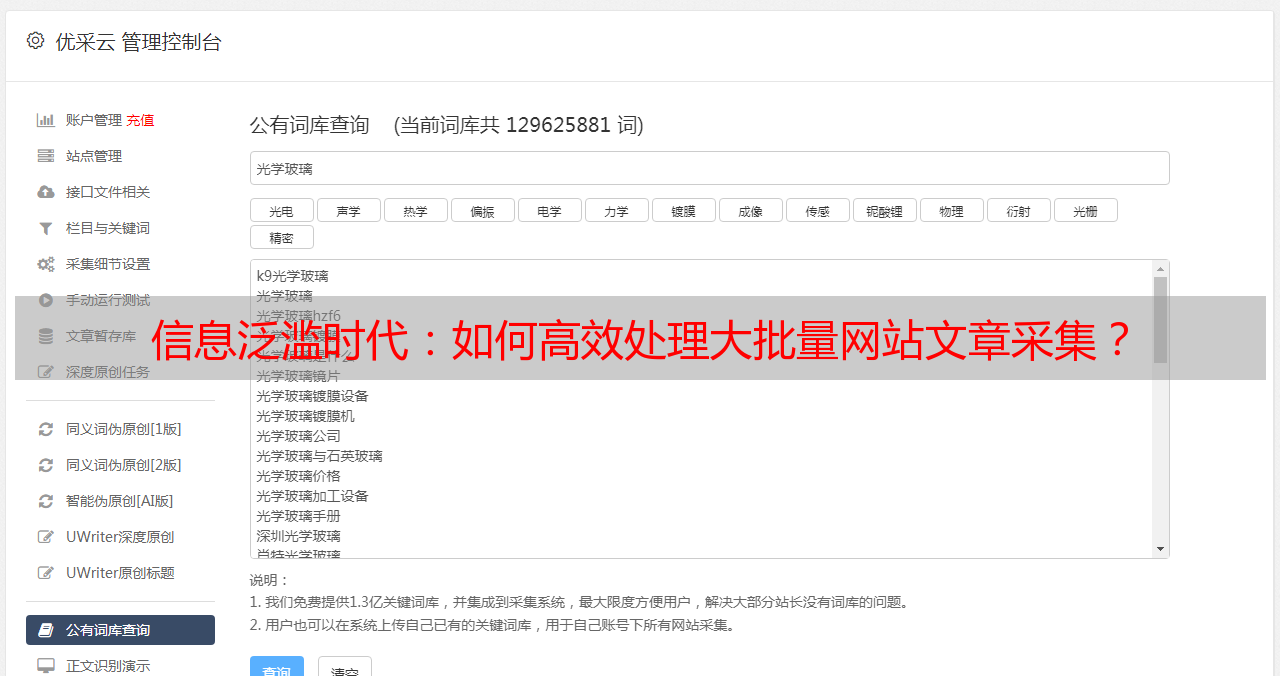

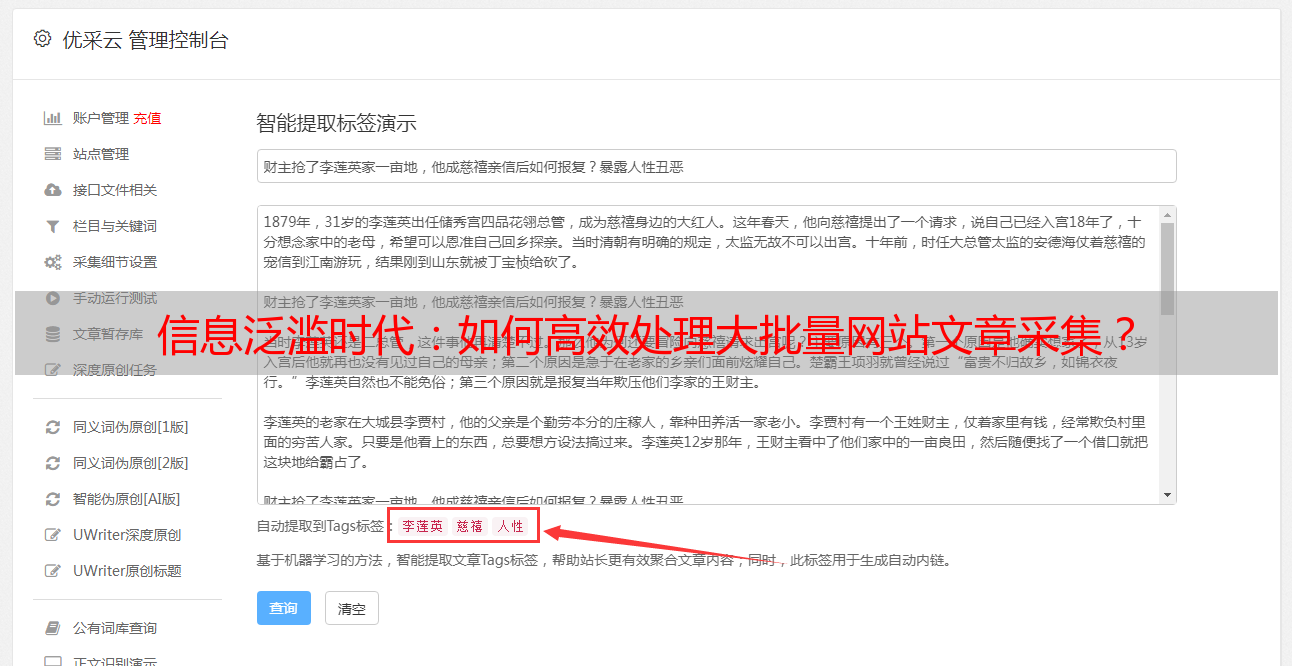

海量文章素材可广泛应用于各类分析与研判。运用诸如文本发掘以及机器学习这一类尖端科技手段,完成文章情感剖析、主题甄别及关键词抽取等任务,从而实现深度洞察和多重价值。

6.定期更新:

鉴于网站内容的持续更新,需定期进行文章收集以保证数据时效性。可通过设置定时任务或者采用增量抓取技术,迅速收录新发布文章并与既有数据进行汇总与更新操作。

7.人工审核:

虽然自动化采集技术能提升效率,但是人工审查仍不可或缺以保证文章质素。这项工作有助于文章的过滤、去除重复及修改,从而增强数据的准确性与可靠性。

8.合规管理:

在开展*敏*感*词*网络文章采集活动时,必须恪守相关法律法规及道德准则,维护知识产权和他人隐私权。此外,需建立有效的合法合规管理体系,及时调整采集策略以应对法规变动。

9.技术创新:

随着科技进步,网站文章采集方式也在逐渐转变,最新关注点为数据抓取、分析以及人工智能等领域。这为寻找更为高效、智能化的网站文章采集解决方案提供了可能。

经过深入剖析上述九项要点,我们有信心让每位读者熟练掌握高效完成网站文章大范围采集的方法。愿这些经验对传媒业及需进行网站文章采集的工作者有实质性的启发和帮助。