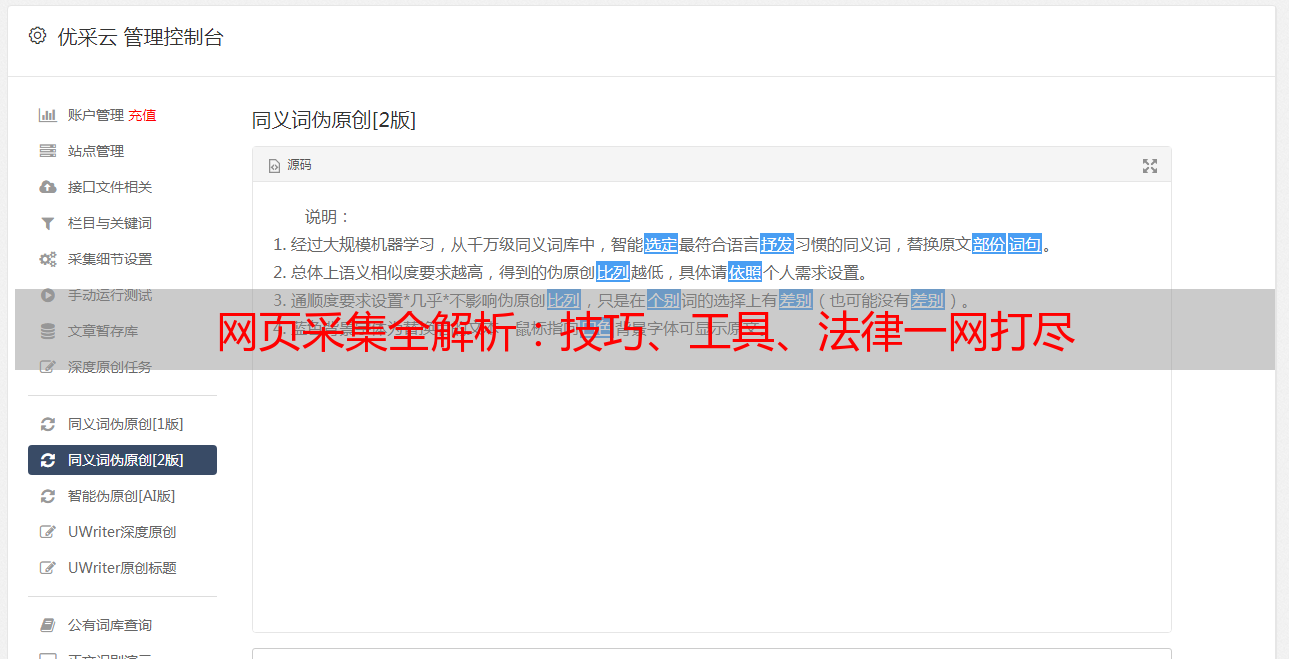

网页采集全解析:技巧、工具、法律一网打尽

优采云 发布时间: 2024-03-03 09:55身为资深网络采集专家,我会详尽介绍网页采集领域的知识与技巧,为您解疑答惑,助力实现优质的网页采集。

1.什么是网页采集?

网页采集即利用自动化程序,实现对互联网信息的抓取与整合,将其转化为结构化数据以便后期分析、研究及运用。此举可迅速获取海量数据支持各种用途实践。

2.网页采集的应用领域有哪些?

网上信息搜集作为重要工具在各行业中均广泛运用,如市场调研、竞业情报、舆论监督及数据解析等方面,有效协助企业完善决策制定、推动公司业务拓展。

3.网页采集的工具有哪些?

网页采集工具多样化,其中包括Python内置的BeautifulSoup及Scrapy,以及专业级的爬虫软件如Octoparse和WebHarvy等。用户可根据自身需求与技术能力挑选合适的工具进行使用。

4.网页采集需要注意哪些法律和道德问题?

网页采集需恪守相关法律法规及道德准则,严禁采集个人隐私信息或侵犯他人权益,避免恶意采撷网站内容引发对服务器的过度负荷。

5.网页采集的技巧有哪些?

为提高数据搜集的效率与精确度,可采用代理IP技术、设定恰当的请求头部信息并应对反爬虫规则等方法。此外,需科学设计搜集频次,确保不会对源网站造成过度压力。

6.如何处理网页采集中的异常情况?

网页采集过程中常遇困境众多,如网站结构变更、页面加载延迟以及验证实码输入等。为解决上述问题,可采取以下措施:更新采集规范、适当延长等待时间以获取信息以及利用校验码自动识别软件等手段。

7.如何处理网页采集中的数据清洗和去重?

采集所得数据常含噪声与重复要点,需行数据清洗及去重操作以优化分析结果。此过程中,可借助正则表达式与字符串处理工具完成数据清洁工作;利用数据库之惟一索引特性实现数据去重任务。

8.网页采集有哪些常见错误和解决方法?

网页采集过程中,链接超时及页面解析错误是常见问题。通过延长超时时间、核实网络连通性以及调整解析策略等手段可有效应对上述误差。

通过本篇文章的解读与答疑,相信诸位对网页采集已有更加精准的认识。期望各位在操作中能遵守法规,有效运用采集资讯,以提升自身的工作效益及科研成果。