软件采集大揭秘:如何保护你的劳动果实?

优采云 发布时间: 2024-03-02 05:37互联网时代,软件采集酿成普遍问题,大量劳动果实遭恶意窃取与滥用,对原创作家造成严重损害。为保护知识产权及保障公平竞争环境,我们需剖析软件采集的内在奥秘,并提出相应对策。

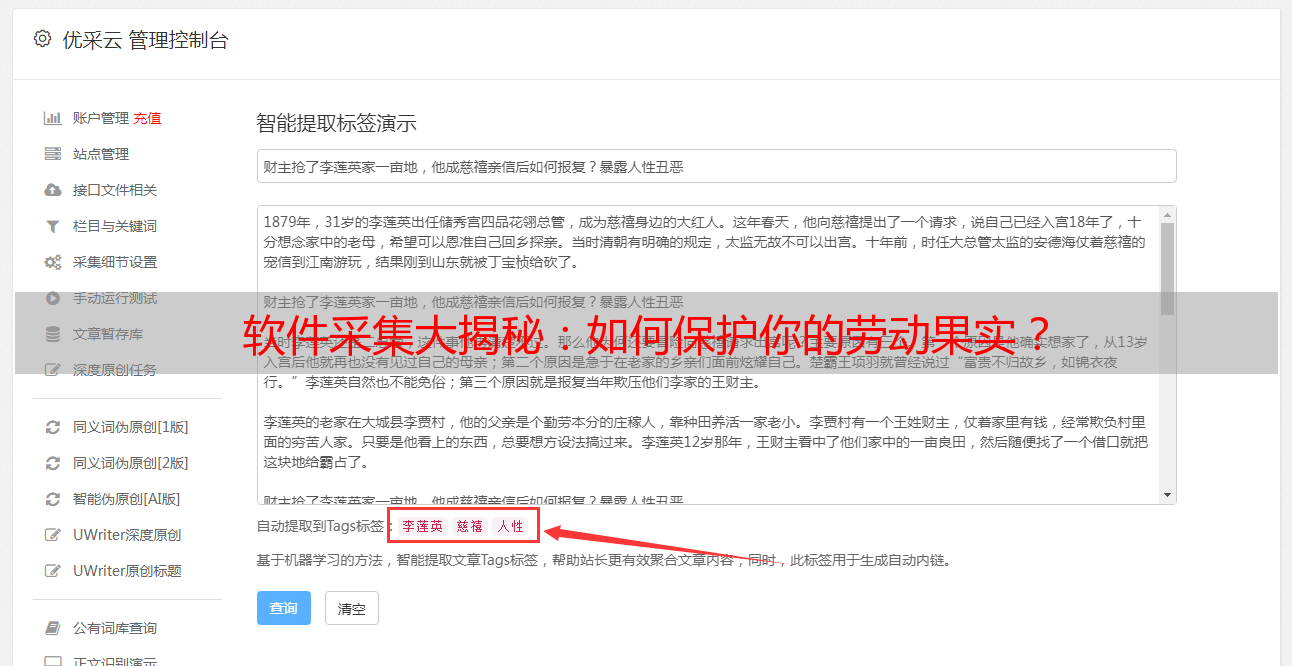

一、了解软件采集的工作原理

利用网络爬虫技术,软件采集可自动在互联网中搜集大量数据。此类程序采用模拟浏览器之交互方式以及分析网页源代码,以此提取所需的信息然后存入数据库。深入理解此过程,能协助我们定制出有效的防御措施。

二、优化网站结构和代码

透过科学制定网站布局及优化编码技术,能够提升软件收集信息的困难度。例如,精确运用HTML标识符、CSS外观与JavaScript脚本,能切实防止爬虫自动抓取页面内容。

三、使用验证码技术

验证码技术以其有效性常用于规避软件收集行为。通过在网站上添加验证码功能,要求访问者进行手动操作,达到防止自动爬取程序骚扰的目的。

四、限制频繁访问

高速度的软件采集往往对网站造成不利影响。为减缓此类影响,可实施访问频率限制策略,比如设定IP访问极限范围、限制每小时请求次数等多种措施。

五、使用反爬虫技术

反爬虫技术主要针对软件自动采集进行主动防御。比如,通过分析用户操作与行为特征,以及洞察爬虫程序特性等途径,实时预警并阻止爬虫程序的侵犯。

六、加强版权保护意识

作为作者,应具备较高的版权保护意识,熟悉且遵守相关法律法规,在作品中增加版权声明并安装必要的保护措施。对于未经许可擅自使用本人作品者,应当毫不犹豫地拿起法律武器捍卫自身合法权益。

七、定期检查和更新安全策略

伴随软件采集技术的进步,防范措施亦应与时俱进。定期审查并升级安全策略的举措实为捍卫对抗软件收集之力的重要一环。

八、加强合作与信息共享

针对软件采集问题,建立协作与信息共享机制至关重要。通过与其它站点和社区的协同工作,可构筑起有效防御。

深度剖析软件采集运作机制,优化网站架构与编码方案,运用验龄验证码,控制频率访问,采用反爬虫技术,强化版权保护观念,定期审视并升级安全防护措施,同时寻求与各方的密切协作及信息流通,将有助于更有效地防范文章被抄袭行为,捍卫个人智慧财产权。在此基础上,我们希望全社会能协力营造公正竞争的互联网生态环境。