数据分析师*敏*感*词*教你:如何高效采集海量文章?

优采云 发布时间: 2024-03-02 05:14身为资深数据分析师,日常繁琐工作包括处理大量数据。工作重点之一便是从大量文本资料中收集文章并以电子表格格式妥善保留。今日,特此与诸位分享我个人对此步骤的深刻体会。

1.确定采集目标

在正式展开采集工作前,必要条件是明确所需采集的文章类别及来源。通常我会集中选取相关专有领域文章进行搜集,途径包括各类网站、博客以及论坛等,以此保证获得最全面且精确之资讯。

2.设计数据结构

初采之始,必先确立所存储之数据结构。此举涵盖确定文档所需保留之关键字段及其格式、各字段间关联等细节,以便于日后数据解析与处理。

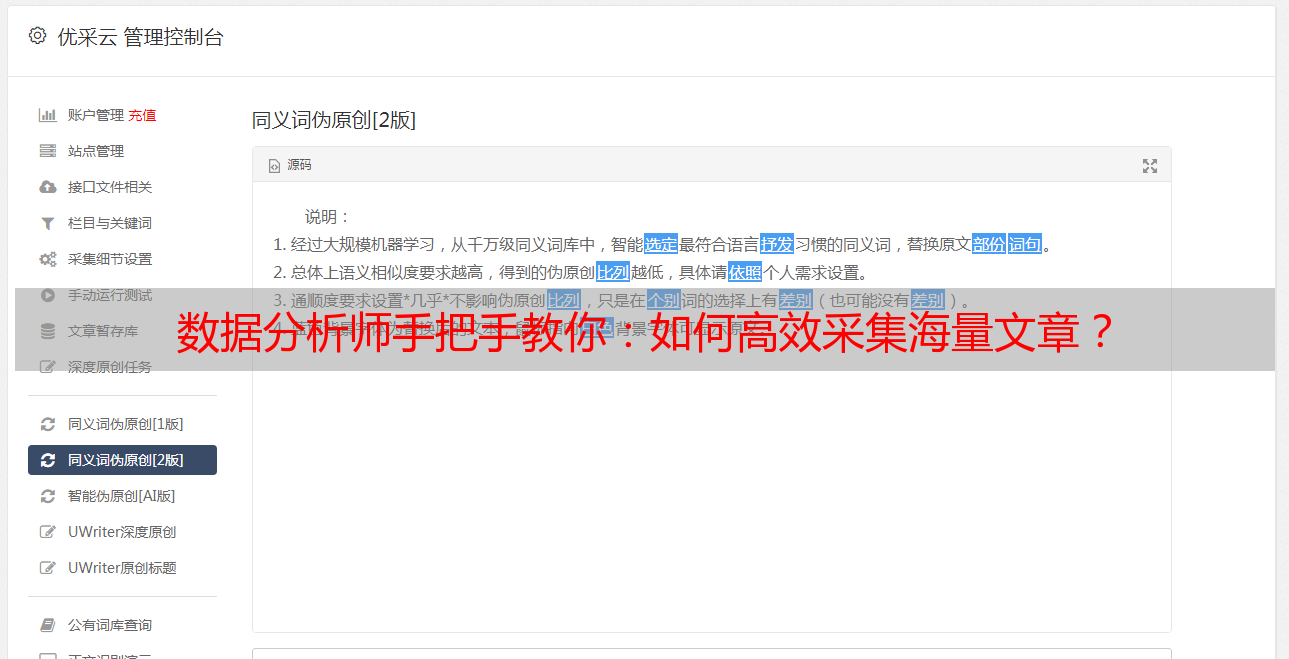

3.使用爬虫工具

为了高效率地获取大批量文章数据,我采用了爬虫工具。它能自动访问网页并抓取相关信息。通过设定适当的规则与参数,我能够迅速抓取海量的文章,并将其保存至本地档案。

4.数据清洗与处理

为提高文本数据质量,避免噪声干扰及信息缺失现象,应采取有效的数据清洗与处理措施。此过程主要包括去除冗余数据、填补空缺值以及格式化数据等步骤,确保最终得到高品质、有意义的数据集以充分发挥其应用价值。

5.导入Excel

清洗及处理工序完备之后,便开始将数据引入Excel文档之中。通常,我会运用Python程序设计语言中的pandas模块进行此项工作。通过简明的程序指令,我得以按照既定格式将数据载入至Excel文件内。

6.数据分析与可视化

在导入Excel表格后续,我将展开深入的数据监测及可视化处理。借助Excel所内置的诸*敏*感*词*与图表,可更准确地把握以及展示各类数据。这有利于在分析文本过程中获取关键信息,进而作出合理抉择。

7.定期更新

伴随着时间流逝且新内容层出不穷,旧文章亦面临修订。故而,定期提升采编任务势在必行,以确保获取最新的、准确无误的文章信息。

8.数据备份与安全

身为数据分析专家,我高度关注数据安全性。因此,在将文章导入Excel后,我会适时进行全面备份,同时实施严格防范措施,确保持续性数据存储,防止任何形式的数据损失与泄露。

9.不断学习与改进

在将文本内容转换成Excel文件时,我始终在坚持不懈地提升自我技能。通过与业内人士的深入交流,参与专业课程培训,以及研读相关专业文献,我不断强化了自身的数据处理及分析能力,从而能更有效地应对各类日益繁杂的数据需求。

实践所得,我深知采集并保存文本至Excel之重要性及挑战所在。唯有掌握精准方法与技巧,方能高效提取并处理海量文本信息。期待我的经验能在您从事数据分析过程中提供助益!