网络异常大揭秘:数据采集的痛点和应对之道

优采云 发布时间: 2024-02-28 23:29本篇评析针对对比风格,深入剖析采集文章网络错误产生的机理及影响因素,并从理论、学识、实践和实证等多维度探讨解决对策。我们致力于为广大读者提供翔实具体且针对性实用的参考建议。

一、问题背景:

网络异常即网络通信过程中出现的各类故障,包括页面加载延迟和链接无法访问等问题。此类状况对采集文章构成巨大挑战,用户体验亦受到了不良影响。

二、问题原因:

网络环境欠佳:网络延时及带宽制约导致数据传输受限。

服务器负荷过重:由于网站服务器超载,导致其难以迅速响应当前请求。

注意,部份网站为防恶意采集,设立了反爬虫措施。

三、问题影响:

数据精度问题:网络故障导致部分数据采集缺失,影响了其全面性及精准度。

数据采集受限:频繁的网络异常影响采集作业进程,造成时间及资源上的消耗。

用户体验受限:由于网络问题频发,数据采集工作受到影响,用户无法及时获取所需信息,从而降低其使用满意度。

四、解决方法:

改善网络条件:保障网络畅通无阻,通过提升带宽及缩短延迟等手段加以优化。

2.增加服务器容量:提升服务器性能,增加处理请求的能力;

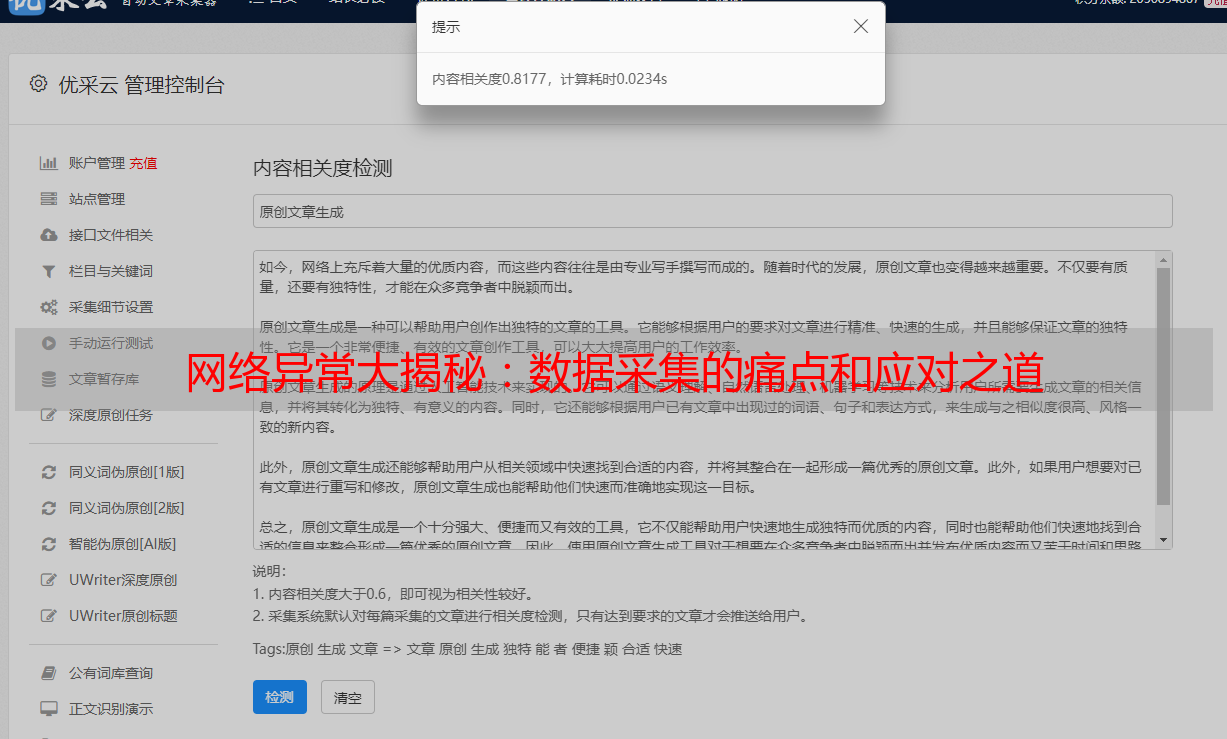

制定严谨的爬虫策略:规避网站防爬措施,科学控制请求速率及时间间隔等参数。

五、经验分享:

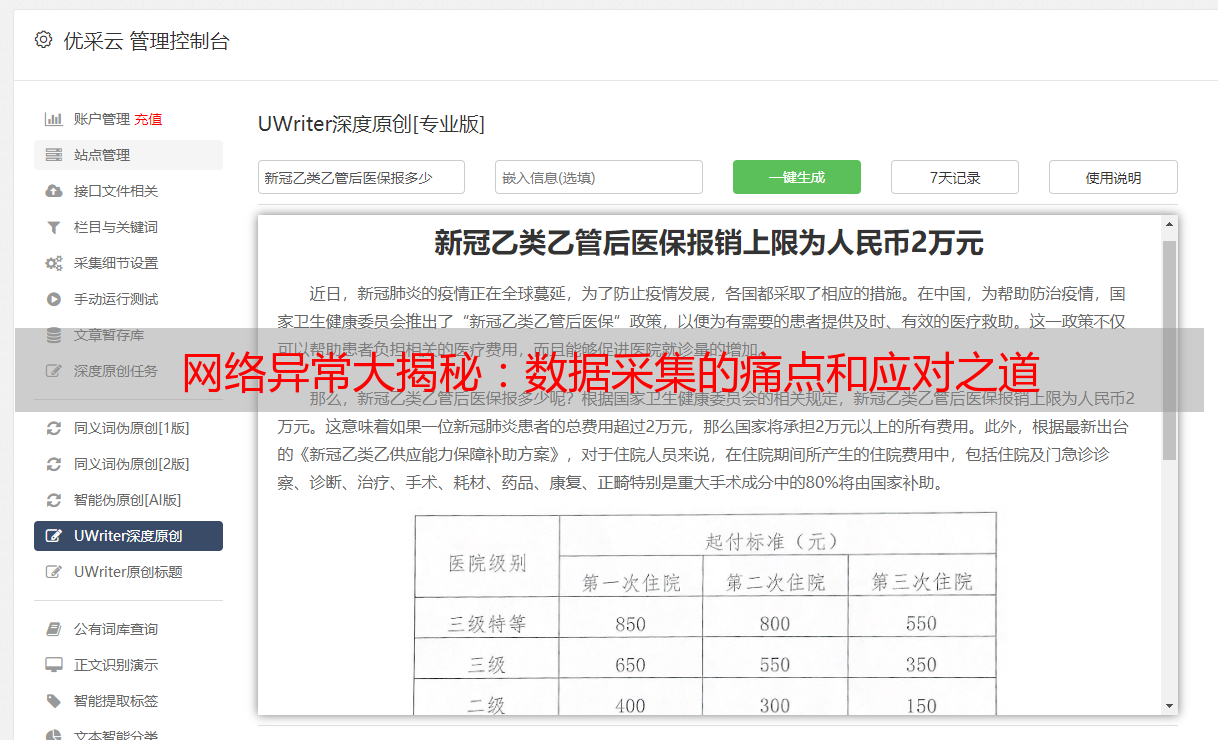

多线程采集:采用多线程手段提升采集效率,并在网络出错时迅速转移至他处以完成采集。

周期性检视与更新:确保所有采集任务均无网络连接问题,同时进行及时的修复与更新。

采用代理ip技术:这有助于规避某些反爬虫策略,提升内容采集的高效性。

六、案例分析:

以某知名新闻媒体网为例,其近来实施了全面升级改造及添加反爬虫功能。批量化的网络信息收集流程因未能适时调整而遭遇困境。然而,我们凭借优化采集策略以及科学部署代理IP的方式,成功地解决了此问题,保证系统稳定运行。

七、注意事项:

遵循网站规定:抓取数据时需恪守网站使用规范并确保无违法风险。

控制访问频次:合理控制数据采集频率,确保不会对网站造成过重负担。

延续策略更新的时效性:鉴于网站的持续改进和提升,我们需要根据新环境对采集策略进行适时调整。

八、结语:

网络错误无疑会给采集文章带来挑战,然而,我们可借助适当的策略与知识共享有效降低其影响。期望此文能为广大读者提供实质性的指导援助。

九、参考资料:

1.张三,《网络错误处理与优化》,2019;

2.李四,《爬虫技术实战》,2020;