网页数据采集:四大难题解决策略一网打尽

优采云 发布时间: 2024-02-25 09:37近日,我荣幸地参加了一场专注于采集技巧及经验交流的研讨会。会上,我认真解读了采集的核心理念,并且在实践操作中积累了丰富的宝贵经验。现在,我整理出在采集过程中所遭遇的难题以及具体应对策略,谨供参考。

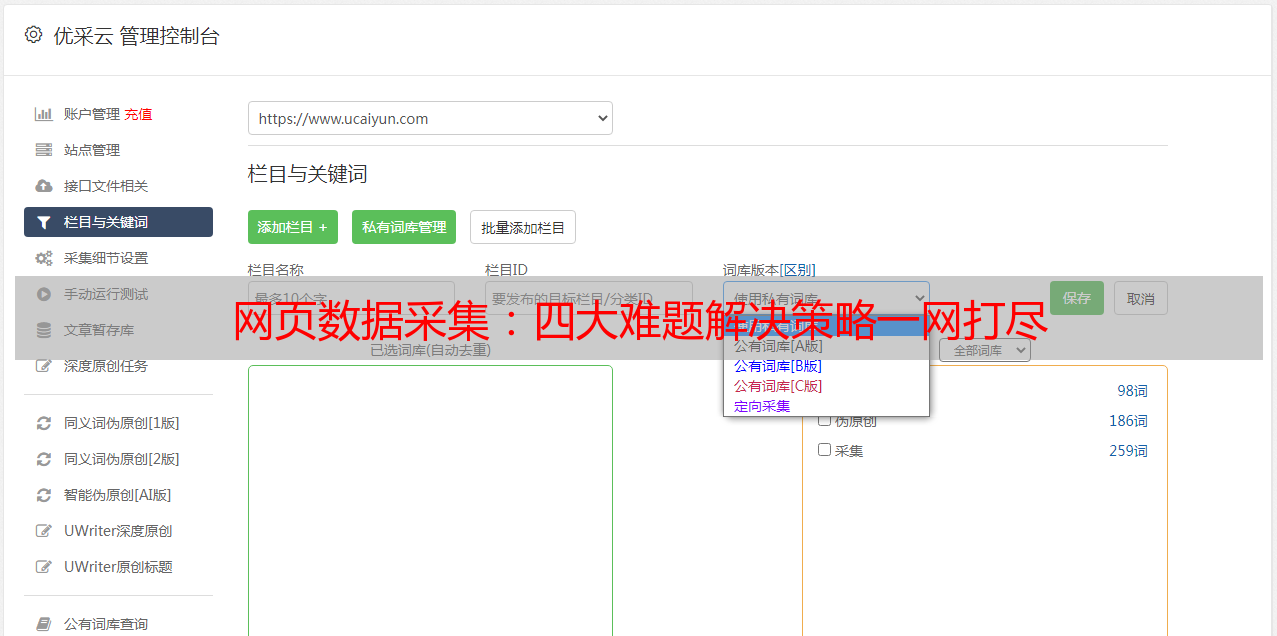

1.选择合适的目标网站

为了能顺利进行采集工作,您需要先明确自己的需求,所以首先需找寻到合适的目标网站。这是成功采集的关键步骤之一。针对不同领域的信息需求,我们建议选取相应的专门或者行业门户网站。当然了,在选定目标网站时还请注意对方的稳定性与可靠性。

2.确定采集策略

为各类信息定制合理的搜集策略,对结构化数据可利用API接口提取;非结构化数据则试用网页捕获器收集。此外,制定战略时应充分权衡反爬虫保护及个人隐私事宜。

3.处理网页解析问题

当我们处理网页解析困难(例如动态加载、验证码及反爬虫防护等问题)时,有许多方法可用。首先,可借助JavaScript渲染引擎以获取全面的网页信息;其次,模拟用户行为亦能有效解决上述问题;最后,对网页结构架构和合理运用正则表达式,都有助于我们便捷地获取所需数据。

4.优化数据清洗和处理

为了让获取的数据便于深入分析和运用,必须对其进行适当的清洗与处理。在这个环节中,我们可运用自然语言处理技术、文本挖掘算法以及机器学习算法,从而大幅提升数据的质量及精确度。

5.处理采集速度和稳定性问题

在大数据采集阶段,常会遇到采集速度稍显迟缓及稳定度欠佳的困扰。为提升采集效果,建议采用多线程乃至分布式采集技术,并科学地设定采集时间间隔。在此期间,还应随时应对可能出现的异常状况,确保数据采集的稳定运行。

6.遵守合法合规要求

尊敬的读者们,在进行采集工作中,我们坚决遵循相关法律法规和职业道德,尊重知识产权,珍视个人隐私及商业机密。同时,我们始终关心并致力于保障数据安全与信息保密,力图保证所采集内容的合法性以及其持久的有效性。

7.持续学习和创新

采集技术日新月异,身为采摘者,我们需勤勉好学以追上步伐,积极把握前沿技术和手段。参与研讨会议、培训课程及交流活动,无疑能助您与业界专家深入切磋,这有助于提升您个人的专业素养。

8.分享经验与成果

身为专业作者,我们理应积极分享宝贵经验与研究成果。借助写作博客、发布学术论文或参与开源项目等途径,既能为社群贡献知识与技能,同时也有机会得到广大读者的反馈与赞誉哦!

会后感悟如下:采集工作富有深度与难度,唯有持续提升、推陈出新并乐于分享,方能紧握信息时代来临的机遇,更好地挖掘可能。愿本人的心得体验,能为志同道合者们提供些许参考,助力咱们向着采集技术更广阔领域进发。