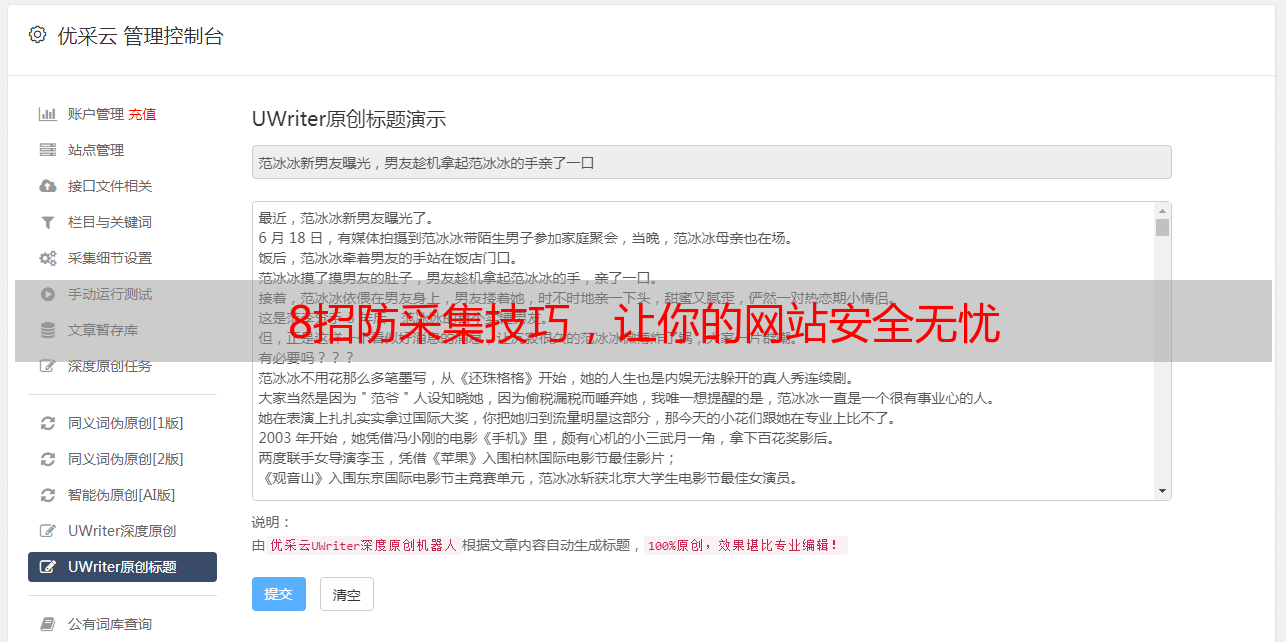

8招防采集技巧,让你的网站安全无忧

优采云 发布时间: 2024-02-20 07:41尊敬的读者,这里是一名有着多年网站管理经验的专业人士给您带来的观点,我在防止网站内容被采集方面已经积累了丰富的实践经验。在此,请允许我向您分享我的八项独特而有效的防采集技巧,期待它们能对您维护网站内容的完整性及保障其安全性有所帮助。

1.设置访问限制:

适当配置访问权限,例如IP地址封锁和用户认证等方式,可有效地遏制非法爬虫对我们网站资料的窃取行为。同时,也要适度设定访问频率限制,以免过多无效信息查询对服务器资源造成过载。

2.使用动态生成技术:

借助JavaScript渲染和AJAX加载等动态生成技术,我们可实现网页内容的实时更新。如此既有利于客户体验,又让爬虫工作略显困难。我们同样可以尝试使用验证码或图像文本替代法,有效防止机器人爬网行为。

3.加密敏感数据:

重视客户隐私和知识产权,我们会对涉及顾客信息、版权信息等敏感数据进行相应保护。通过专业的加密技术,我们确保了这些数据在必要之时才会被解密,降低采集过程中的风险。

4.利用反爬虫技术:

反爬虫技术旨在积极应对网络机器人的访问,例如运用变动的URL地址、隐匿链接以及制定相应的对抗策略等。这些措施能够准确地检测并阻挡爬虫活动,从而防止不合法或无授权的网站内容采集。

5.更新网站内容:

经常更新的网站内容,恰好是我们巧妙抵御网络采集的妙招。频繁的内容更改使采集者追赶不及,对提升用户体验与搜索引擎权重同样有益。

6.使用CDN加速:

使用CDN(内容分发网络)快捷服务,通过把静态资源不同程度地分布到世界多个服务器,我们可有效提升您的网站的浏览速率,同时也使非法爬虫难以采集到内容。

7.监控网站流量和日志:

我们定期监测网站的流量与日志状况,以期能够及时察觉任何异样访客行为。通过细致地剖析访问日志,我们能明确区分出非法爬虫活动的影响,从而迅速采取必要的防护措施。

8.合理设置robots.txt文件:

通过精心配置robots.txt文件,大家能够清楚地告诉搜索引擎哪些网页是不能被抓取的。如此一来,就能有效防止不必要的页面被搜索引擎收录,以致降低被采集的风险。

我在此分享多年网站内容防采集的宝贵经验。愿它们能助力您保护网站内容的完整性和安全性。别忘了,保护网站内容不仅利己,更有助于网络环境的健康发展。请与我们齐心协力,共建安全、有序的网络世界吧!