数据达人教你:四步搞定爬虫文章采集

优采云 发布时间: 2024-02-18 08:53身为一名资深的“数据达人”,我在速集大量原创新闻方面有着丰富的经验。今日便与您共享其核心精髓,望能助您一臂之力。

要第一,明确目标

在开始编写爬虫进行文章采集时,首要任务就是明确您的意图。是期望提升网站内容的品质吗?或者期待为您的网站带来更多流量?有了清晰明确的目标,便能更高效地逐步推进后续的策划方案与执行计划。

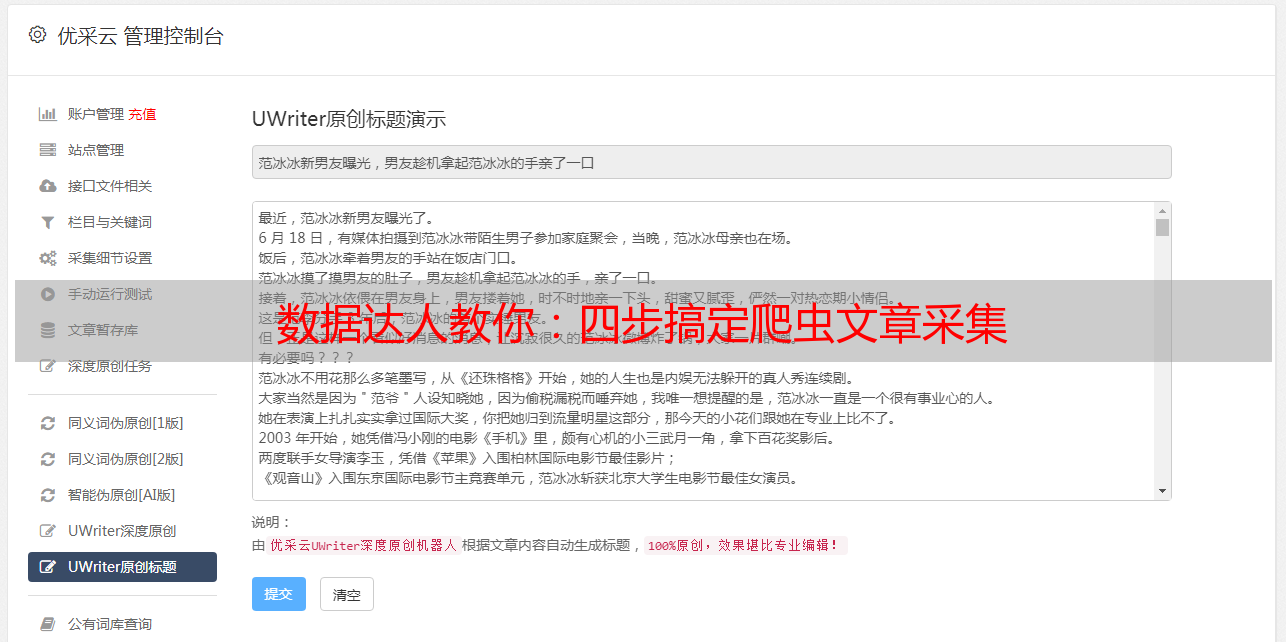

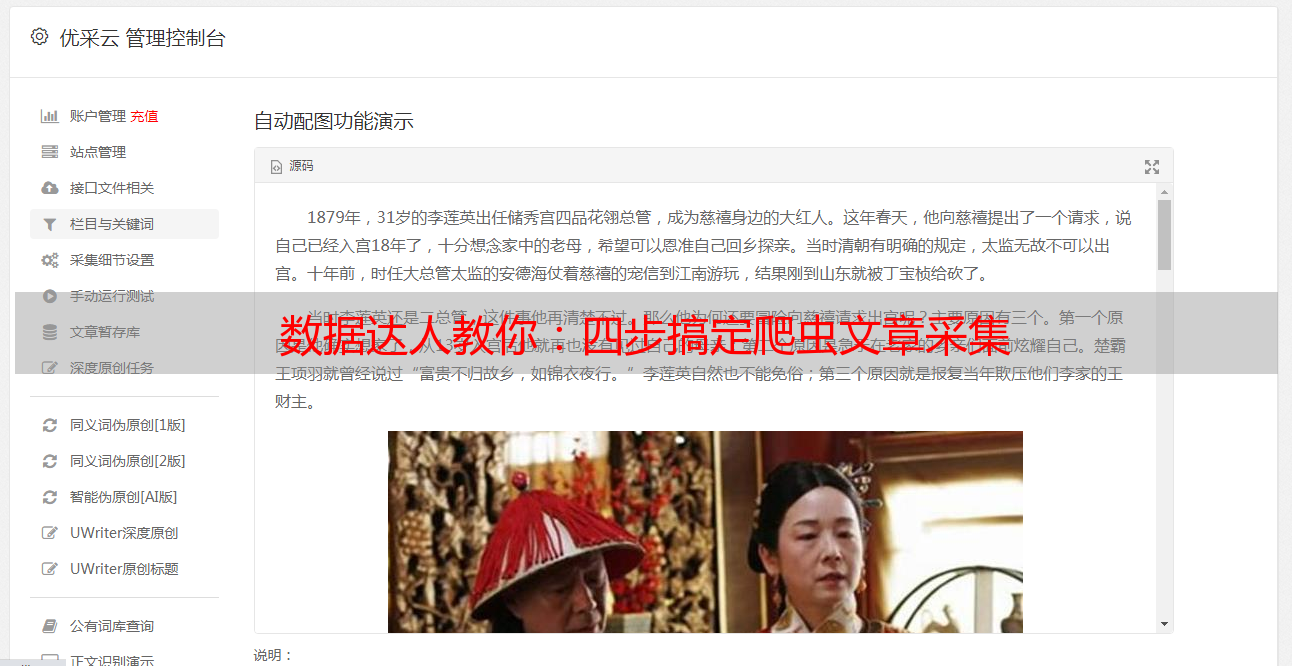

要第二,选择合适的爬虫工具

在选定适合自己需求的爬虫工具时,诚然有所偏好。但无论是选择自行编写代码的Python方案,还是依赖于成熟软件的轻便之道,务必关注其功能实用性与稳定性,以应对各种需求。

要第三,合理设置抓取规则

在进行大量爬虫原创文章采集任务时,我们需根据目标网站特性及页面组织,恰当设定抓取规则。其中涉及到选用适宜网页解析库,设计正则表达式,以及控制抓取频率等环节。唯有规范设定这些规则,方能确保所采文章准确无误且内容无遗漏。

要第四,处理反爬机制

很多网站都设有防爬取措施来阻止爬虫程序的入侵。在进行大批量经典文章采集的过程中,我们有必要寻找并妥善应对这些防爬计策。我们可通过使用代理IP地址、模拟用户登录以及设置请求头等途径来规避反爬取限制,从而保证爬虫程序顺畅运行。

要第五,数据清洗与去重

为了确保采集到的文章内容的准确性,我们会先对其进行数据清洗和去重的操作,去除其中夹杂的噪音及冗余部分。我们采用先进的文本处理技术,包括正则表达式、自然语言处理等方法,为您带来更高质量的数据服务。

要第六,自动化运行与监控

为了提升效率,建议您采用自动化运行方式来批量采集原创文章。利用脚本编程或者定时任务器,可以设置定时启动爬虫程序以及监测状态,以减少手动操作的时间及成本,从而达到高效作业的目的。

要第七,合法合规操作

在进行爬虫 大批量原创文章采集过程中,请您务必遵循有关法律及网站的使用规范,不可进行任何非法爬取、侵犯他人个人信息等不当行为。此外,请尊重各大网站的 robots.txt 文件,切勿给网站带来过大的流量负担哦~

要第八,数据存储与备份

收集来的原创文章是珍贵宝物,我们应当妥善存储。建议利用数据库或云储存对信息进行管理,然后定期加以备份,以保证信息不致遗失或者损毁。

要第九,持续学习与优化

持续提升、优化爬虫批量原创文章采集技巧,是一种成长过程。请您保持学习热情,紧跟科技脉动与业界动态。唯有不断精进、完善自我,方能在这一广阔天地立于不败之地。

身为一位致力于"数据巨人"的人,我深知爬虫批量原创文章采集的益处之大。愿借此机会,与各位对该领域感兴趣或身在其中的朋友共享经验,愿我们共同努力,尽一份力,添彩网络世界!