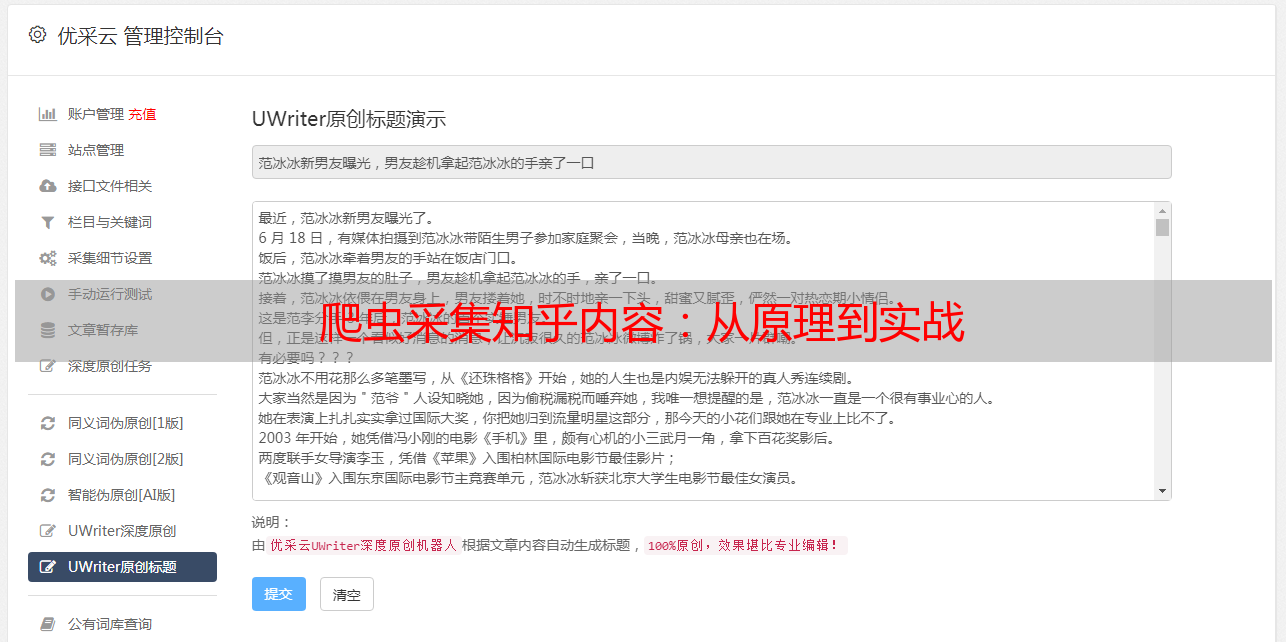

爬虫采集知乎内容:从原理到实战

优采云 发布时间: 2024-01-29 19:55一、爬虫的基本原理

爬虫是一种模拟人类浏览网页行为的软件,能够自动抓取网页内容和关键信息。其工作方式是通过向网站发出HTTP请求以获取页面源码,然后使用适当的解析组件来抽取我们需要的数据。

二、如何使用爬虫采集知乎内容

确立方向:麻烦先明确要搜集的知乎信息类型,例如,问题、回复或者评论等。

请您在浏览相关页面后,关注下它们的URL结构,这有助于制定更高效的访问请求设置规则哦!

用Python编程语言编写网络爬虫程序,我们可以通过向网站发出HTTP请求来获取网页源代码哦!

我们可以借助BeautifulSoup此类解析工具来抽取网页上所需信息,有效地简化了网页源码。

善待我们的数据:收集而来的信息将会被安全保存于数据库或档案,方便之后查阅和深入研究。

三、爬虫采集知乎内容的优势

精准高效:自动爬取技术能有效地完成大量烦琐工作,大大加快了数据收集的进程,比手动复制粘贴更具优势哦。

丰富多元:访问多个种类的知乎内容,充分满足您的个性化需求。

时效性:定期更新爬虫程序,确保获取即时且最新知乎资讯。

四、爬虫采集知乎内容需要注意的问题

尊崇规范:请在使用知乎时自觉遵守相关规定,以确保操作的安全性和合法性,同时注意保护他人权益。

敬告:建议适度访问,遵守相关规定以防受限或封站。

五、如何应用爬虫采集知乎内容

科研探索:采用爬虫技术探寻知乎问答,助力学术研究与数据分析领域繁荣进步。

大众视角解析:政企可善用知乎话题数据爬虫监控功能,掌握公众舆论与市场动态。

亲爱的用户您好!非常欢迎您在使用爬虫程序时尽享于搜寻并收集知乎上自己感兴趣的信息,进行学习或闲暇时间放松娱乐。

六、爬虫采集知乎内容的挑战

注重保护用户隐私与安全的反爬虫技术:为确保广大知友好朋友们的个人信息安全及隐私得到充分保护,各大知识分享平台如知乎等已经实施了相应的反爬虫策略,可能给使用爬虫工具的同学带来一定不便。

为了提升知乎平台上的内容质量,减少无益错误信息,我们为您提供专业策划的数据清洗服务。

七、合法合规使用爬虫采集知乎内容

敬请重视版权:我们鼓励您在使用他人分享的知乎资源时,遵循相关法律法规并尊重其知识产权。

敬爱的用户,请遵守我们的规定:如使用爬虫软件,还望莫侵犯知乎同事之劳动成果,尽量避免施加额外压力于他人。

本文简要介绍了爬虫在采集知乎信息过程中不可或缺的地位。同时,法律法规下的爬虫使用显得尤为关键,因为这关乎到个人隐私安全和知识产权维护。值得肯定的是,随着技术的进步,爬虫必将为人们的生活带来更多的改善和机会。