数据收集秘籍:如何轻松获取高质量数据?

优采云 发布时间: 2024-01-27 23:21一、背景介绍

作为一名工作于信息海洋中的数据收集者,我每天都忙碌在不同网站与应用中寻找所需的宝贵数据。在此,我想向大家分享一下自己的数据收集经验及规则。

二、规则制定

收集数据前,我会先建立维规,务求达到最好的采集效益及精度。首先,确定需采集的数据类别和范围至关重要。接着,依据不同网站和应用的特性,制定出相应的采集策划和方案。最终,设定数据采集的周期和时点,确保能随时获得最新的数据资讯。

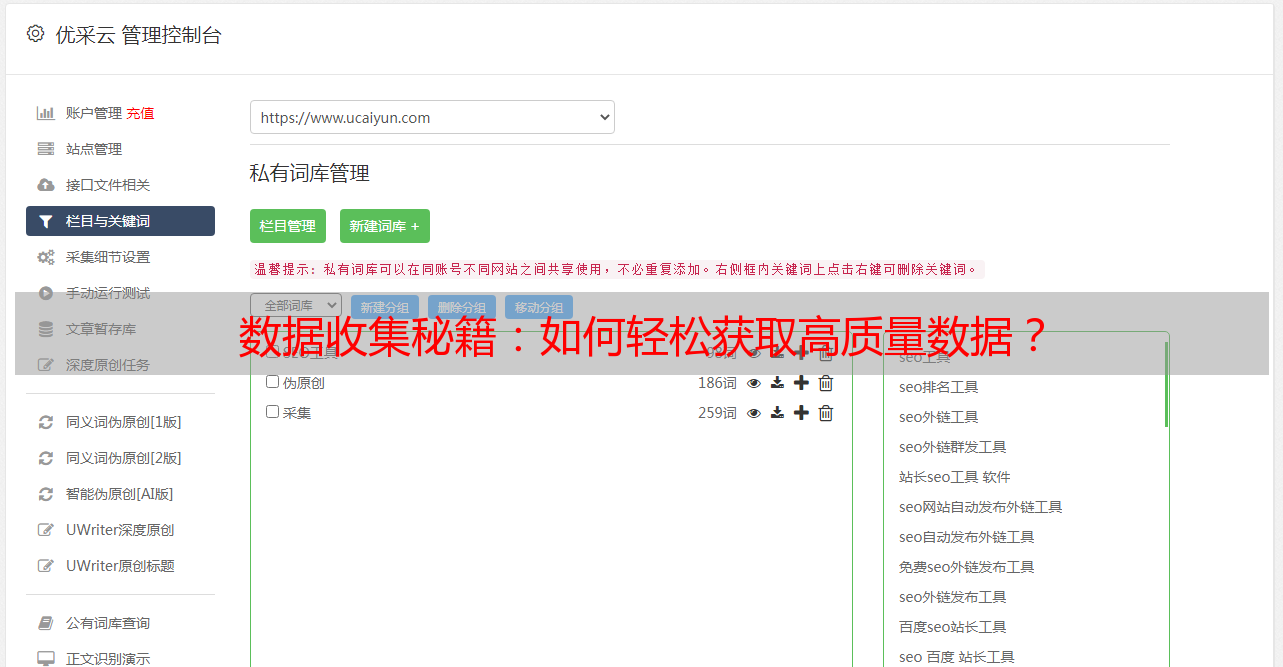

三、选择合适的工具

我在选择专业的数据采集工具上有深入研究。多次筛选比对后,最终选中了最适合我的一款工具。这款工具不仅能帮我迅速提取网页内容,解析结构化数据,还能够以实用的形式呈现出来。更重要的是,它具备出色的过滤和清洗性能,保证了搜集到的数据的高质量。

四、深入挖掘网站结构

在开始采集数据之前,首先对目标网站进行详细了解以方便查看其架构与内容分布情况。通过分析网页源代码、URL参数以及API接口来确定所需要的数据。如此一来便能精准定位并轻松抓取最终目标数据,从而显著提升了整个采集过程中的有效性及准确性。

五、制定合理的请求策略

为降低对目标网站负荷,我将采取适当的请求策略,如设定适宜的请求间隔、运用代理IP访问以防止被反爬虫技术识别、模拟实际用户操作等措施确保数据收集过程顺畅。

六、处理反爬虫机制

在搜集数据过程中,经常不可避免地遭遇到各种反爬虫技术。为克服此类困难,我积极采用了多种策略及手段,如模拟真实用户操作(例如随机设定User-Agent头部信息)、通过可信赖的第三方服务来处理验证码以及执行模拟登录等等。经过反复实践并加以改进,我总能成功破解这些限制,准确无误地采集到所需的珍贵数据。

七、持续优化和更新

数据收集的工作需要时刻保持警惕,我将根据数据变动及需求调整来适时改进和更新规则;其次,我也会关注最新科技与工具,掌握新的收集方法,以期提升工作效益与质量。

八、合规合法操作

身为专业数据采编员,我坚守法律与道德准则,在提取信息时,遵照各站点的用户协议及保密政策,力求降低对站点运行的影响。不失敬意地保护数据持有方的权利,只取在法规允许之内的内容。

九、数据处理与分析

数据收集固然重要,但更关键的在于有效处理与深度分析所获取之数据。我会借助各类工具及精炼算法来清洁、剔除重复信息、优化数据格式等,从而确保我们获得高品质且有价值的数据。接着,凭借统计学手法以及先进的机器学习技术,我将深入剖析这些数据,为您提供更具洞察力的结论及预测。

十、总结与展望

数据采集这份工作极具挑战性,但同时也是美妙并具有深远影响的职责之一。通过亲自感受这一过程,我深感数据收集对于业务发展和决策制定的重要地位及其价值。展望未来,我计划持续投入学习与实践,提升自身技能与素质,以期为更多人士提供优质的数据服务。