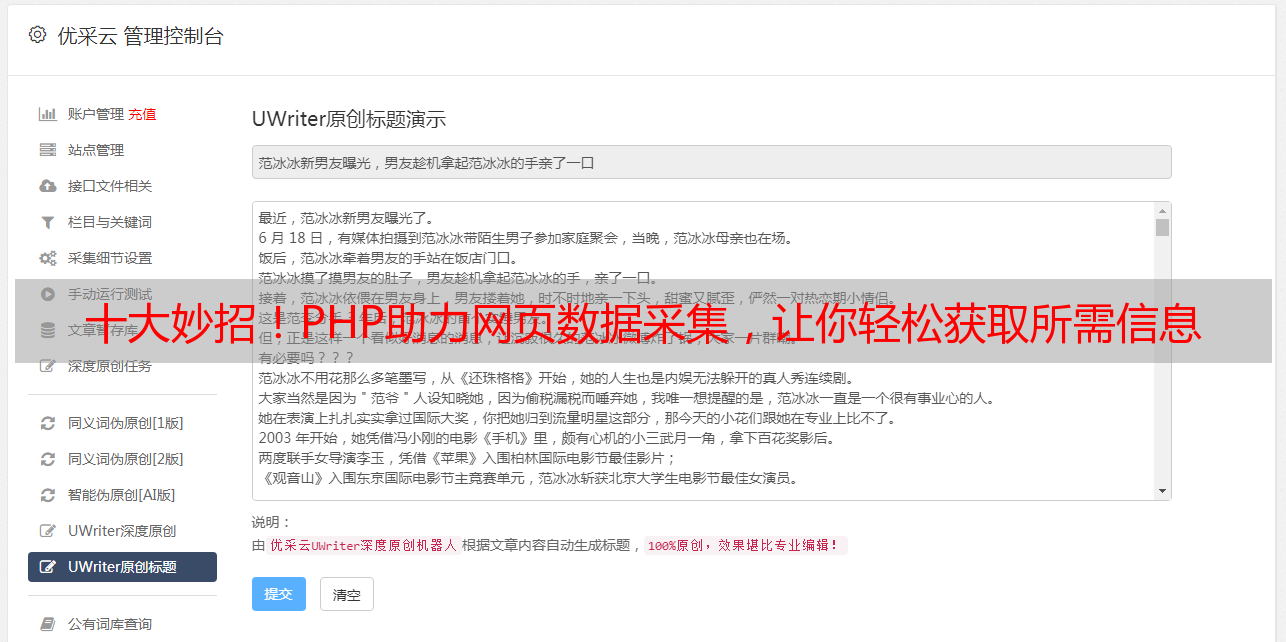

十大妙招!PHP助力网页数据采集,让你轻松获取所需信息

优采云 发布时间: 2024-01-18 19:27PHP作为网页数据收集的首选工具,备受广大用户喜爱且应用广泛。其丰富多样的高效便捷方法,能助力我们迅速地获取所需信息。下面,请允许我为您揭示运用PHP设置文章采集的十大妙招。

1.使用cURL库:

curl作为极佳的PHP扩展,能够有效模拟浏览器对网站发出HTTP请求,进而从中获取网页的核心信息。借助其便捷性,我们能够迅速获取所需的网页数据。

2.使用file_get_contents函数:

PHP内置的文件获取内容函数可方便地读取远程网页信息,如HTML格式的代码。只需进行少量处理和提取,即可获取到您所需求的文章数据了。

3.使用DOMDocument类:

在PHP编程环境里,DOMDocument被视为一项核心必备组件,专门研发处理HTML文档问题,具有便捷高效的特点。本类的独特之处在于对HTML文档进行深入剖析,并有能力精确获取所需节点中的文本内容。

4.使用正则表达式:

运用正则表达式有助于精准获取并清理所需网页中的文章信息,在数据搜集过程中有着显著的改善效果。只需概要理解一下它的使用方法,大家就能轻松驾驭这项实用工具了。

5.使用XPath:

确实如此,借助于XPath的强大功能,我们能够在HTML文档中精准定位所需元素啊!无论寻找文字内容还是图像,利用节点或属性选择方式,皆可游刃有余。如需定位特定文章的关联信息,只需使用XPath编写代码即可轻易实现了哦。

6.使用第三方库:

除了我们常用的PHP内置特性与类外,市面上也有许多高质量的第三方库供您选择呢,例如Goutte和QueryList这样的强大工具就可以大大提升您爬取网页数据的效率和便捷性哦!

7.处理动态网页:

在面对部分需要动态生成HTML代码的网页时,仅仅依靠HTTP请求可能无法获取到完整的HTML代码。此时,您可以考虑使用像PhantomJS或Selenium这样的实用工具来模拟浏览器的访问流程。

8.遵循robots.txt协议:

尊敬的站长,在信息采集过程中,我们会尽可能遵守您的意愿。Robot.txt文件作为必备的指南,将清晰告知搜索引擎哪些页面可被索引。因此,恳请您在操作之前查阅文档,避免产生不必要的困惑。

9.设置合理的请求头:

为了避免某些网站识别到爬虫,您还可以尝试更改请求头部设定。比如,尽可能模拟浏览器习惯,这样可以大大降低被认作爬虫的风险,实践证明此法效果不错!

10.处理编码问题:

在搜集网络信息时,代码转换问题较为常见,因为各网站使用的编码方式并不统一,所以有时需作出相应调整以确保能轻松获取所需信息。

在此献上几个小小建议,希望能助阁下更精准迅速地找到所需之文案素材。祝愿阁下收获满满!