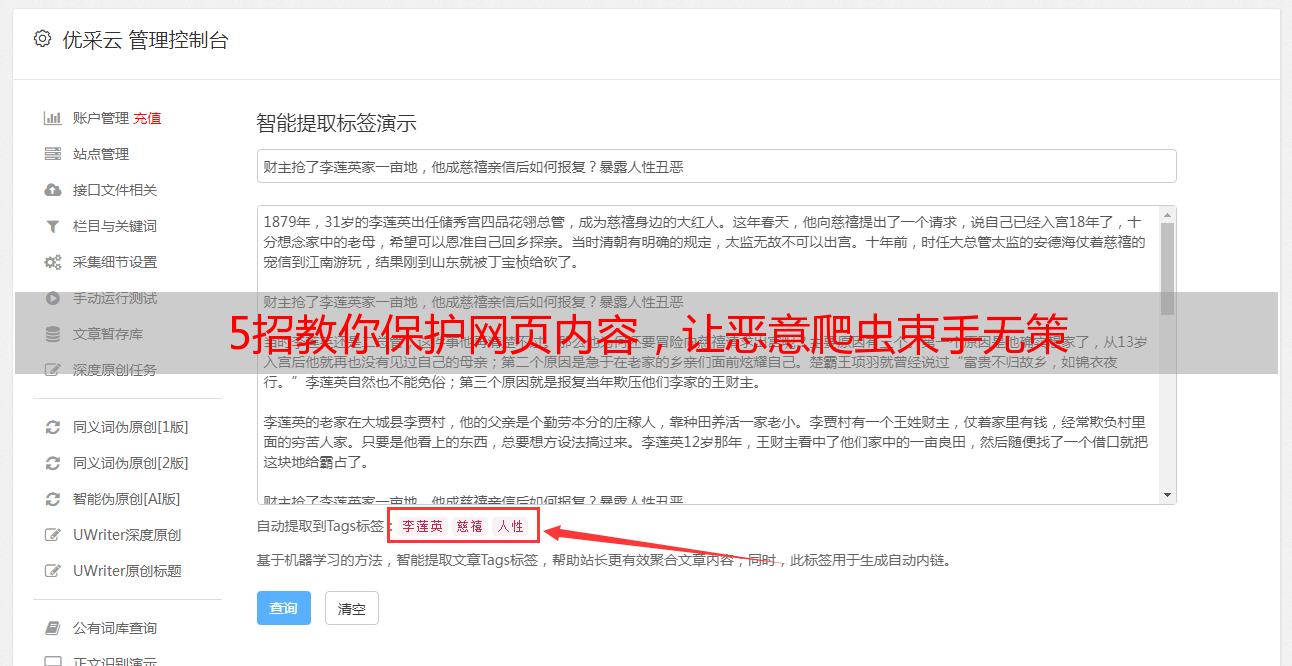

5招教你保护网页内容,让恶意爬虫束手无策

优采云 发布时间: 2024-01-03 10:30近年以来,在互联网飞速发展背景下,网页采集逐渐成为一项重要议题。无论是个人博文,抑或是大型公司官网,均存在遭遇恶意采集、复制及滥用之可能。为了保护网页内容不被侵犯,本篇文章将从理论分析,经验分享以及实用防护措施多角度为大家提供建议与参考。

1.网络协议限制:

我们采用robots.txt文件或者元标签中包含的noindex属性,来让特定网络协议的访问受到限制,从而有效地挡住了搜索引擎和爬虫程序对网站内容的采集行为。

2.强化用户验证:

为了确保我们网站的安全性,在您登录或者注册时,稍微增添验证码以及双因素认证这些小步骤会极大地减少恶意侵入的可能。另外,建议您时常更新密码并且保证密码的复杂性哦。

3. IP地址过滤:

借助IP地址过滤设定,我们便能有效规避恶意或过频访问的IP地址,进而降低此类搜集网页信息行为的发生几率;同样地,运用如防火墙之类的安全措施,以监测并及时处理异常访问也是必不可少的。

4.图片和文本加密:

运用图片与文本加密技术,可防止网站内容被爬虫程序轻松地解析及复制,尽管不能做到万无一失,但能极大提升采集难度。

5.反爬虫技术:

我们发现,通过综合运用诸如动态页面加载、验证码图示以及IP通道限制等反爬虫策略,不仅能够精确地区分并阻挠恶意爬虫病毒的入侵,同时也有助于大幅度地减缓网络数据采集的频率。此外,借助于JavaScript等前端应用,网页内容也可以实现动态展现,进而在一定层面上妨碍信息抓取者获取完整数据。

6.版权声明和法律保护:

请在站页底端或文首加注版权说明及使用规定,以示尊重用户权利,并提醒他们不要擅自转载、复制或者滥用本站资源。此外,也不妨研究一下对应的法律法规,以便在必要时运用法律保护自身利益哦!

7.定期监测和更新:

定期监控网站流量、浏览记录及特殊行为,同时也需要适时升级系统与插件,这是预防网页被采集的基本方法。一旦发现并处理特殊游客行为,便能极大地降低采集中得手的可能性哦。

借助七大策略的全面实施,我们能有效抵制恶意采集对网站内容的侵犯。尽管没有无敌的防护手段,但我们不断学习,跟进最新的防护技术,便可减少网页被采风险,确保辛勤创作得以保存。让我们携手维护互联网公平、健康及秩序井然!