网络安全专家亲身揭秘:如何应对信息洪流进行网站采集?

优采云 发布时间: 2024-01-03 07:57作为一位专业的网络安全专家,我始终致力于捍卫网络安全。近期,我有幸亲身参与了网站数据采集工作,使我对网络世界有了更深层次的理解。

1.集结信息的洪流

在正式启动网站采集工作前,我们需先对各种信息源进行收集。借助于搜索引擎以及社交媒体、论坛等途径,我们成功发现了大量的目标网站,并将其梳理整合为一个完整有序的信息库系统。这犹如一股源源不断的信息洪流,正以彬彬有礼之姿纳入我们的电脑中。

2.制定精确计划

为了进行网站采集工作,我们需精心做好规划哦。首先,您得明确要采集哪些网页和相关数据,并设定合理的筛选标准。这宛如一份指引航行的地图,会带领大家安全地穿越整个采集流程。

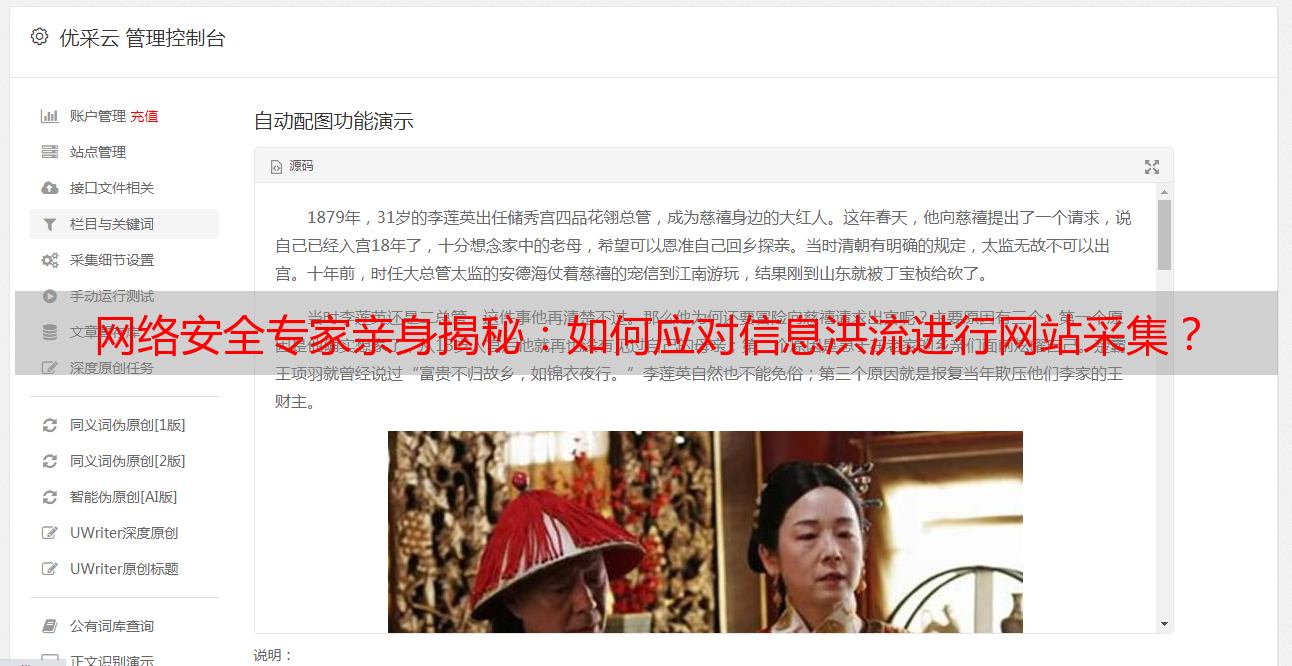

3.网络爬虫的工作

然后,我着手运行网络爬虫工具。它能根据设定的规则,自适应模拟浏览行为,自动检索特定信息。这种软件犹如灵巧的蚂蚁,勤勉不懈地穿梭于网络之中。

4.制定规则进行过滤

在处理繁多的数据时,我们常会遇到无序或者含有无价值信息的情形。因此,我们为提取出有意义的数据设定了筛选原则。这些规条就如同生活中的过滤器,帮助我们从大量的信息中筛选出真正有益于我们的内容,剔除那些无效的元素。

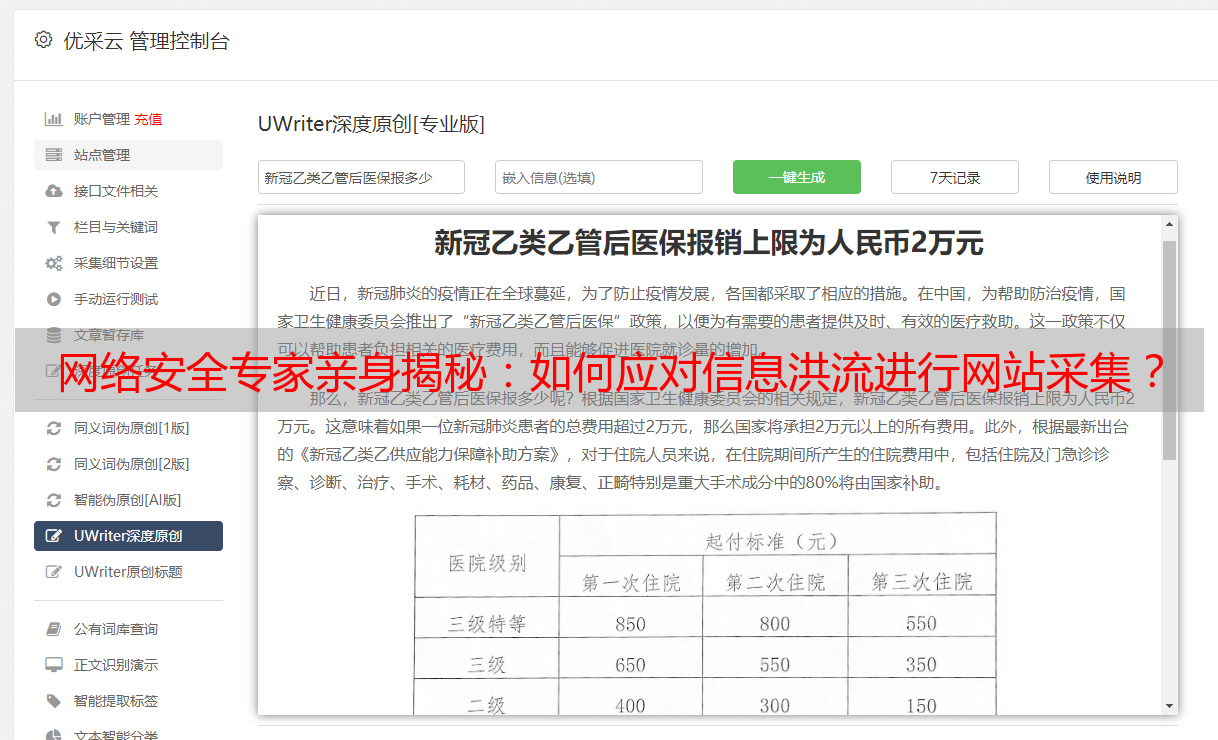

5.数据处理与分析

在完成了数据的初步筛查工作之后,我们接下要对这些数据进行深度的处理及剖析。我们将应用统计学、排序以及分类等多种方法,从繁杂的数据海洋中找寻并提取出那些能为我们提供重要参考的关键信息。这个发掘过程,宛如玩拼图游戏似的,总能激发人们无尽的好奇心与探索欲望,让人心生期待,充满热情。

6.网站采集的挑战

抓取网站信息并非易事,需要应对诸多难题。部分网站设有反爬虫系统,使我无法顺利展开工作;还有些站点则对我的请求做出限制,进而影响了采集效率。然而,我始终保持积极态度,努力克服困难,以确保任务圆满完成。

7.保护网络安全

身为一位恪守职责的网络安全专才,我在网站数据采集工作中始终怀揣高度谨慎态度。践行严格遵守的法律法规及职业道德准则,我始终全力避免对目标网站产生任何形式的潜在损害。我的目标纯粹在于守护网络安全,远非摧毁之意。

此次亲身实践让我体会到网站采集的重要性与挑战性,它是信息膨胀时代下获取有价值数据以助于决策制定及发展的关键环节。作为一名网络安全专业人士,我将致力于通过自身行动来保障网络安全。

参考资料:

诚邀阅读《网络爬虫:从入门到实践》(https://book.douban.com/subject/27605308/)。

《精通 Python 网络数据采集》书目推荐(https://book.douban.com/subject/27154809/)。