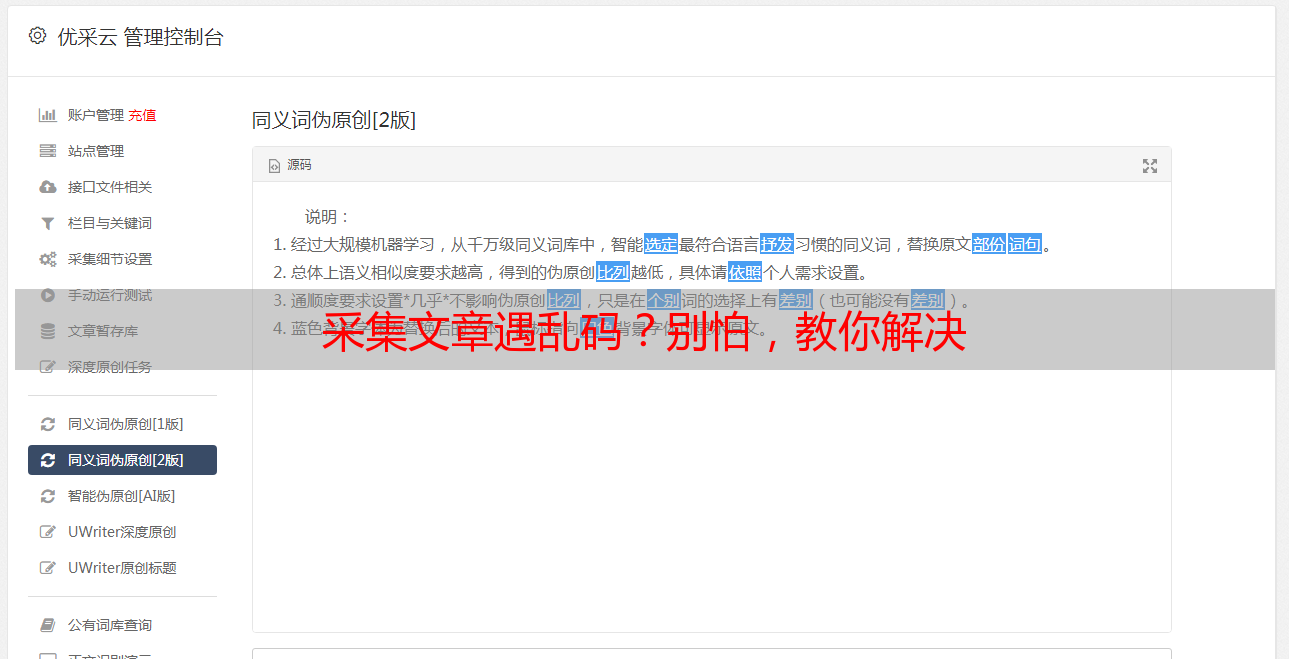

采集文章遇乱码?别怕,教你解决

优采云 发布时间: 2023-12-29 02:35亲爱的各位朋友,你们好!我是这里的管理员小明,很高兴能够与您沟通。近日,我们收到了很多关于在 dz 论坛采集文章过程中遇到乱码现象的反馈,因此特意为诸位解答该问题。

问题一:为什么采集来的文章会出现乱码?

在网页编码领域里,常见的有UTF-8、GB2312和GBK三种格式。然而在我们进行网页内容搜集的过程中,很可能面临编码不同步的问题,从而致使显示混乱或无法解析。例如,从采用UTF-8编码的网页中采集含GB2312编码元素的信息,结果将会是显示出错。

问题二:怎样解决采集来的文章乱码问题?

尊敬的您,首先,希望您能在开始采集数据前,查阅目标网页的源代码中找到meta标签内的charset属性,以便确定网页使用的编码方式。

确保编码无误:请根据目标网页的编码设定相应的编码方式。例如,您可选择在Python中的requests库获取网页信息并设置响应.encoding='utf-8',或试一下'gbk'看看是否合适哦!

调整编解码方式:若对目的页编码有所疑问,可试将所获内容进行相应的编码改变。例如,藉由Python(Language)中的辅助函数content.decode('gbk').encode('utf-8'),即可将所得的GB2312编码信息成功转换至UTF-8编码。

问题三:还有其他可能导致乱码的因素吗?

除了编码问题以外,你可能还会发现,采集到的文章出现乱码可能是因为目标网页运用了特殊字符或者不同寻常的编码格式。遇到这种情况时,我们需要耐心地按照具体情况一步步寻求解决方案。

问题四:有没有更方便的方法来解决乱码问题?

是的,没错,如今已有不少收集小能手或资料库,能为我们解决乱码难题提供便捷通道。比如,在Python圈子里,就有如 BeautifulSoup 这类的宝藏库以及 Scrapy 这样实用的框架,它们都能够智能地辨识网页编码并采取具有针对性的处理策略,极大程度上帮我们省心省力。

问题五:如何预防采集来的文章出现乱码?

为确保采集的文章不会出现乱码,建议您在采集前检查目标网页是否存在编码或特殊字符不一致等情况。此外,不妨在采集程序中添加强制错误处理功能,以便对可能发生的乱码进行识别并妥善处理。

问题六:如果遇到无法解决的乱码问题怎么办?

如遇无法解决之乱码情况,可向目标网站管理或技术团队寻求援助。他们或许能提供更为有效的解决办法。

问题七:总结一下如何解决采集来的文章乱码问题?

如果您在处理采集而来的文章时遇到了乱码问题,先请确认网页的编码模式;若有误,可尝试设置为正确的编码或是做个编码转换。另外,相对于特殊字符以及非常规编码这种情况,也要有所防范并做好相应处理哦。如若仍有不解之处,不妨向专业人士请教求助。