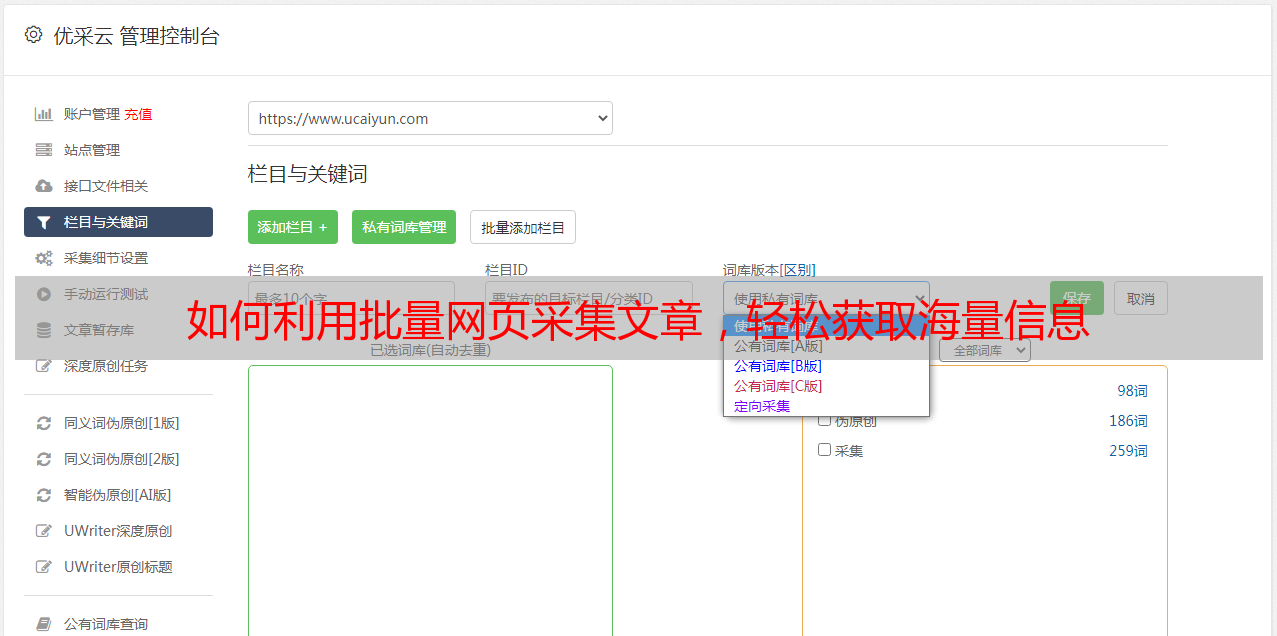

如何利用批量网页采集文章,轻松获取海量信息

优采云 发布时间: 2023-12-28 21:12批量网页采集文章是一种自动化获取互联网上大量文章的方法。本文将介绍批量网页采集文章的应用场景和技巧,帮助读者更好地利用这一工具。

1.批量网页采集文章的定义

批量网页采集文章是通过自动化程序,从互联网上抓取大量文章并进行整理、处理的过程。这种方法可以节省人力成本,提高效率。

2.应用场景

-学术研究:批量采集相关领域的论文、期刊等,为研究提供数据支持。

-新闻媒体:快速收集各个新闻来源的报道,进行分析和整合。

-市场调研:收集竞争对手的产品信息、用户评价等,为市场决策提供参考。

-社交媒体分析:采集社交媒体上用户的观点、评论等,了解用户需求和市场趋势。

3.技巧1:选择合适的工具

根据不同需求选择合适的批量网页采集工具,例如Python中的BeautifulSoup、Scrapy等。了解工具的特点和使用方法,可以提高采集效率。

4.技巧2:设置合理的采集策略

在进行批量网页采集时,需要设置合理的采集策略,包括访问频率、并发数、数据存储等。遵循网站的规则,避免对目标网站造成过大负荷。

5.技巧3:处理反爬机制

为了防止被目标网站的反爬机制识别并屏蔽,可以采取一些技巧,如设置随机延时、使用代理IP等。

6.技巧4:数据清洗与分析

采集到的文章可能存在格式混乱、重复内容等问题,需要进行数据清洗和整理。使用文本分析工具(如自然语言处理库NLTK)对文章进行分析和挖掘。

7.注意事项

-遵守法律和道德规范,在采集过程中避免侵犯他人权益。

-尊重网站的规则和隐私政策,不得进行非法或未经授权的操作。

-注意数据安全,加强对采集到的敏感信息的保护。

8.总结

批量网页采集文章是一种高效的获取大量文章的方法,广泛应用于学术研究、新闻媒体、市场调研等领域。通过选择合适的工具和技巧,可以更好地利用这一工具,并遵守相关规定和注意事项。

以上是对批量网页采集文章的简要介绍,希望读者能够在实际应用中获得积极的帮助和收益。

参考资料:

-"Web Scraping and Crawling Are Perfectly Legal, Right?," by Roman Pichler, https://www.romanpichler.com/blog/web-scraping-and-crawling-are-perfectly-legal-right/

-"How to Crawl the Web Politely with Scrapy," by John Hawthorn, https://blog.scrapinghub.com/how-to-crawl-the-web-politely-"How to Crawl the Web Politely with Scrapy," by John Hawthorn, https://blog.scrapinghub.com/howtocrawlthewebpolitelywithscrapy。