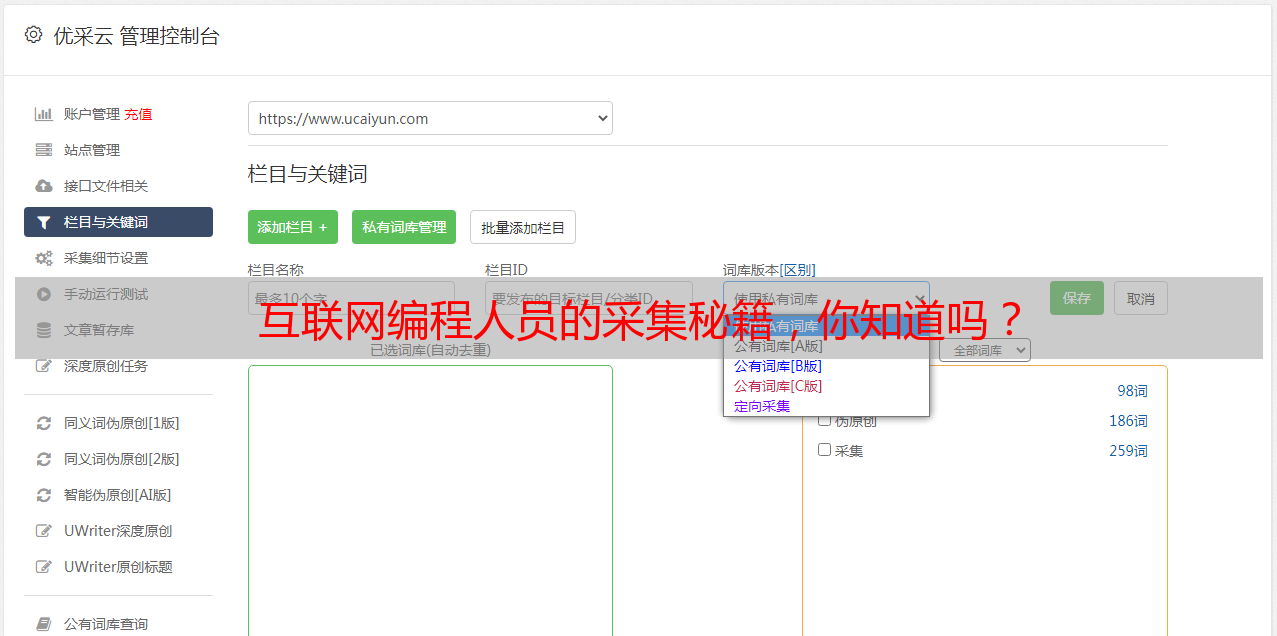

互联网编程人员的采集秘籍,你知道吗?

优采云 发布时间: 2023-12-25 09:49身为一名互联网编程人员,我常需从各类网页中获取所需数据。在此特别提醒大家,定时采集文章源码是不可错过的重要工作之一!接下来,请允许我与您分享个人在采集过程中的心得体会。

1.制定采集计划

在此次采集行动开始前,为确保效率,我们需先拟出一份周全的计划书,明确包括采集频率、目标网站以及目标页面等要素。根据我过往学术研究的经验来看,每天进行一次准时的采集或许会更加适宜。

2.分析目标网页结构

编写代码前,我们会先详细研究网页的构造,这其中包括查看网页源码以及观察网页元素。有了这样的了解,我们才能更有效地编写出针对性强的采集代码。

3.编写采集代码

在获取目标页面结构后,我着手编制采集程序。首先,我会选用Python作为编程语言,这样能够借助其众多不错的库和模块(例如requests和BeautifulSoup)执行网页数据的快速抓取与解析。

4.设置定时任务

当然,我们会借助操作系统所支持的定时任务功能进行数据采集。例如在Linux环境下,利用crontab命令可轻松设定任务的执行时间与指令,确保采集任务能正确按时地运行。

5.处理异常情况

收集过程中难免出现网络中断、页面架构变动等常见问题。因此,为确保数据采集稳定无误,我特意为程序编码了详尽的异常管理机制。比如遇到网络故障,系统将自动尝试重新链接。

6.存储采集结果

我们有必要将采集来的资料妥善保管以方便后续研究分析。根据实际情况,我们可以把资料存入数据库或者创建为文本文件等等,同时,还可以实施数据清洗以及去除重复项等操作。

7.监控采集状态

为及时发现和处理采集问题,我会定期悉心监控采集状态。运用详阅日志、检测成效的方法,对于突发异常状况能立即核实并妥善处理。

8.定期优化采集策略

随着时间流转,目标网站的内部结构或许会有所改变哦~因此,我们有必要对原先制定的采集策略适当做出灵活调整,让其更符合当下的需求。我本人会定期审视并优化这些策略,使采集工作能够更加高效且精准地完成。

9.注意合法合规

在日常的文章采集工作中,请放心,我会严格遵守所有的法律法规和使用要求。您知道的,我懂得如何去捡拾哪些数据,同样,也明白哪些是碰都不能碰的内容,并尽力减轻对被采网站的压力。

10.持续学习与改进

身为技术活动的一部分,文章源代码收集与学习是相辅相成的。我会密切关注最新科技以及相关辅助设备的动态,以便自身收集技能得以进一步提升。

经过上述过程,我成功完成了定时采集文章源代码的任务。这不仅满足了我的数据需求,同时提升了我的编程技能及对互联网的理解。衷心期望本经验分享给对文章源代码采集有兴趣或有相关需求的朋友们能够提供些许参考价值。