网络爬虫数据搜集:四步轻松入门

优采云 发布时间: 2023-12-15 18:54我是一位专注于网络数据搜集的行业专家,从事该领域已有数年时间。这次,非常高兴能够有机会与大家共享自己的经验教训。希望这些经验可以帮助那些刚刚接触或准备深入学习这个领域的朋友们。

1.了解目标网站

在开始爬取数据前,请先深入理解您要爬的目标网站,这包括其整体结构、页面布局和数据储藏方法等,这样可以更有效地设计提取策略哦。

2.分析网页源码

解析网页源代码在爬虫采集中颇为关键。通过观察网页源码,我们能明确所需数据的具体区域,进而确定适宜的采集策略。此外,还可能发现一些不易察觉的趣味信息,为后期数据处理增添亮点。

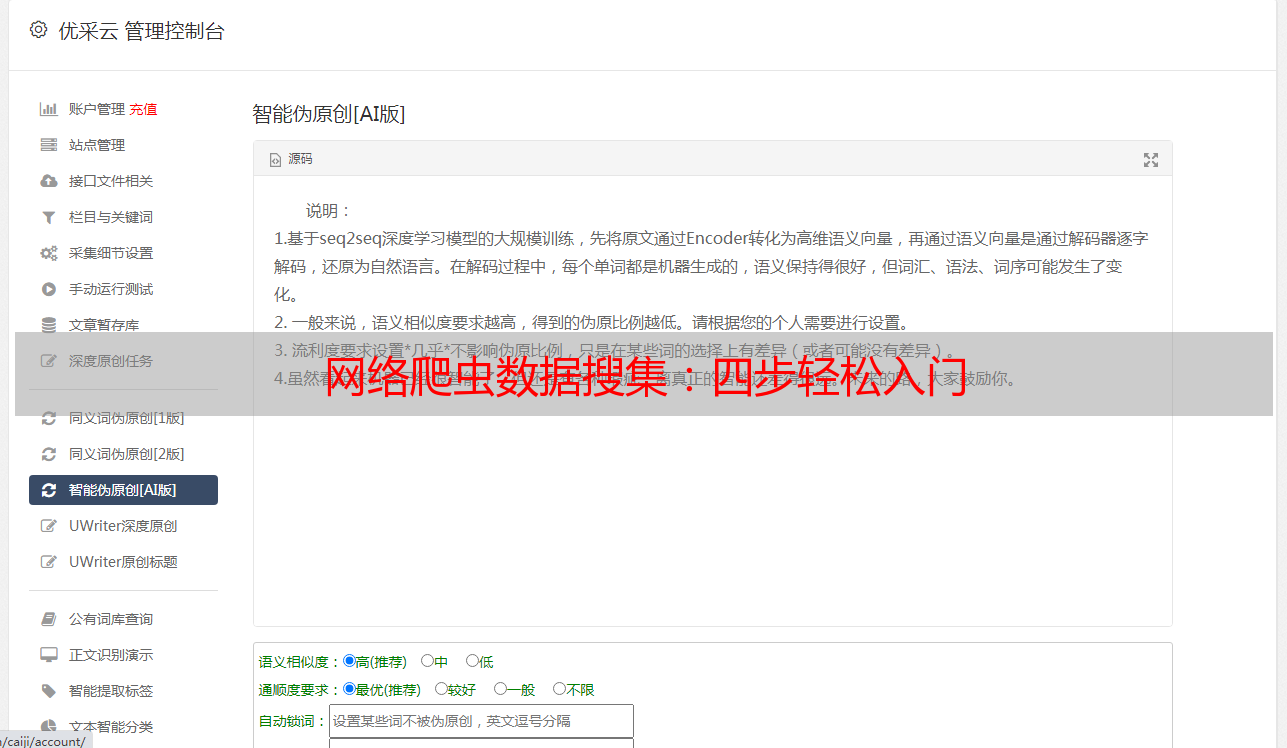

3.使用合适的库和工具

在进行爬虫搜集工作中,恰当选用相关工具库尤为关键。Python拥有诸多优良的库,例如BeautifulSoup、Scrapy等可供采用;倘若面对大范围数据收集需求,分布式爬虫架构,例如优采云AI内容工厂,亦是可选之策,这些选择能显著提升我们的效率与稳定性。

4.设计合理的请求策略

在开展网络爬虫收集工作之时,必须妥善设定请愿策略,确保不会给目标站点增加过大压力。可通过定义请求头部信息及调节请求频次等手段降低遭受封锁的风险。此外,还需关注网站防爬策略,采取相应的收集方法。

5.处理反爬机制

众多网站已实施反爬策略以防止探险家们(指爬虫)闯入。为顺利完成数据收集任务,我们有必要了解并克服此类反爬措施。如模拟登录,运用代理IP,设定随机延迟等待时间等都是跨越反爬限制之有效手段呢!

6.数据清洗和处理

在顺利完成数据采集工作之后,务必要对数据进行细致而专业的清理与处理。这个环节至关重要,它关乎后期数据分析结果的精准度以及可信度。您可以巧妙运用诸如正则表达式、XPath以及CSS选取器之类的工具,以精准抓取所需信息,并且将它们进行恰当的格式化处理。

7.数据存储和管理

我们需妥善保管搜集得到的数据,供日后的深度解析和详细使用。在此过程中,我们应选用适当类型的数据库或文件格式予以收藏,例如参考可选的MySQL、MongoDB以及CSV格式。同样重要的是,我们需制定有效的备份和恢复方案,以防备可能的数据遗失或损毁情况发生。

8.持续学习和优化

尊重且感激互联网的飞速发展及网站随时代变迁所带来的变化,因此,在探寻爬虫采集之路上,我们需始终保持旺盛的求知欲望,通过参与行业研讨会、研读相关书籍以及浏览博文等各种渠道,提升自我敏感度;同时,要持续优化与提高自身的数据搜集技术,以此应对变幻莫测的网络环境。

在此,分享了我个人从零基础到掌握爬虫技能的经验心得。希望能为正在学习或遇到困难的朋友带来些许启示。请记得,持续学习与实操,以及关注前沿科技发展,都将助您成功跻身为业界精英之列!