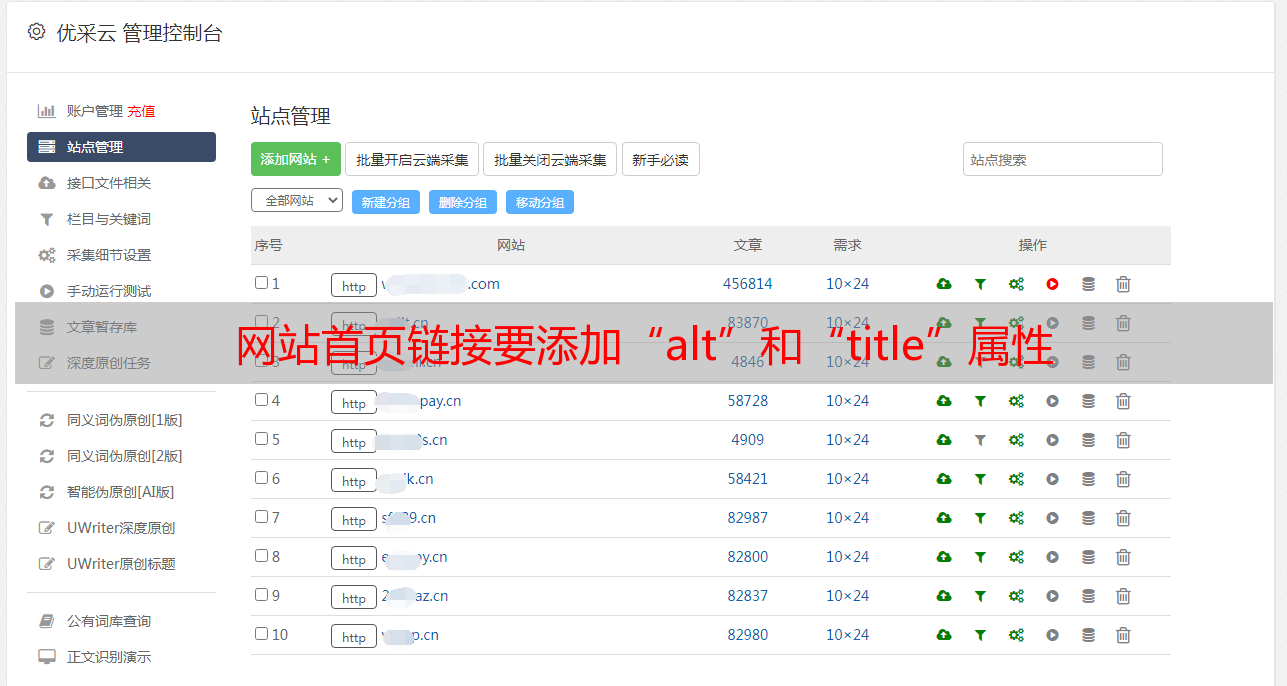

网站首页链接要添加“alt”和“title”属性

优采云 发布时间: 2021-06-19 02:04网站首页链接要添加“alt”和“title”属性

网站Homepage 是权重最高的地方。如果首页链接太少,没有“桥”,“蜘蛛”就无法继续向下爬到内页,直接影响网站收录的数量。但是,主页链接不应过多。一旦链接过多,就没有实质性的链接,容易影响用户体验,降低网站首页的权重。 收录的效果不好。请注意,该链接应建立在良好的用户体验和引导用户获取信息的基础上。

4.导航优化

导航尽量使用文字,也可以配合图片导航使用,但图片代码一定要优化。 img标签必须加上“alt”和“title”属性,告诉搜索引擎定位导航,这样即使图片无法正常显示,用户也能看到提示文字。其次,应在每个网页中添加面包屑导航。好处:从用户体验方面,让用户了解自己当前所在的位置以及当前页面在整个网站中的位置,帮助用户快速了解网站组织形态,从而形成更好的位置感,并提供每个页面都有返回界面,方便用户操作;对于“蜘蛛”,可以清晰的了解网站的结构,并且还添加了大量的内部链接,方便抓取,降低跳出率。

5.控制页面大小

减少http请求,提高网站的加载速度。当速度很慢时,用户体验不好,无法留住访客,一旦超时,“蜘蛛”也会离开。

6.适量的关键词和页面描述

关键词 不能太多也不能太少。只需在几页上列出重要的关键字,并记住将它们堆积太多。网页描述应准确、简洁地描述网页内容。

1.title title:只强调重点,尽量把重要的关键词放在最前面,关键词不要重复,尽量不要在每个页面的title标题中设置相同的内容。

2.meta 关键词标签:关键词,只列出几页重要的关键词,记得多多堆。

3.meta 描述标签:网页的描述,需要高度概括。切记不要太长也不要过分关键词,每个页面都要不一样。

4.body 中的标签:尽量让代码语义化,在合适的地方使用合适的标签,使用正确的标签做正确的事情。让读者和“蜘蛛”们一目了然地了解源代码。例如:h1-h6 用于标题类别,nav 标签用于设置页面的主导航。

对于搜索引擎来说,最直接的就是网页的HTML代码。如果代码按照语义编写,搜索引擎将很容易理解网页的含义。例如,文本模块应该有一个大标题,合理使用h1-h6,对于列表形式的代码使用ul或ol,对于重要的文本使用strong等等。总之,要充分利用各种HTML标签来完成自己的工作。当然,它们必须兼容IE、Firefox、Chrome等主流浏览器。一起来看看大名鼎鼎的禅园网站()。没有样式,代码非常语义化,看起来很整洁。加载不同的样式后,您可以随意更改页面的外观。

无样式表:

有一个样式表:

5.a 标签:页内链接,添加“标题”属性来解释,让访问者和“蜘蛛”知道。对于外链,链接到其他网站,需要添加el="nofollow"属性告诉“蜘蛛”不要爬取,因为“蜘蛛”一旦爬取了外链,就不会再回来了。

6.img 应该用“alt”属性来描述。给图片添加alt属性。当网速很慢或者图片地址无效时,可以体现alt属性的功能。可以在不显示图片时让用户知道图片的功能。

7.strong, em 标签:需要强调时使用。强标签在搜索引擎中受到高度重视。可以高亮关键词,表达重要内容。 em 标签的重点仅次于 strong 标签。

9. 巧妙地使用CSS布局,将重要内容的HTML代码置于顶部。最重要的内容被认为是最重要的。优先“蜘蛛”阅读和内容关键词抓取。搜索引擎从上到下抓取 HTML 内容。使用这个功能,可以先读取主要代码,广告等不重要的代码放在下面。例如,当左右两列的代码保持不变时,只需要改变样式,使用float:left;和浮动:右;随意调换显示器上两列的位置,保证重要性 代码在先,让爬虫先爬行。这同样适用于多列。

10. Use display: none 谨慎:对于不想显示的文本内容,应该设置z-index或者设置在浏览器显示之外。因为搜索引擎会过滤掉display:none的内容。

11.Keep文字效果

如果需要考虑用户体验和SEO效果,必须使用图片的地方,比如个性化字体的标题,我们可以使用样式控制来防止文字出现在浏览器上,但是有这个在网络代码标题中。比如这里的“电视剧分类”中,为了完美还原设计图,前端工程师可以把文字做成背景图,然后在html中使用样式设置文字的缩进到一个足够大的负数以偏离浏览器。可以使用设置行高的方法隐藏文字。

12.使用CSS截取字符

如果文字长度过长,可以使用样式截取,设置高度,隐藏多余部分。这样做的好处是,文字完全呈现给搜索引擎,外观也有保证。

5.coding 实战

6.拓展思维

如何防止搜索引擎抓取网站的隐私内容

Robots 协议(也叫爬虫协议、机器人协议等)的全称是“Robots Exclusion Protocol”,网站告诉搜索引擎哪些页面可以爬取,哪些页面不能通过Robots协议爬取。

如何写入文件:

用户代理:*

* 是通配符,表示所有类型的搜索引擎

禁止:/admin/

这意味着禁止搜索引擎抓取管理目录的内容

禁止:*?*

这意味着搜索引擎被禁止抓取收录?

站点地图:sitemap.xml

这里通过站点地图指定了一个固定的网站map 页面。目前支持这一功能的搜索引擎公司有 Google、Yahoo、Ask 和 MSN。中国搜索引擎公司显然不在这个圈子里。这样做的好处是站长不需要去各个搜索引擎的站长工具或类似的站长部件提交自己的站点地图文件,搜索引擎的蜘蛛自己会抓取robots.txt文件并读取站点地图路径,然后抓取链接的页面。

如何进行外部优化?

外部链接类别:博客、论坛、B2B、新闻、分类信息、贴吧、知乎、百科、相关信息网等,尽量保持链接的多样性。

外链选择:相对高一些网站,整体质量较好网站exchange友情链接,巩固和稳定关键词排名。

7.References

参考文献 1:从前端的角度来看,您需要为 SEO 考虑什么

参考1:Robots.txt协议详解及使用说明

8.更多讨论

SEO 和 SEM 的区别

搜索引擎优化和搜索引擎营销

SEM(搜索引擎市场)是搜索引擎营销。简单的理解就是购买搜索引擎提供的广告位。比如百度和谷歌右侧的结果就是广告。按关键词购买,按点击收费。每次有网友点击你的广告,搜索引擎都会扣除一定的费用。

区别:SEO是对网站的内容、结构、外链进行优化的一种手段,使网站更符合搜索引擎的抓取,从而提高搜索结果的排名,增加网站的流量网站。

视频链接

ppt 链接

感谢观看

今天的分享到此结束,欢迎大家点赞、转发、留言、做砖~

技能树。 IT培训机构

“我们相信每个人都可以成为工程师。从现在开始,我们会找一位前辈带领你从头开始,掌控自己的学习节奏,让你在学习的路上不再迷茫.”

这是技能树。 IT修真院,万千前辈在这里找到了自己的学习之路,学习透明,成长看得见。长者提供1对1免费指导。快来和我一起学习吧~

我的邀请码:12361358,也可以直接点击这个链接:

更多内容可以加入IT交流群565734203与你讨论交流

这里是技能树·IT修养院:初学者转网的聚集地