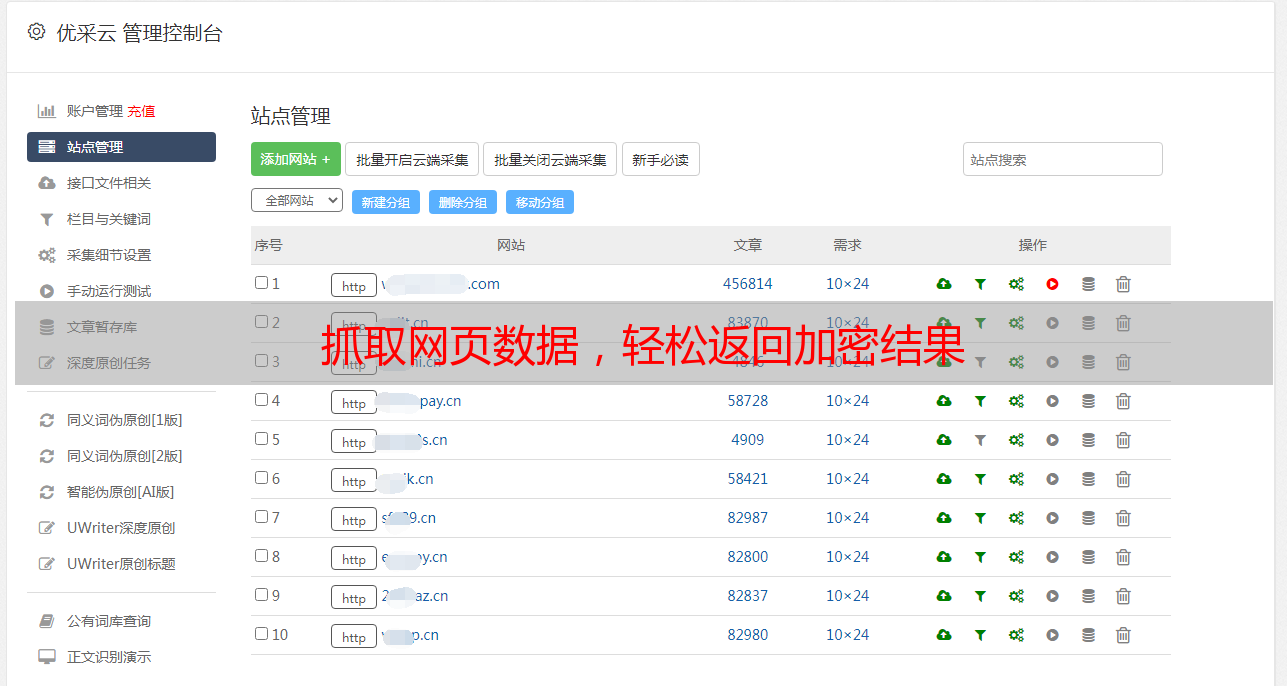

抓取网页数据,轻松返回加密结果

优采云 发布时间: 2023-06-23 16:32在当今互联网时代,抓取网页数据已成为许多企业和个人必不可少的业务。但是,随着数据安全意识的提高,越来越多的网站开始使用加密技术保护自己的数据。本文将分享作者在抓取加密数据方面的经验,并介绍如何返回加密数据。

一、了解加密技术

在开始抓取加密数据之前,我们需要了解一些基本的加密技术,如对称加密、非对称加密和哈希算法等。对称加密使用同一个密钥进行加解密,非对称加密则使用公钥和私钥进行加解密,哈希算法则通过将任意长度的消息压缩成固定长度的摘要来实现信息完整性校验。

二、选择合适的工具

在实际操作中,我们可以选择一些常用的工具来抓取网页数据,如Python中的Requests库和Selenium库等。需要注意的是,在处理加密数据时,我们需要使用一些特殊的工具来处理加密算法,如Python中的Crypto库和OpenSSL库等。

三、模拟浏览器行为

为了避免被网站识别为机器人而被封禁IP地址,我们可以使用Selenium库模拟浏览器的行为。在模拟浏览器行为时,我们需要注意设置一些浏览器的参数,如User-Agent、Cookie等。

四、破解验证码

有些网站会使用验证码来防止机器人抓取数据。在这种情况下,我们可以使用一些自动识别验证码的工具来进行破解,如Tesseract OCR和百度AI开放平台等。

五、解密加密数据

在抓取加密数据时,我们需要将其进行解密才能得到原始数据。在处理对称加密算法时,我们需要获得密钥并使用相应的算法进行解密;在处理非对称加密算法时,则需要使用相应的私钥进行解密。需要注意的是,在处理非对称加密算法时,我们还需要了解一些常用的数字签名算法和证书验证方法。

六、处理返回的数据

在成功抓取并解密后,我们就可以得到原始数据了。但是,在处理返回的数据时,我们还需要进行一些格式化和清洗操作,如去除HTML标签、提取关键信息等。此外,在处理大量数据时,我们还需要考虑如何将其存储和管理。

七、遵循网站规则

在抓取网页数据时,我们需要遵循网站的规则,并尽可能减少对网站造成的影响。如果有必要,我们可以通过与网站管理员沟通来获得更多的数据或协商处理方式。

八、保持技术更新

在互联网时代,技术更新速度非常快。为了保持自己的竞争力,我们需要不断学习新的技术和工具,并尝试将其应用到实际业务中。

九、总结

抓取网页数据是一项非常有挑战性的任务,但也是一项非常有意义的工作。通过本文的介绍,相信读者已经了解了如何抓取加密数据并返回原始数据。在实际操作中,我们需要根据具体情况选择合适的工具和算法,并遵循网站规则,尽可能减少对网站造成的影响。最后,我们还需要保持技术更新,不断提升自己的竞争力。