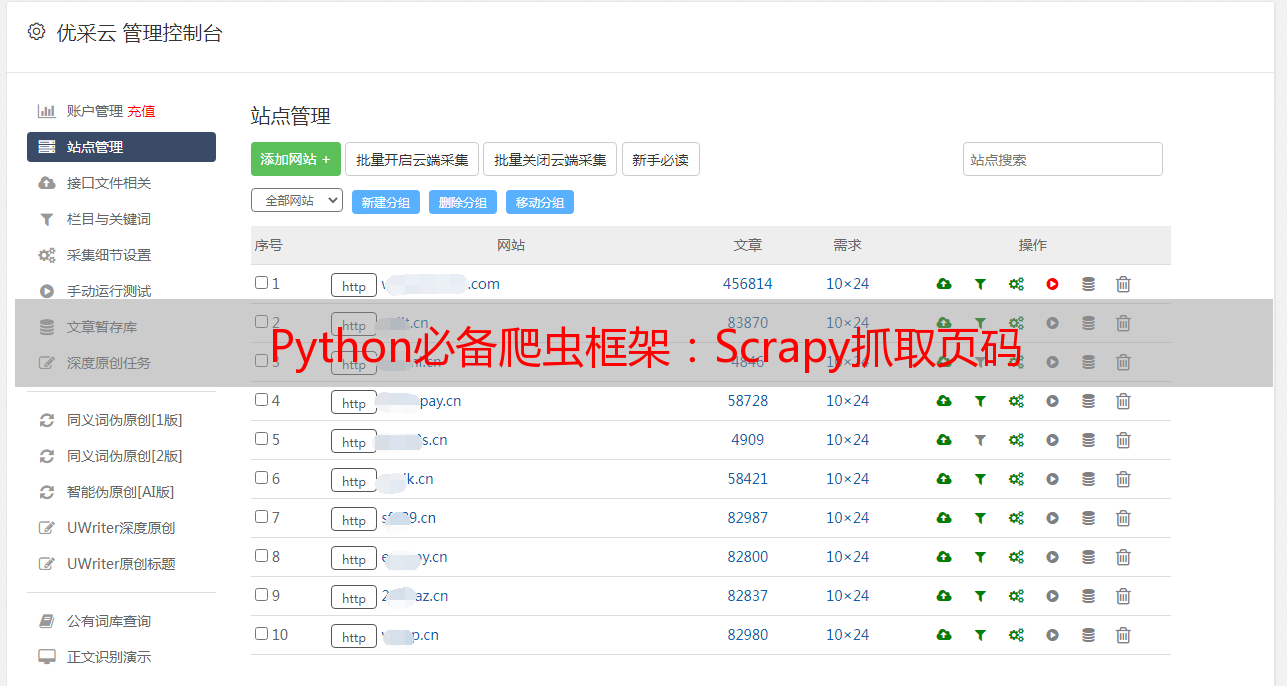

Python必备爬虫框架:Scrapy抓取页码

优采云 发布时间: 2023-06-13 05:40在互联网时代,数据是最宝贵的资源之一。而如何获取数据,成为了许多企业和个人的追求。在这样的背景下,爬虫技术应运而生。而scrapy作为Python中最为流行的爬虫框架之一Python必备爬虫框架:Scrapy抓取页码,其抓取页码的技术也备受关注。本文将从10个方面对scrapy抓取页码进行详细分析,帮助大家打造高效的爬虫。

一、什么是scrapy?

scrapy是一个基于Python实现的开源网络爬虫框架,可以轻松地从网站上提取结构化数据。它使用了Twisted异步网络框架来处理网络通信,并且具有强大的XPath和CSS选择器等功能。

二、为什么要使用scrapy?

相比其他爬虫框架,scrapy有以下几点优势:

1.高效性:scrapy采用异步IO模型,能够有效地提高爬取速度。

2.可扩展性:scrapy支持插件机制,可以方便地添加自定义功能。

3.稳定性:scrapy具有强大的错误处理能力,能够自动重试失败的请求,并记录日志。

4.易用性:scrapy提供了丰富的文档和示例,使用起来非常方便。

三、scrapy的基本结构

在使用scrapy之前,我们需要了解一下它的基本结构。scrapy的基本结构包括以下几个组件:

1.Spider:定义如何抓取页面,并从中提取数据。

2.Item:定义数据结构。

3.Pipeline:处理从Spider中提取出来的Item。

4.Middleware:处理请求和响应。

四、如何安装scrapy?

在安装scrapy之前Python必备爬虫框架:Scrapy抓取页码,需要先安装Python和pip。然后,在终端中输入以下命令即可安装:

python

pip install scrapy

五、如何创建一个scrapy项目?

在安装完成之后,我们可以使用以下命令创建一个新的scrapy项目:

python

scrapy startproject project_name

其中,project_name是你要创建的项目名称。

六、如何编写一个Spider?

编写Spider是使用scrapy进行爬虫开发的第一步。下面是一个简单的Spider实现:

python

import scrapy

class MySpider(scrapy.Spider):

name ='myspider'

start_urls =['https://www.example.com']

def parse(self, response):

#处理响应结果

pass

在这个例子中scrapy抓取页码,我们定义了一个名为MySpider的Spider类,并且指定了要爬取的起始URL。然后,在parse方法中处理响应结果。

七、如何使用XPath选择器?

XPath是一种用于在XML和HTML文档中进行导航和查询的语言。在scrapy中,我们可以使用XPath选择器来提取页面中的数据。

下面是一个例子:

python

import scrapy

class MySpider(scrapy.Spider):

name ='myspider'

start_urls =['https://www.example.com']

def parse(self, response):

#使用XPath选择器提取页面标题

title = response.xpath('//title/text()').extract_first()

在这个例子中scrapy抓取页码,我们使用了response对象的xpath方法来提取页面标题。

八、如何使用CSS选择器?

除了XPath选择器之外,scrapy还支持CSS选择器。下面是一个例子:

python

import scrapy

class MySpider(scrapy.Spider):

name ='myspider'

start_urls =['https://www.example.com']

def parse(self, response):

#使用CSS选择器提取页面标题

title = response.css('title::text').extract_first()

在这个例子中,我们使用了response对象的css方法来提取页面标题。

九、如何处理请求和响应?

scrapy提供了许多Middleware组件,用于处理请求和响应。例如,我们可以使用User-Agent Middleware来设置请求头中的User-Agent字段,以便模拟浏览器行为。

下面是一个例子:

python

import scrapy

class MySpider(scrapy.Spider):

name ='myspider'

start_urls =['https://www.example.com']

def start_requests(self):

yield scrapy.Request(

url='https://www.example.com',

headers={

'User-Agent':'Mozilla/5.0(Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

}

)

def parse(self, response):

#处理响应结果

pass

在这个例子中,我们使用了start_requests方法来生成请求,并且设置了User-Agent字段。

十、如何抓取页码?

在爬虫开发中,经常需要抓取多页数据。下面是一个简单的例子,演示了如何获取多个页面的数据:

python

import scrapy

class MySpider(scrapy.Spider):

name ='myspider'

def start_requests(self):

for i in range(1, 11):

yield scrapy.Request(url=f'https://www.example.com?71860c77c6745379b0d44304d66b6a13={i}', callback=self.parse)

def parse(self, response):

#处理响应结果

pass

在这个例子中,我们使用了for循环来生成多个请求,并且指定了回调函数为parse方法。

到这里,我们对scrapy抓取页码的技术进行了详细分析和讨论。希望本文能够帮助大家打造高效的爬虫。优采云,SEO优化,www.ucaiyun.