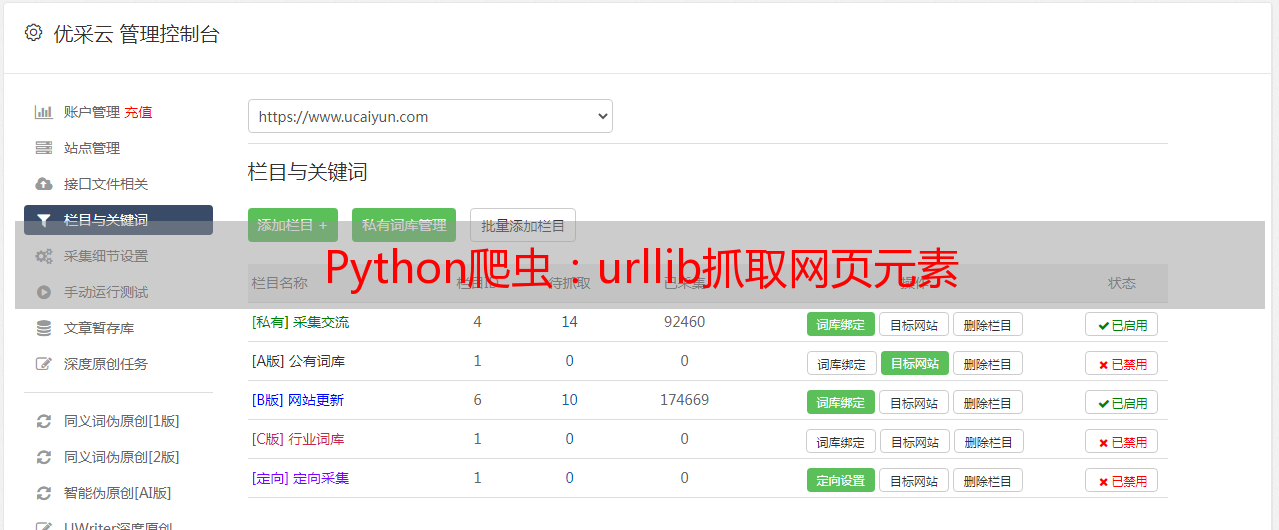

Python爬虫:urllib抓取网页元素

优采云 发布时间: 2023-06-03 17:29在网络上获取需要的信息是现代人工作、学习中经常需要做的事情。而对于Python程序员来说,使用urllib库可以轻松地抓取网页元素,快速获取所需信息。本文将详细介绍如何使用urllib库进行网页抓取,并提供实际案例进行演示,帮助读者更好地掌握这一技能。

一、什么是urllib库

urllib是Python内置的HTTP请求库,它包含了许多模块和函数,可以用于处理URL、发送HTTP请求、处理Cookie等。其中最常用的是urllib.request模块,它提供了一个简单的方法来打开URL地址,并读取页面内容。

二、使用urllib.request打开URL

使用urllib.request.urlopen(url)方法可以打开一个URL地址,并返回一个类文件对象。我们可以通过类文件对象来读取页面内容Python爬虫:urllib抓取网页元素,代码如下:

python

import urllib.request

response = urllib.request.urlopen('http://www.baidu.com')

html = response.read().decode('utf-8')

print(html)

以上代码中,我们使用了urlopen()方法打开了百度首页Python爬虫:urllib抓取网页元素,并将页面内容读取出来并用utf-8解码后输出。

三、解析HTML页面

在抓取网页数据时,通常需要从HTML页面中提取出需要的信息。这时我们就需要用到解析HTML页面的工具。Python中常用的HTML解析器有BeautifulSoup和lxml等,它们可以将HTML页面解析为树形结构,方便我们通过节点、标签等方式来获取需要的信息。

下面是一个使用BeautifulSoup解析HTML页面的实例代码:

python

import urllib.request

from bs4 import BeautifulSoup

response = urllib.request.urlopen('http://www.baidu.com')

html = response.read().decode('utf-8')

soup = BeautifulSoup(html,'html.parser')

print(soup.title.string)

以上代码中,我们使用BeautifulSoup解析了百度首页,并获取了页面标题。

四、抓取图片

在网页中抓取图片也是常见需求之一。使用urllib库可以轻松地实现这一功能。下面是一个实现抓取图片的示例代码:

python

import urllib.request

response = urllib.request.urlopen('https://www.ucaiyun.com/static/images/logo.png')

img = response.read()

with open('logo.png','wb') as f:

f.write(img)

以上代码中,我们使用urlopen()方法打开了优采云官网的logo图片,并将图片内容保存到本地文件logo.png中。

五、处理Cookie

在进行网页抓取时,有些网站需要进行登录或者验证才能访问,这时就需要处理Cookie。urllib库提供了cookiejar模块来处理Cookie。下面是一个使用cookiejar模块处理Cookie的示例代码:

python

import http.cookiejar

import urllib.request

#创建一个CookieJar对象

cookie_jar = http.cookiejar.CookieJar()

#创建一个HTTPCookieProcessor对象

handler = urllib.request.HTTPCookieProcessor(cookie_jar)

#创建一个OpenerDirector对象

opener = urllib.request.build_opener(handler)

#添加headers

opener.addheaders =[('User-agent','Mozilla/5.0')]

#打开登录页面,获取Cookie

response = opener.open('http://www.renren.com/PLogin.do')

print(cookie_jar)

以上代码中,我们使用了CookieJar、HTTPCookieProcessor和OpenerDirector三个类来处理Cookie,并输出了获取到的Cookie信息。

六、使用代理

在进行网页抓取时,有些网站会检测IP地址,如果请求次数过多,就会封锁该IP地址。这时我们可以使用代理来隐藏真实IP地址。urllib库提供了ProxyHandler类来处理代理。下面是一个使用代理进行网页抓取的示例代码:

python

import urllib.request

proxy_handler = urllib.request.ProxyHandler({'http':'http://127.0.0.1:10809'})

opener = urllib.request.build_opener(proxy_handler)

response = opener.open('http://www.baidu.com')

print(response.read())

以上代码中,我们使用了ProxyHandler类来设置代理服务器地址,并将其传给build_opener()方法来创建一个OpenerDirector对象urllib抓取网页元素,然后打开百度首页进行网页抓取。

七、异常处理

在进行网页抓取时,有可能会出现各种异常情况,如网络连接超时、无法解析页面等。这时我们需要对这些异常情况进行处理。urllib库提供了URLError和HTTPError两个异常类来处理这些异常情况。下面是一个捕获异常的示例代码:

python

import urllib.request

import urllib.error

try:

response = urllib.request.urlopen('http://www.baidu.com', timeout=0.1)

except urllib.error.URLError as e:

print(e.reason)

以上代码中,我们使用了try...except语句来捕获URLError异常,并输出了错误信息。

八、多线程抓取

在进行网页抓取时,有些网站页面内容很多,需要较长时间才能完成抓取。这时我们可以使用多线程来加速抓取过程。下面是一个使用多线程抓取网页的示例代码:

python

import urllib.request

from multiprocessing.dummy import Pool as ThreadPool

def fetch_url(url):

response = urllib.request.urlopen(url)

return response.read()

urls =[

'https://www.ucaiyun.com',

'https://www.baidu.com',

'https://www.cnblogs.com'

]

pool = ThreadPool(4)

results = pool.map(fetch_url, urls)

pool.close()

pool.join()

for result in results:

print(len(result))

以上代码中,我们使用了multiprocessing.dummy模块中的Pool类来创建一个线程池,并使用map()方法将urls列表中的URL地址交给线程池来处理。

九、结合正则表达式

在进行网页抓取时,有些页面需要根据特定的规则解析出需要的信息。这时我们可以使用正则表达式来进行匹配。下面是一个结合正则表达式进行网页抓取的示例代码:

python

import urllib.request

import re

response = urllib.request.urlopen('https://www.cnblogs.com')

html = response.read().decode('utf-8')

pattern = re.compile(r'<a href="(.*?)">(.*?)</a>')

items = re.findall(pattern, html)

for item in items:

print(item[0], item[1])

以上代码中,我们使用了re模块中的compile()和findall()方法来匹配页面中所有的超链接,并输出了链接地址和链接文本。

十、总结

本文介绍了如何使用urllib库进行网页抓取,并提供了多个示例代码进行演示。通过学习本文,读者可以掌握基本的网页抓取技能,并对Python编程有更深入的了解。在实际应用中urllib抓取网页元素,读者需要根据具体情况进行调整和优化,以达到更好的效果。