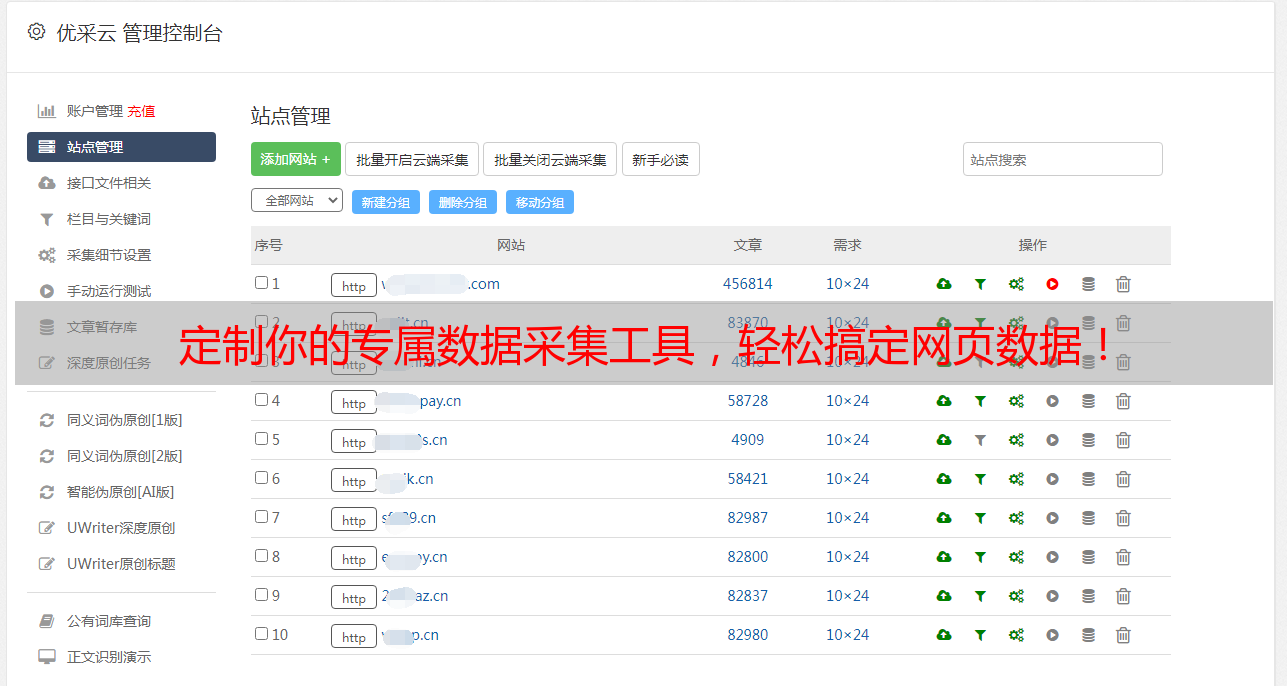

定制你的专属数据采集工具,轻松搞定网页数据!

优采云 发布时间: 2023-06-03 05:52在互联网时代,数据已经成为了企业和个人竞争的重要资本,而如何高效地采集海量数据,已经成为了各行各业都需要面对的难题。一款好用的网页数据采集工具可以大大提高我们的工作效率,让我们更加便捷地获取所需信息。本文将从“网页数据采集工具定制”这个主题入手,为大家详细介绍如何打造属于自己的数据神器。

一、什么是网页数据采集工具?

网页数据采集工具是一种可以快速、自动地抓取互联网上指定网站或页面上的信息定制你的专属数据采集工具,轻松搞定网页数据!,并将其转化为结构化数据的软件工具。它可以帮助我们从繁杂、复杂的网络环境中获取有用信息网页数据采集工具定制,提高我们的工作效率。

二、网页数据采集工具定制有哪些需求?

虽然市面上有很多成熟的网页数据采集工具,但是由于不同行业、不同企业对数据需求量和质量要求不同,因此需要针对性地进行定制开发。以下是一些常见的需求:

1.定向爬取:只需要抓取指定网站或页面上的特定信息,避免浪费时间和资源。

2.数据清洗:通过一定的规则对采集到的数据进行清洗和过滤,保证数据的准确性和一致性。

3.数据存储:将采集到的数据存储到数据库或文件中,方便后续分析和使用。

4.自动化操作:可以设置定时任务,自动抓取数据并进行处理,节省人力成本。

5.多维度分析:可以根据不同维度进行数据分析和挖掘,发现更多有价值的信息。

三、网页数据采集工具定制开发流程

1.需求分析:在开发前需要明确客户需求,确定需要爬取哪些网站或页面上的信息,并对爬取结果进行规范化处理。

2.技术选型:根据需求分析结果选择合适的开发语言、框架和库,并确定数据库和存储方式。

3.网页解析:通过网络请求获取网页内容,并通过正则表达式、XPath等方式解析出需要的信息。

4.数据处理:对采集到的数据进行清洗、去重、格式转换等操作,保证数据质量和一致性。

5.存储管理:将处理后的数据存储到数据库或文件中,并建立索引以便快速查询和分析。

6.定时任务:可以通过定时任务设置自动化操作网页数据采集工具定制,定期采集数据并进行处理。

7.数据分析与可视化:通过数据分析工具对采集到的数据进行多维度分析,并通过可视化方式展现结果,让数据更加直观易懂。

8.测试和优化:在开发完成后需要进行测试,发现并修复问题,不断优化工具性能和用户体验。

四、网页数据采集工具定制开发案例

我们以一家电商公司为例,介绍如何进行网页数据采集工具定制开发。该公司需要从京东、天猫等电商平台上爬取商品信息,并将其存储到数据库中。以下是具体步骤:

1.需求分析:明确需要爬取的商品信息包括商品名称、价格、销量、评价等,并确定需要存储到数据库中的字段。

2.技术选型:选择Python语言、Scrapy框架和MongoDB数据库,并使用Selenium WebDriver模拟浏览器操作获取动态页面信息。

3.网页解析:通过XPath解析出所需信息,并对价格、销量等数字类型的字段进行格式转换和清洗。

python

#代码示例

class JdSpider(scrapy.Spider):

name ='jd'

allowed_domains =['jd.com']

start_urls =['https://list.jd.com/list.html?cat=9987,653,655']

def parse(self, response):

#解析商品列表页面

for item in response.xpath('//li[@class="gl-item"]'):

name = item.xpath('.//div[@class="p-name"]/a/text()').get()

price = item.xpath('.//div[@class="p-price"]/strong/i/text()').get()

sales = item.xpath('.//div[@class="p-commit"]/strong/a/text()').get()

#清洗数据

price = float(price) if price else None

sales = int(sales) if sales else None

yield {

'name': name,

'price': price,

'sales': sales

}

4.数据处理:对采集到的数据进行去重、格式转换和清洗,并存储到MongoDB数据库中。

python

#代码示例

class JdPipeline:

def open_spider(self, spider):

self.client = pymongo.MongoClient('mongodb://localhost:27017/')

self.db = self.client['jd']

self.collection = self.db['products']

def close_spider(self, spider):

self.client.close()

def process_item(self, item, spider):

#去重判断

if self.collection.find_one({'name': item['name']}):

raise DropItem(f"Duplicate item found:{item!r}")

#存储到MongoDB数据库中

self.collection.insert_one(dict(item))

return item

5.定时任务:使用APScheduler库设置定时任务,每天定时爬取商品信息并存储到数据库中。

python

#代码示例

from apscheduler.schedulers.blocking import BlockingScheduler

def job():3dab45a5dca6bca9f6a6531dbce0787b=c9c84250badddf1f4d9d141fbaefa396(get_project_settings())

process.crawl(JdSpider)

process.start()

scheduler = BlockingScheduler()

scheduler.add_job(job,'interval', days=1)

scheduler.start()

6.数据分析与可视化:使用Pandas和Matplotlib库对采集到的数据进行分析和可视化。

python

#代码示例

import pandas as pd

import matplotlib.pyplot as plt

client = pymongo.MongoClient('mongodb://localhost:27017/')

db = client['jd']

collection = db['products']

data =1d04e54bd308befa2f6558ab03fd7522(collection.find({},{'_id':0}))

df = pd.DataFrame(data)

df.dropna(inplace=True)

#统计销量前十的商品名称和销量

top10_sales = df.sort_values(by='sales', ascending=False)[:10]

plt.bar(top10_sales['name'], top10_sales['sales'])

plt.xticks(rotation=90)

plt.xlabel('商品名称')

plt.ylabel('销量')

plt.title('京东电商平台销量前十商品')

plt.show()

以上是一家电商公司使用网页数据采集工具定制开发的案例。通过该工具定制你的专属数据采集工具,轻松搞定网页数据!,他们可以快速获取所需信息,并进行数据分析和可视化,为企业决策提供有力支持。

五、总结

网页数据采集工具定制开发可以帮助我们更加准确地获取所需信息,并提高工作效率。在开发前需要明确需求,选择合适的技术方案,并进行规范化处理和优化测试。本文以一家电商公司为例,介绍了网页数据采集工具定制开发的详细步骤和案例。希望本文对大家有所帮助。