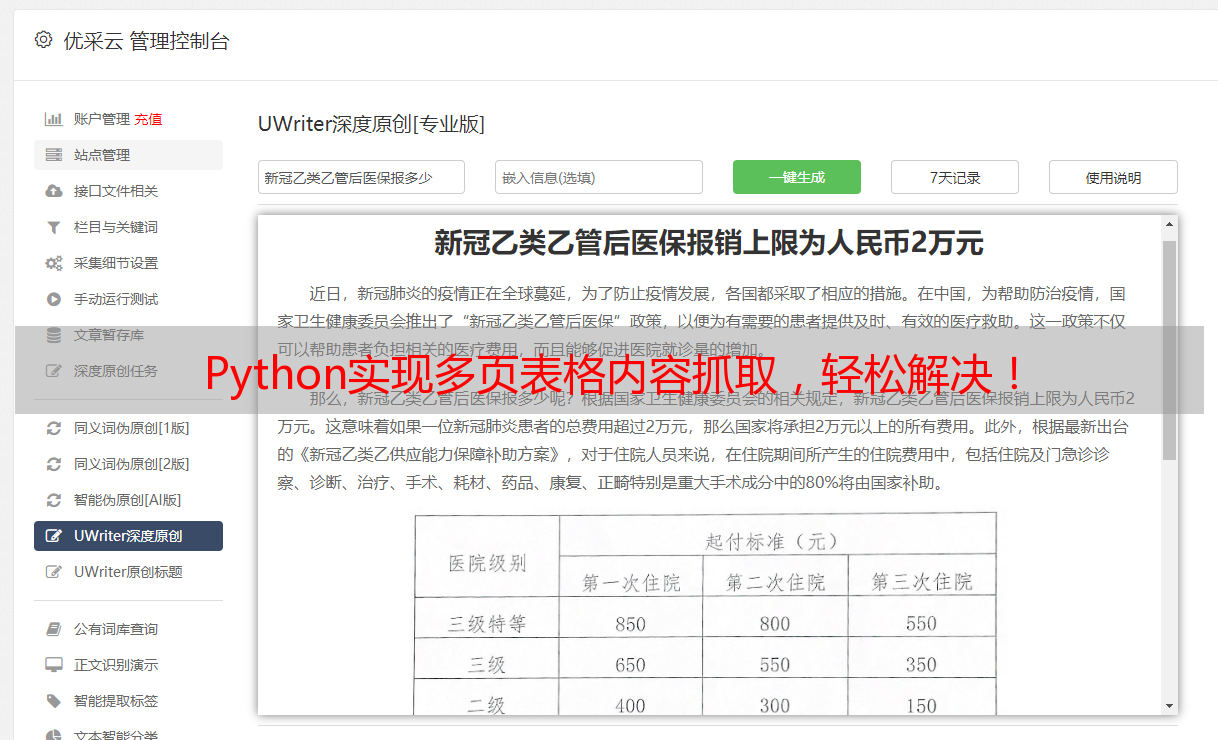

Python实现多页表格内容抓取,轻松解决!

优采云 发布时间: 2023-06-01 21:47随着互联网的快速发展,数据分析和挖掘成为了各行各业必不可少的工作内容。而网页表格中的数据则是我们获取信息的重要来源之一。但是多页网页表格内容抓取,手动复制粘贴数据往往效率低下、易出错,因此本文将介绍如何使用Python实现多页网页表格内容抓取。

一、环境准备

在开始编写代码前,需要安装Python和相关的第三方库。其中,requests、beautifulsoup4和pandas是本次实现所需要的库。使用pip install命令即可安装。

import requests

from bs4 import BeautifulSoup

import pandas as pd

二、单页数据抓取

首先,我们需要确定要抓取的目标网页,并使用requests库获取其HTML源代码:

url ='https://www.example.com/table.html'

r = requests.get(url)

soup = BeautifulSoup(r.text,'html.parser')

然后,我们需要找到包含表格数据的HTML标签,并使用beautifulsoup4库解析出其中的数据:

table = soup.find('table')

rows = table.find_all('tr')

data =[]

for row in rows:

cols = row.find_all('td')

cols =[col.text.strip() for col in cols]

data.append(cols)

最后,我们可以将获取到的数据存储为DataFrame格式,并进行进一步的数据处理和分析:

df = pd.DataFrame(data, columns=['Header1','Header2','Header3'])

print(df.head())

三、多页数据抓取

如果需要抓取多个页面的数据,我们需要在代码中添加循环,遍历每个页面并获取其中的表格数据。例如多页网页表格内容抓取Python实现多页表格内容抓取,轻松解决!,我们可以使用range()函数来循环访问不同的URL,并将获取到的数据逐步添加到一个列表中:

data =[]

for i in range(1, 11):

url =f'https://www.example.com/table_{i}.html'

r = requests.get(url)

soup = BeautifulSoup(r.text,'html.parser')

table = soup.find('table')

rows = table.find_all('tr')

for row in rows:

cols = row.find_all('td')

cols =[col.text.strip() for col in cols]

data.append(cols)

最后,我们可以将获取到的所有数据存储为DataFrame格式,并进行进一步的数据处理和分析:

df = pd.DataFrame(data, columns=['Header1','Header2','Header3'])

print(df.head())

四、异常处理

在实际应用中,我们需要考虑到一些可能会出现的异常情况,比如目标网页不存在或者网络连接出现问题等。因此,我们需要在代码中添加异常处理机制,以保证程序的稳定性。

五、总结

本文介绍了如何使用Python实现多页网页表格内容抓取Python实现多页表格内容抓取,轻松解决!,并对其中涉及到的关键代码进行了详细的讲解。通过本文的学习,读者可以掌握如何使用Python快速、高效地获取网页表格数据,并进一步进行数据处理和分析。希望本文能对读者在工作中提高效率、提升能力有所帮助。