百度蜘蛛如何抓取FTP数据?

优采云 发布时间: 2023-05-30 00:49FTP(File Transfer Protocol)是一种用于文件传输的协议,很多网站都使用FTP来进行文件管理。但是,如果你不小心将FTP服务器开放到公网上,就会面临被搜索引擎蜘蛛爬取的风险。那么如何让百度蜘蛛正确地抓取你的FTP数据呢?本文将从以下9个方面进行详细分析。

1.了解FTP

首先,我们需要了解什么是FTP。FTP是一种基于客户端-服务器模式的文件传输协议。它使用TCP作为传输协议,在网络上进行文件传输。FTP服务器需要运行在一个IP地址上,并*敏*感*词*一个指定端口(默认是21)。

2.理解搜索引擎蜘蛛

其次,我们需要理解搜索引擎蜘蛛。搜索引擎蜘蛛是一种自动程序,它们会自动地从一个网页到另一个网页抓取数据,并将这些数据保存在搜索引擎的数据库中。百度蜘蛛就是其中之一。

3.确认是否允许搜索引擎抓取FTP数据

在使用FTP时,我们需要确认是否允许搜索引擎抓取FTP数据。如果你不想让搜索引擎抓取你的FTP数据,那么你需要在FTP服务器上添加一个robots.txt文件,并在其中添加以下内容:

User-agent:*

Disallow:/

这样做可以告诉搜索引擎蜘蛛不要抓取你的FTP数据。

4.配置FTP服务器

如果你想让搜索引擎蜘蛛抓取你的FTP数据,那么你需要配置FTP服务器。具体来说,你需要将FTP服务器配置为允许匿名用户访问,并将目录权限设置为只读。这样做可以确保搜索引擎蜘蛛可以访问到你的FTP数据,但是无法修改或删除它们。

5.确认FTP被正确地配置

在配置好FTP服务器之后,我们还需要确认它是否被正确地配置。我们可以使用百度站长工具来测试是否能够正确地访问到我们的FTP数据。如果测试结果显示成功,则说明我们已经成功地配置了FTP服务器。

6.在网站中添加FTP链接

为了让搜索引擎蜘蛛能够找到你的FTP数据,我们需要在网站中添加FTP链接。具体来说,我们可以在网站的某个页面上添加一个指向FTP服务器的链接。这样做可以告诉搜索引擎蜘蛛在哪里可以找到我们的FTP数据。

7.在robots.txt文件中添加FTP链接

为了让搜索引擎蜘蛛更容易地找到你的FTP数据,我们还可以在robots.txt文件中添加FTP链接。具体来说,我们可以在robots.txt文件中添加以下内容:

User-agent:*

Disallow:

Allow:/ftp/

这样做可以告诉搜索引擎蜘蛛在哪里可以找到我们的FTP数据。

8.使用FTP代理

在使用FTP时,我们还可以使用FTP代理来提高安全性。FTP代理是一种位于客户端和服务器之间的软件程序,它可以对传输的数据进行加密和解密。使用FTP代理可以有效地防止数据被黑客窃取或篡改。

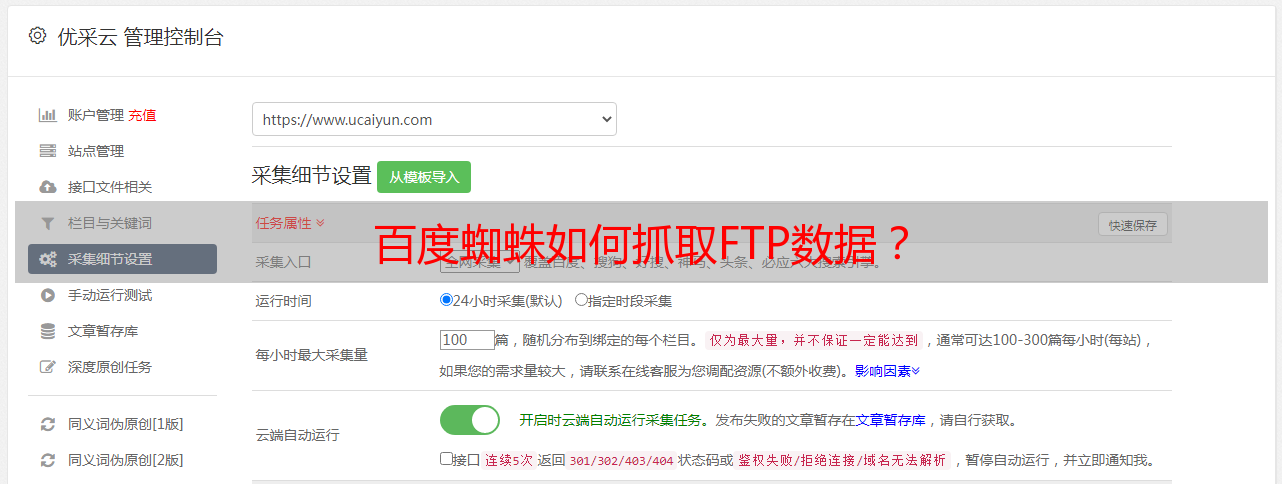

9.使用优采云进行SEO优化

最后,我们需要使用优采云进行SEO优化。优采云是一种专业的SEO优化工具,它可以帮助我们分析网站的关键词排名、流量来源等信息,并提供相应的优化建议。通过使用优采云,我们可以让我们的网站更易被搜索引擎收录,并提高网站在搜索结果中的排名。

本文介绍了如何让百度蜘蛛正确地抓取你的FTP数据。如果你想让你的网站更易被搜索引擎收录,那么请务必按照上述步骤进行操作。另外,如果你需要对你的网站进行SEO优化,请使用优采云进行分析和优化。优采云,SEO优化,www.ucaiyun.com。