抓优质文章,用爬虫工具!

优采云 发布时间: 2023-05-26 23:41自媒体从业者都知道,好的文章是吸引读者的关键,而如何快速获取到优质文章成为了许多自媒体从业者头疼的问题。但是,现在有了爬虫工具,我们就可以轻松地抓取到大量的优质文章,提高自媒体创作效率。本文将详细介绍如何使用爬虫工具抓取优质文章。

一、什么是爬虫工具?

简单来说,爬虫就是模拟人类浏览网页的过程,在互联网上抓取数据并进行处理分析。而爬虫工具则是用来实现这个过程的软件工具。目前市面上有很多种不同类型的爬虫工具,例如免费开源的Scrapy、Python Requests库等等。

二、如何选择合适的爬虫工具?

在选择爬虫工具时需要考虑以下因素:

1.网站结构:不同网站的结构不同,需要选择适合该网站的爬虫工具;

2.数据量:如果要抓取大量数据,则需要选用高效稳定的爬虫工具;

3.编程能力:如果不具备编程能力,则需要选择易于上手的爬虫工具。

综合考虑以上因素,我们可以选择Scrapy作为爬虫工具。

三、如何使用Scrapy进行网页抓取?

Scrapy是一个基于Python的开源爬虫框架,使用它可以轻松地实现网页抓取。下面我们以抓取知乎热榜文章为例,介绍如何使用Scrapy进行网页抓取。

1.安装Scrapy

在命令行中输入以下命令进行安装:

python

pip install Scrapy

2.创建Scrapy项目

在命令行中输入以下命令创建一个新的Scrapy项目:

python

scrapy startproject zhihu_spider

3.编写Spider

在zhihu_spider/spiders目录下创建一个名为zhihu.py的文件,并编写以下代码:

python

import scrapy

class ZhihuSpider(scrapy.Spider):

name ='zhihu'

allowed_domains =['www.zhihu.com']

start_urls =['https://www.zhihu.com/hot']

def parse(self, response):

for sel in response.xpath('//div[@class="HotItem-content"]'):

item ={}

item['title']= sel.xpath('a/h2/text()').extract_first()

item['url']= sel.xpath('a/@href').extract_first()

yield item

以上代码实现了对知乎热榜页面的抓取,并将标题和链接保存到item中。

4.运行Spider

在命令行中进入zhihu_spider目录,并输入以下命令运行Spider:

python

scrapy crawl zhihu -o zhihu.csv

以上命令将把抓取到的数据保存到zhihu.csv文件中。

四、如何使用爬虫工具抓取优质文章?

使用爬虫工具抓取优质文章的过程与上述知乎热榜页面的抓取类似,只需要修改Spider的代码即可。我们可以选择一些比较优质的网站进行抓取,例如:

1.知乎日报:http://daily.zhihu.com/

2.极客时间:https://www.geekbang.org/

3.优达学城:https://cn.udacity.com/

使用类似于上述知乎热榜页面的代码进行抓取即可。

五、如何处理抓取到的数据?

在抓取到数据之后,我们需要对数据进行处理,才能够用于文章创作。下面介绍两种常用的数据处理方式。

1.自然语言处理

自然语言处理是指通过计算机程序对自然语言文本进行分析和理解的技术。我们可以使用自然语言处理技术对抓取到的文章进行分词、关键词提取等操作,从而得到更加有用的信息。

2.数据可视化

数据可视化是指将数据通过图表等方式进行展示的技术。我们可以使用数据可视化技术对抓取到的文章进行分析,例如制作词云图、频率分布图等。

六、如何避免抓取到低质量文章?

在使用爬虫工具进行网页抓取时,有可能会抓取到一些低质量的文章。为了避免这种情况,可以采用以下方法:

1.选择优质网站进行抓取;

2.对抓取到的文章进行筛选,例如根据关键词、作者等进行筛选;

3.使用自然语言处理技术对文章进行分析,从而确定文章质量。

七、如何合理使用爬虫工具?

在使用爬虫工具时需要注意以下事项:

1.遵守法律法规,不要抓取涉及个人隐私、知识产权等方面的内容;

2.尊重网站所有者的权益,不要对网站造成过大的访问压力;

3.注意隐私保护,不要将抓取到的数据泄露给他人;

4.合理使用爬虫工具,不要滥用。

八、总结

本文介绍了如何使用爬虫工具抓取优质文章,并对相关问题进行了详细的讨论。使用爬虫工具可以大大提高自媒体创作效率,但同时也需要注意合理使用,遵守法律法规。希望本文能够对读者有所帮助。

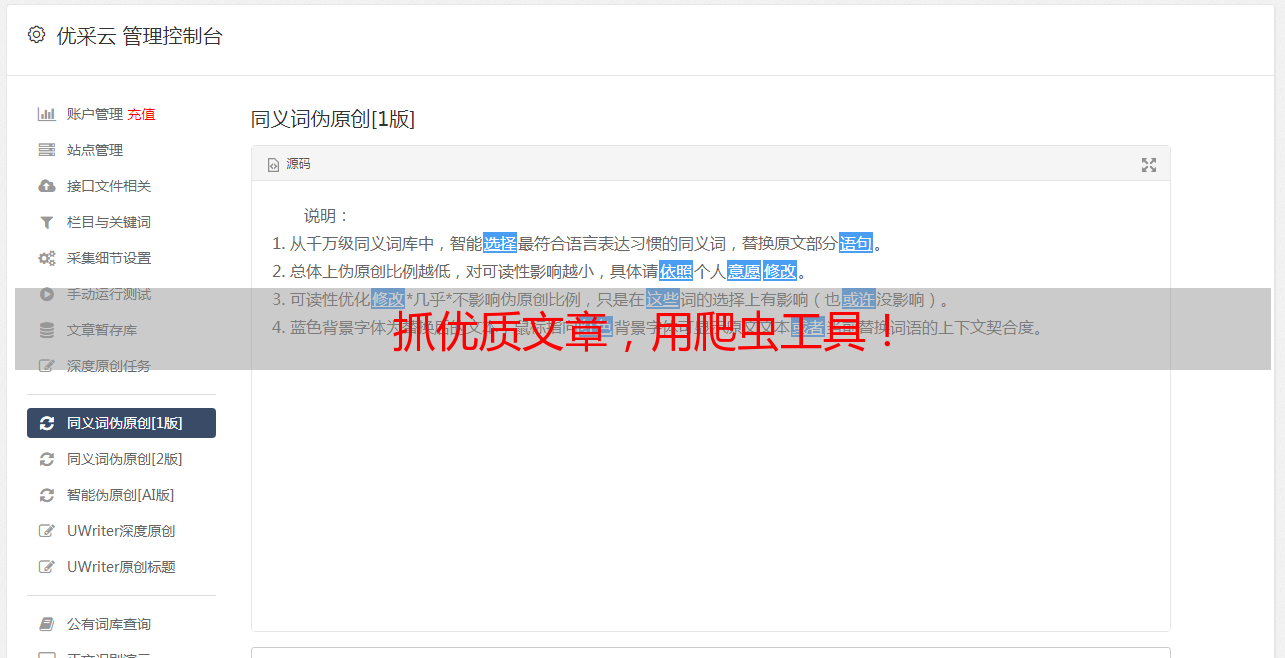

九、关于优采云

优采云是一家专注于SEO优化的互联网公司,致力于为企业提供优质的SEO服务。如果您需要进行网站优化,可以访问我们的官网:www.ucaiyun.com。