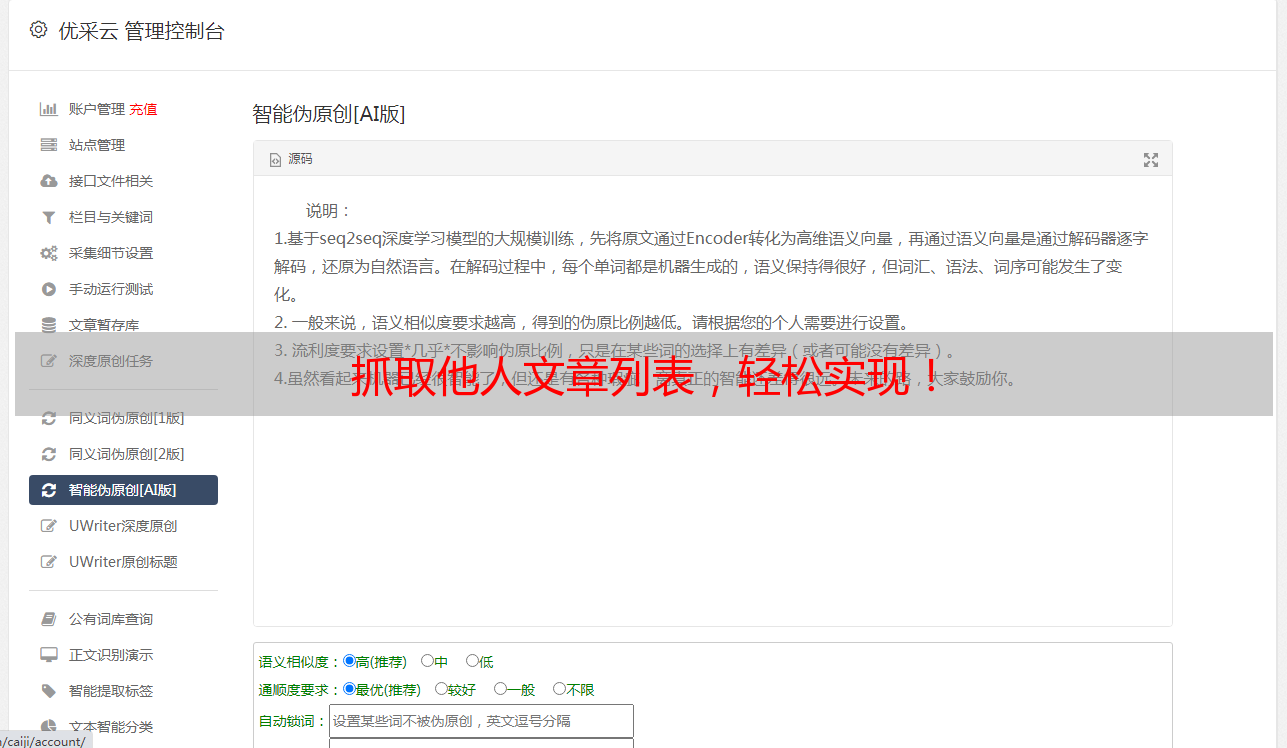

抓取他人文章列表,轻松实现!

优采云 发布时间: 2023-05-25 07:46抓取别人网站的文章列表是一项非常有用的技能,能够帮助我们快速获取其他网站的文章,并进行分析和比较。那么,如何实现这一目标呢?本文将为您详细介绍。

一、什么是抓取别人网站的文章列表?

我们可以将“抓取”简单理解为“获取”的过程,而“别人网站”的文章列表则指其他网站上的文章目录或索引。因此,抓取别人网站的文章列表即为从其他网站上获取其文章目录或索引的过程。

二、为什么需要抓取别人网站的文章列表?

在互联网时代,获取信息变得非常容易。但是,由于信息量庞大,我们往往需要从多个来源获取信息,并进行筛选和比较。此时,抓取别人网站的文章列表就成了一个非常有用的工具。通过抓取其他网站的文章列表,我们可以快速了解行业热点、竞争对手情况等信息,并进行分析和比较。

三、如何抓取别人网站的文章列表?

1.确定需要抓取哪些网站

在开始抓取之前,我们需要确定需要获取哪些网站的文章列表。通常情况下,我们可以通过搜索引擎或社交媒体等渠道获取目标网站的信息。

2.使用网络爬虫工具

网络爬虫是一种自动化程序,可以模拟人类浏览器的行为,从网页中抓取所需的信息。我们可以使用Python编写网络爬虫程序,并利用第三方库如BeautifulSoup、Scrapy等来实现。

3.分析网页结构

在编写网络爬虫程序之前,我们需要先分析目标网站的页面结构,并确定需要抓取哪些信息。通常情况下,我们可以通过浏览器开发者工具来分析网页结构。

4.编写网络爬虫程序

在确定了目标网站和需要抓取的信息之后,我们可以开始编写网络爬虫程序。例如,以下是使用Python和Requests库抓取某个网站文章列表的示例代码:

python

import requests

from bs4 import BeautifulSoup

url ="https://www.example.com/articles"

response = requests.get(url)

soup = BeautifulSoup(response.content,"html.parser")

articles =[]

for link in soup.find_all("a"):

if "article" in str(link.get("href")):

articles.append(link.get("href"))

print(articles)

以上代码会从"https://www.example.com/articles"页面中获取所有包含“article”的链接,并将其保存到一个列表中。

5.存储数据

最后,我们需要将抓取到的数据进行存储。通常情况下,我们可以将数据保存到数据库中,或者将其导出为Excel或CSV格式的文件。

四、抓取别人网站的文章列表需要注意什么?

1.法律合规

在抓取其他网站的内容时,我们需要确保自己的行为是符合法律规定的。通常情况下,我们可以遵循Robots协议和版权法等相关法律法规来规范自己的行为。

2.网络安全

在进行网络爬虫时,我们需要注意网络安全问题。尤其是在使用第三方库或框架时,需要确保其来源可靠,并避免潜在的安全风险。

3.数据质量

抓取到的数据可能存在噪声和误差,需要进行数据清洗和去重等操作,以提高数据质量和准确性。

五、总结

通过本文的介绍,我们了解了如何抓取别人网站的文章列表,并掌握了一些实现方法和注意事项。希望本文能对您有所帮助。