PHP实现网页链接遍历,轻松抓取目标信息

优采云 发布时间: 2023-05-10 03:20在互联网时代,信息获取变得非常容易。然而,如何高效地获取所需信息,并且保证数据的准确性和完整性,是每个网络爬虫工程师都需要面对的问题。本文将介绍一种基于PHP的网页遍历抓取页面链接方法,可以轻松获取大量目标网站信息。以下将从八个方面进行详细讨论。

一、了解目标网站

在开始编写爬虫程序之前,首先需要了解目标网站的结构和数据类型。通过观察目标网站的源代码和网络请求,可以确定需要获取的数据类型和数据存储方式。同时,还需要了解目标网站的反爬虫策略,以避免被封禁IP地址。

二、选择合适的PHP爬虫框架

PHP有很多优秀的爬虫框架可供选择,例如Guzzle、Symfony DomCrawler、Goutte等等。这些框架使用方便、功能强大、稳定性高。开发者可以根据自己的需求选择合适的框架。

三、编写爬虫程序

在选择好爬虫框架后,就可以开始编写爬虫程序了。爬虫程序的主要任务是遍历目标网站的页面链接,并抓取需要的数据。具体实现方法可以参考下面的代码:

<?php

use GuzzleHttp\Client;

use Symfony\Component\DomCrawler\Crawler;

$client = new Client();

$crawler = new Crawler();

$url ='http://www.example.com';

$response =$client->request('GET',$url);

$html =(string)$response->getBody();

$crawler->addHtmlContent($html);

$links =$crawler->filter('a')->links();

foreach ($links as $link){

$href =(string)$link->getUri();

//获取链接并进行相应操作

}

?>

四、设置爬虫程序参数

在编写爬虫程序时,需要设置一些参数以确保程序的正确性和高效性。例如,设置爬虫程序的并发数、请求超时时间、请求头信息、代理IP地址等等。这些参数可以根据实际情况进行调整。

五、处理异常情况

在爬取过程中,可能会遇到一些异常情况,例如网络连接超时、页面404错误、反爬虫策略限制等等。为了保证程序的稳定性和可靠性,需要对这些异常情况进行处理,并及时通知开发者。

六、存储数据

在获取到所需数据后,还需要将数据进行存储。常见的存储方式包括MySQL数据库、Redis缓存、文本文件、Excel表格等等。开发者可以根据实际情况选择合适的存储方式。

七、优化爬虫程序

为了提高爬虫程序的效率和性能,需要对程序进行优化。例如,可以采用多线程方式进行并发请求,使用缓存技术减少重复请求,设置请求头信息模拟真实用户行为等等。

八、SEO优化

在进行网站建设时,SEO优化是非常重要的一环。通过合理的页面结构布局、关键词优化、内部链接建设等方法,可以提高网站的排名和曝光度。同时,在进行爬虫程序编写时,也需要考虑SEO因素,避免被搜索引擎封禁。

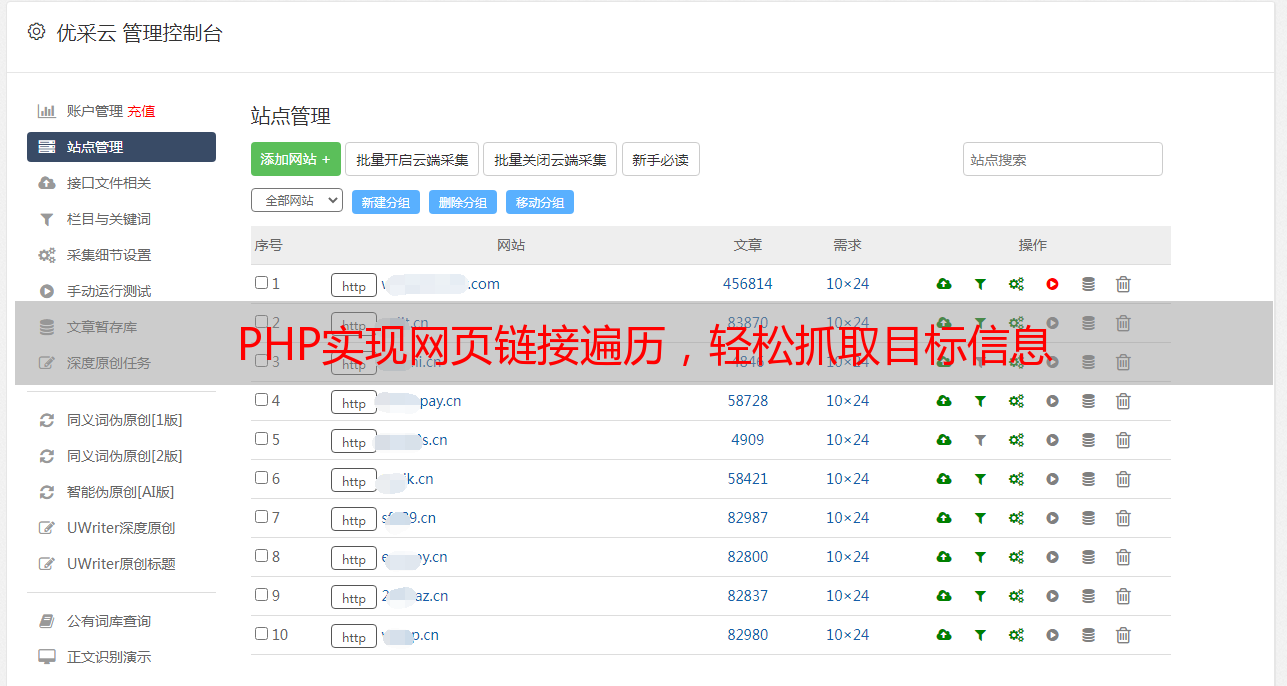

总之,PHP网页遍历抓取页面链接是一种非常实用的数据获取方式。通过本文介绍的方法,开发者可以轻松获取大量目标网站信息,并在实际应用中取得良好效果。如果您需要更多关于网络爬虫方面的帮助,请访问优采云官网,了解更多相关信息。