Python网络爬虫代码,快速抓取数据!

优采云 发布时间: 2023-05-09 19:27伴随着互联网的快速发展,数据已成为企业决策和产品设计的重要依据。而网络爬虫则是获取这些数据的关键工具之一。本文将以Python语言为例,介绍如何运用网络爬虫技术,打造高效数据抓取工具。

一、认识网络爬虫

网络爬虫是一种自动化程序,可以模拟人类在互联网上访问和浏览信息的行为,从而将目标网站上的数据抽取出来。它主要由两部分组成:爬取器和解析器。

二、Python实现网络爬虫

Python语言因其简单易学、开源免费等优点,成为了网络爬虫领域最流行的语言之一。以下是Python实现网络爬虫的基本步骤:

1.发送HTTP请求获取目标网页内容

2.解析HTML文档

3.提取所需信息

4.存储或处理所得数据

三、选择适合的库

在Python中,有很多开源库可以用于实现网络爬虫,如Requests、BeautifulSoup、Scrapy等。根据不同的需求和场景,选择适合的库能够提高开发效率和程序性能。

四、发送HTTP请求

使用Requests库可以轻松地发送HTTP请求,并获取目标网页内容。以下是一个简单的例子:

import requests

response = requests.get(url)

content = response.content

其中,`url`为目标网页的链接,`response.content`即为获取到的网页内容。

五、解析HTML文档

使用BeautifulSoup库可以快速解析HTML文档,并提取所需信息。以下是一个简单的例子:

from bs4 import BeautifulSoup

soup = BeautifulSoup(content,'html.parser')

title = soup.title.string

其中,`content`为获取到的HTML文档,`soup.title.string`即为获取到的页面标题。

六、提取所需信息

在解析HTML文档之后,需要根据具体需求提取所需信息。这里以抓取新闻标题和链接为例:

for news in soup.find_all('div', class_='news-item'):

title = news.find('a').string

link = news.find('a')['href']

print(title, link)

上述代码中,通过find_all()方法获取所有新闻条目,并分别从中提取新闻标题和链接。

七、存储或处理数据

最后,将抓取到的数据进行存储或进一步处理。这里以将数据保存至CSV文件为例:

import csv

with open('news.csv','w', newline='') as csvfile:

writer = csv.writer(csvfile)

for news in soup.find_all('div', class_='news-item'):

title = news.find('a').string

link = news.find('a')['href']

writer.writerow([title, link])

八、优化爬虫代码

在实际应用中,为了提高爬虫效率和减少被封禁的风险,需要对爬虫代码进行优化。具体措施包括使用多线程或协程、设置User-Agent头、使用代理IP等。

九、SEO优化

除了抓取数据,网络爬虫还可以用于SEO优化。通过抓取竞争对手的网站数据,分析其关键词和链接策略,可以为自己的网站制定更好的SEO策略。

十、结语

网络爬虫是一种强大的工具,可以帮助我们快速获取所需信息。但在使用过程中,也需要注意法律法规和伦理道德等方面的问题。希望本文能够为读者提供一些参考和帮助。

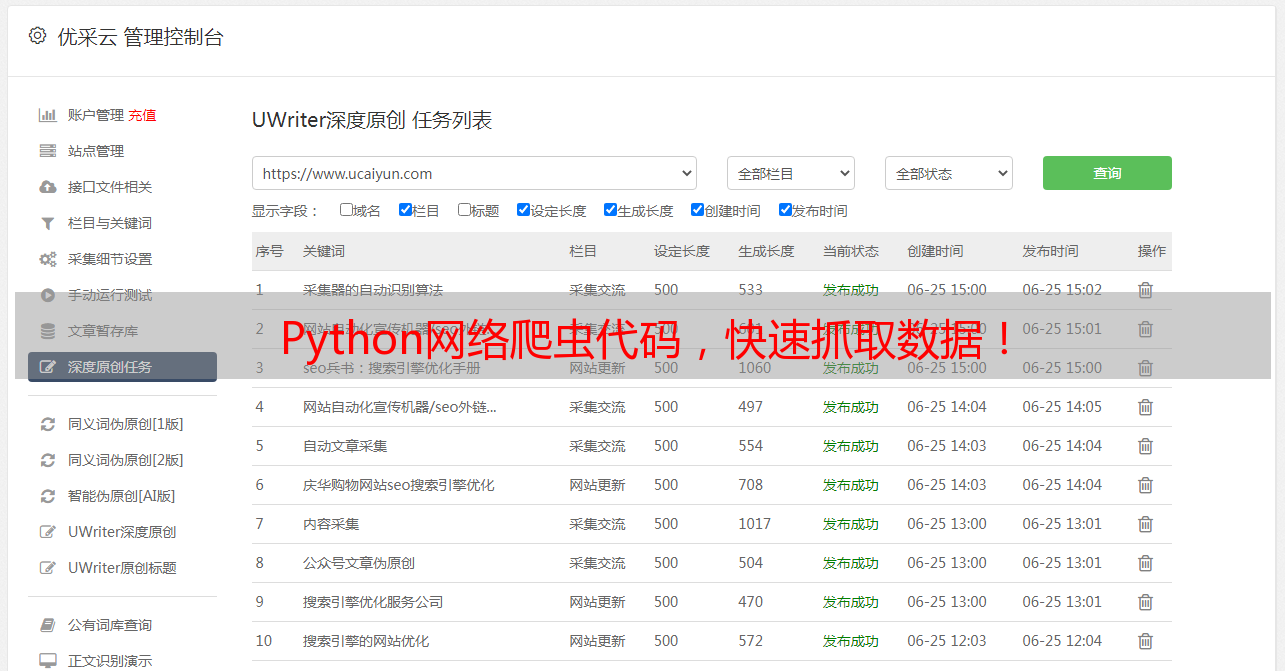

本文由优采云(www.ucaiyun.com)提供,专注于提供高效的数据处理和SEO优化解决方案。