如何选用最佳爬虫框架应对庞大网页数量?

优采云 发布时间: 2023-05-09 16:57近年来,随着互联网技术的不断发展,人们对于数据的需求也越来越大。而爬虫作为一种获取数据的方式,受到了广泛关注。然而,在爬虫抓取的过程中,面对数量庞大的网页,如何高效处理成为了一个亟待解决的问题。本文将从多个方面进行分析探讨。

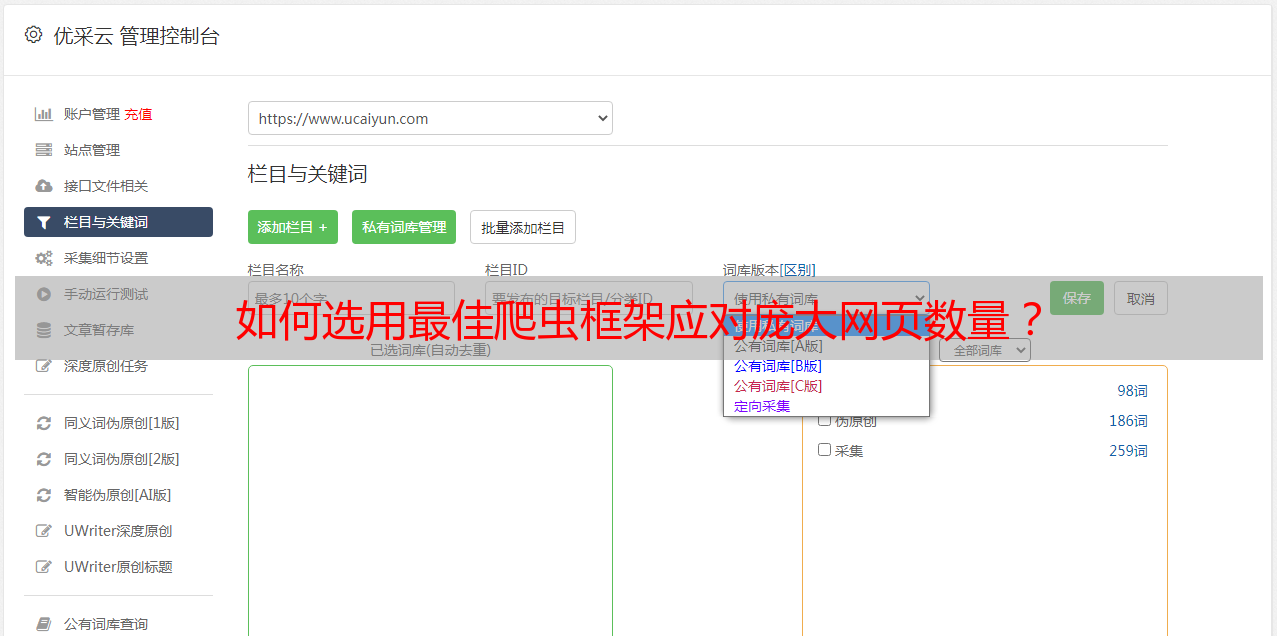

一、选择合适的爬虫框架

选择合适的爬虫框架可以极大地提高爬虫效率。目前比较流行的爬虫框架有Scrapy、PySpider等。与其他框架相比,Scrapy具有优秀的异步处理能力和分布式部署能力,可以在较短时间内完成*敏*感*词*数据采集任务。而PySpider则具有较为友好的接口和便捷的配置方式,适合快速开发小型项目。

二、使用代理IP

在进行*敏*感*词*数据采集时,很容易被目标网站识别并封禁IP地址。因此,使用代理IP可以有效地降低被封禁的概率。目前市面上有很多代理IP服务商,例如优采云(www.ucaiyun.com),可以提供高匿代理、智能代理等多种类型的代理IP。

三、开启多线程/多进程

开启多线程/多进程可以增加处理数据的效率。在Python中,可以使用multiprocessing库实现多进程,使用threading库实现多线程。需要注意的是,过多的线程/进程会占用大量内存资源,因此需要合理控制。

四、优化代码

在进行爬虫开发时,需要尽可能地优化代码。例如合理使用缓存、避免重复请求、减少网络传输等。这些优化措施可以有效地提高爬虫效率。

五、采用分布式架构

采用分布式架构可以将任务分散到不同的服务器上进行处理,从而提高整个系统的并发能力和可扩展性。目前比较流行的分布式爬虫框架有Scrapy-Redis、Distributed Spider等。

六、利用机器学习算法过滤无用数据

在爬虫抓取的数据中,往往夹杂着大量无用信息。利用机器学习算法可以对数据进行快速过滤,筛选出有价值的信息。目前比较流行的机器学习算法有朴素贝叶斯、支持向量机等。

七、使用NoSQL数据库存储数据

在数据量庞大的情况下,使用传统关系型数据库存储数据会带来很大的性能瓶颈。因此,可以考虑使用NoSQL数据库,例如MongoDB、Redis等。这些数据库具有较高的读写速度和可扩展性,适合存储海量数据。

八、进行SEO优化

对于网站而言,SEO优化是非常重要的。在进行爬虫抓取时,需要注意网页的结构和内容是否符合SEO规范。只有符合规范的网页才能被搜索引擎爬取并收录。

九、定期清理无用数据

在长期运行的爬虫系统中,难免会出现一些无用数据。定期清理这些无用数据可以有效地减少数据库空间占用和查询时间。

综上所述,针对爬虫抓取的网页数量庞大这一问题,我们可以从选择合适的爬虫框架、使用代理IP、开启多线程/多进程、优化代码、采用分布式架构、利用机器学习算法过滤无用数据、使用NoSQL数据库存储数据、进行SEO优化以及定期清理无用数据等多个方面入手,以提高爬虫效率和数据质量。