自动抓取数据,解决难题!

优采云 发布时间: 2023-05-08 18:55在当今信息化时代,数据的重要性愈加凸显,越来越多的企业开始意识到数据的价值。而如何获取大量的数据成为了企业所面临的一个难题。本文将从10个方面详细介绍如何通过自动抓取数据来解决这一难题。

1.什么是自动抓取数据?

自动抓取数据是一种通过程序自动化地从网站或者其他第三方平台上获取有用信息的技术。它可以替代人工手动采集信息的过程,从而提高采集效率,降低成本。

2.自动抓取数据的应用场景

自动抓取数据被广泛应用于各种领域,如金融、电商、医疗等。比如,在金融领域,自动抓取数据可以帮助分析师快速获取各种财经新闻、公司公告等信息,并进行相关分析;在电商领域,自动抓取数据可以帮助商家快速获取竞品价格、销售情况等信息,并进行价格调整和营销策略调整。

3.自动抓取数据的优点

相比于人工采集数据,自动抓取数据具有以下优点:

(1)采集速度快:自动抓取数据可以在短时间内获取大量数据,大大提高了采集效率。

(2)准确性高:自动抓取数据可以避免人为因素的干扰,从而保证数据的准确性。

(3)成本低:相比于人工采集数据,自动抓取数据可以大幅降低采集成本。

4.自动抓取数据的实现方式

实现自动抓取数据的方式有很多种,常见的有爬虫、API接口、RSS等。其中,爬虫是最常用的一种方式。

5.爬虫的原理

爬虫是通过模拟浏览器行为,访问指定网站,并解析网页内容,从中获取所需信息的程序。其主要分为三个步骤:

(1)发送HTTP请求:爬虫首先需要向目标网站发送HTTP请求,请求获取网页内容。

(2)解析HTML:获取到网页内容之后,爬虫会对其进行解析,并提取出所需信息。

(3)存储数据:最后,爬虫会将所需信息存储到数据库或者文件中。

6.爬虫的开发流程

开发一个爬虫通常需要以下步骤:

(1)确定目标网站:首先需要确定需要采集的数据所在的网站,以及该网站的数据结构。

(2)分析网站结构:分析目标网站的HTML结构、CSS样式和JavaScript代码,以便编写爬虫程序。

(3)编写爬虫程序:根据分析结果,编写爬虫程序,实现自动抓取数据的功能。

(4)存储数据:将采集到的数据存储到数据库或者文件中。

7.爬虫的注意事项

在开发爬虫时,需要注意以下事项:

(1)遵守法律法规:在采集数据时,需要遵守相关法律法规,不得侵犯他人权益。

(2)尊重网站规则:在采集数据时,需要遵守目标网站的规则,不得进行恶意攻击或者扰乱正常运营。

(3)反爬虫策略:为了防止爬虫攻击,很多网站会采取反爬虫策略。因此,在开发爬虫时,需要了解这些策略,并进行相应处理。

8.自动抓取数据的工具

市面上有很多自动抓取数据的工具,如Scrapy、BeautifulSoup、Selenium等。这些工具可以大幅减少开发人员的工作量,提高开发效率。

9.自动抓取数据的SEO优化

在进行自动抓取数据时,需要注意SEO优化。具体来说,需要关注以下几个方面:

(1)网站结构:网站结构应该清晰明了,方便搜索引擎抓取。

(2)页面内容:页面内容应该丰富有用,符合用户需求。

(3)关键词优化:在网页中适当地插入关键词,以便搜索引擎更好地识别网页内容。

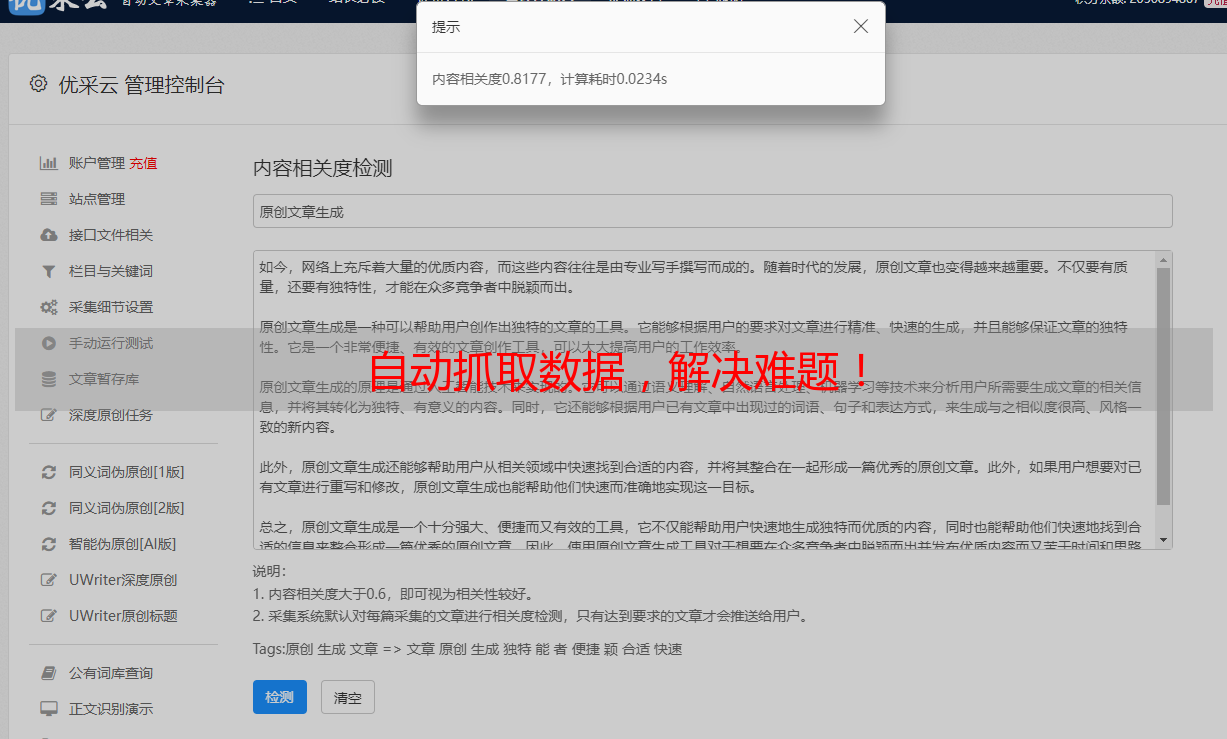

10.优采云:一款强大的自动抓取数据工具

如果您不想自己开发爬虫程序,可以选择使用第三方自动抓取数据工具。其中,优采云是一款非常不错的选择。它可以帮助您快速获取各种数据,并提供丰富的数据分析功能。同时,优采云还支持SEO优化和数据可视化等功能,让您的数据采集变得更加简单。

总之,自动抓取数据是一种非常实用的技术,在各个领域都有广泛应用。通过本文对自动抓取数据的介绍和分析,相信读者已经对其有了更深入的了解。如果您需要使用自动抓取数据技术,可以选择自己开发爬虫程序,也可以选择使用第三方自动抓取数据工具。无论哪种方式,都需要遵守法律法规和网站规则,并进行SEO优化,以便更好地服务于用户。