Python编程轻松实现多网址批量抓取

优采云 发布时间: 2023-05-08 02:58在如今信息爆炸的时代,数据的收集和整理显得尤为重要。而对于需要*敏*感*词*获取网站数据的工作来说,手动复制粘贴显然是一种低效且极易出错的方式。因此,一些网站抓取工具的出现,大大简化了这一过程。本文将介绍如何利用 Python 编写程序,实现多个网址批量抓取,并对其进行分析讨论。

一、Python 爬虫库的选择

Python 作为一门强大的编程语言,拥有众多第三方库,其中爬虫库也是其中之一。常用的爬虫库有 urllib、requests、BeautifulSoup、Scrapy 等。在本文中我们将使用 requests 库来发送 HTTP 请求,并使用 BeautifulSoup 库解析 HTML 页面。

二、多个网址批量抓取代码实现

在进行多个网址批量抓取时,我们可以先将待抓取的网址保存到一个列表中,然后循环遍历列表,依次对每个网址进行数据抓取。以下是示例代码:

python

import requests

from bs4 import BeautifulSoup

#待抓取的网址列表

url_list =[

'http://www.example.com/1',

'http://www.example.com/2',

'http://www.example.com/3',

#...

]

#循环遍历列表,依次对每个网址进行数据抓取

for url in url_list:

#发送 HTTP 请求

response = requests.get(url)

#解析 HTML 页面

soup = BeautifulSoup(response.text,'html.parser')

#提取需要的数据

data = soup.find('div', class_='data').text

#处理数据...

三、异常处理的必要性

在进行网页抓取时,经常会出现网络连接超时、网页不存在等异常情况。因此,良好的异常处理是必不可少的。以下是示例代码:

python

import requests

from bs4 import BeautifulSoup

#待抓取的网址列表

url_list =[

'http://www.example.com/1',

'http://www.example.com/2',

'http://www.example.com/3',

#...

]

#循环遍历列表,依次对每个网址进行数据抓取

for url in url_list:

try:

#发送 HTTP 请求

response = requests.get(url, timeout=10)

response.raise_for_status()

#解析 HTML 页面

soup = BeautifulSoup(response.text,'html.parser')

#提取需要的数据

data = soup.find('div', class_='data').text

#处理数据...

except Exception as e:

print('抓取网页{}出错:{}'.format(url,e))

四、多线程提高效率

当需要抓取的网页数量较大时,串行处理会导致程序运行时间过长。因此,可以通过多线程的方式提高程序效率。以下是示例代码:

python

import requests

from bs4 import BeautifulSoup

from concurrent.futures import ThreadPoolExecutor

#待抓取的网址列表

url_list =[

'http://www.example.com/1',

'http://www.example.com/2',

'http://www.example.com/3',

#...

]

#定义抓取函数

def fetch(url):

try:

#发送 HTTP 请求

response = requests.get(url, timeout=10)

response.raise_for_status()

#解析 HTML 页面

soup = BeautifulSoup(response.text,'html.parser')

#提取需要的数据

data = soup.find('div', class_='data').text

#处理数据...

except Exception as e:

print('抓取网页{}出错:{}'.format(url,e))

#使用线程池进行多线程抓取

with ThreadPoolExecutor(max_workers=10) as executor:

for url in url_list:

executor.submit(fetch, url)

五、反爬虫机制的应对

为了防止被爬虫程序*敏*感*词*抓取数据,一些网站会采取反爬虫机制,例如限制 IP 访问频率、使用验证码等。在进行网页抓取时,需要注意这些反爬虫机制,并进行相应的处理。

六、数据存储和分析

在完成网页抓取后,需要将获取的数据进行存储和分析。常用的数据存储方式有文件存储、数据库存储等。在数据分析方面,可以使用 pandas、numpy 等库进行数据处理和分析。

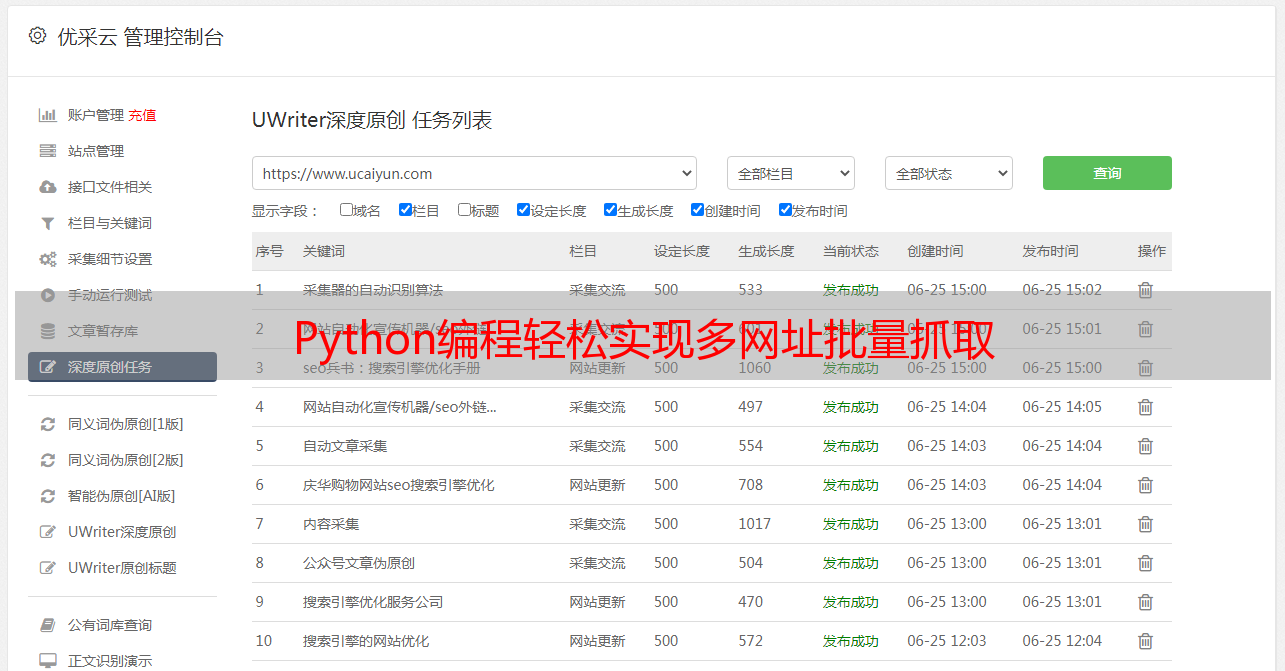

七、优采云的使用

对于需要*敏*感*词*抓取网站数据的工作来说,手动编写爬虫程序显然是一项繁琐且复杂的任务。因此,可以使用一些第三方工具来完成这一过程,例如优采云。优采云提供了强大的爬虫功能,可以快速抓取网站数据,并进行存储和分析。

八、SEO 优化

在进行网页抓取时,需要注意 SEO 优化。常见的 SEO 技巧包括合理使用标题、关键词、描述等元素,并保证网页内容质量。同时,需要注意避免黑帽 SEO 技术,避免被搜索引擎惩罚。

九、总结

本文介绍了如何利用 Python 编写程序实现多个网址批量抓取,并对其进行分析讨论。在实际应用中,需要注意异常处理、多线程提高效率、反爬虫机制的应对等问题,并合理选择第三方工具完成相应任务。同时,需要注意 SEO 优化,提高网站曝光度和用户体验。