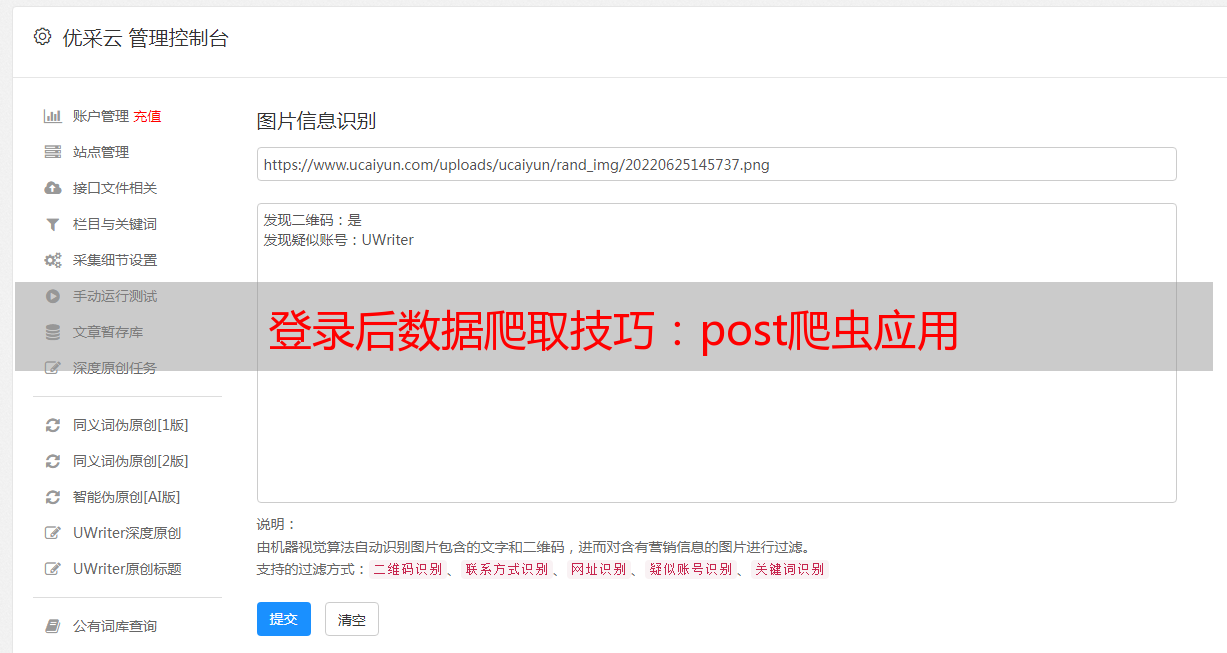

登录后数据爬取技巧:post爬虫应用

优采云 发布时间: 2023-05-06 22:31在网络爬虫的世界里,get请求是最常用的方式。但是,有些网站没有公开API,需要登录后才能获取数据,这时候就需要使用post请求来进行爬取。本文将详细介绍如何使用post爬虫获取登录后的数据。

一、什么是post请求

HTTP协议规定了两种请求方式:get和post。get请求一般用于获取数据,而post请求则一般用于提交数据。相比get请求,post请求可以提交更多数据,并且不会被浏览器缓存。

二、为什么要使用post爬虫

有些网站需要登录后才能获取到数据,这时候就需要使用post请求来模拟登录。另外,有些网站为了防止爬虫,会对get请求进行限制或者加密处理,这时候也需要使用post爬虫来获取数据。

三、使用post爬虫的步骤

1.分析登录页面

首先要分析登录页面的HTML代码,找到form表单中的input标签,并记录下它们的name和value属性。

2.构造POST数据

根据第一步记录下来的input标签的name和value属性,构造POST数据。

3.发送POST请求

使用requests库发送POST请求,并携带上述构造好的POST数据。

4.解析响应内容

根据响应内容的格式,使用正则表达式或者BeautifulSoup库对数据进行解析。

四、实例分析

以某电商网站为例,该网站需要登录后才能查看订单信息。下面是使用post爬虫获取订单信息的代码示例:

python

import requests

from bs4 import BeautifulSoup

#登录页面URL

login_url ='https://www.example.com/login'

#订单页面URL

order_url ='https://www.example.com/order'

#构造POST数据

data ={

'username':'your_username',

'password':'your_password'

}

#发送POST请求

session = requests.Session()#创建会话对象

session.post(login_url, data=data)#模拟登录

#访问订单页面并解析响应内容

response = session.get(order_url)#访问订单页面

soup = BeautifulSoup(response.text,'html.parser')#解析响应内容

orders = soup.find_all('div', class_='order-item')#获取所有订单信息

for order in orders:

print(order.text)#打印订单信息

以上代码中,首先构造了一个POST数据字典,然后使用requests库发送POST请求模拟登录,并将会话对象保存起来。接着使用会话对象访问订单页面,并使用BeautifulSoup库解析响应内容,最后输出所有订单信息。

五、总结

使用post爬虫可以轻松地获取需要登录后才能获取的数据,但需要注意的是,在模拟登录时要传递正确的用户名和密码,并且要使用会话对象保持登录状态。同时,还需要根据响应内容的格式进行相应的解析。

本文介绍了post爬虫的基本概念和使用方法,希望对大家有所帮助。如果您需要更加专业的爬虫服务,可以联系优采云(www.ucaiyun.com),我们提供高效、可靠、安全的爬虫服务,并为您的网站进行SEO优化。