自动抓取网页下载地址或*敏*感*词*,编程技术实现攻略

优采云 发布时间: 2023-05-03 18:38互联网时代,下载资源已经成为我们日常生活中不可或缺的一部分。然而,繁琐的搜索和下载过程却让很多人望而却步。那么,有没有一种方式可以自动抓取网页中的下载地址或者*敏*感*词*呢?答案是肯定的。本文将详细介绍如何利用编程技术实现这个功能。

一、什么是自动抓取?

自动抓取,又称网络爬虫(Web Crawler),是指通过编写程序,模拟人类在互联网上浏览、搜索信息的过程,从网页中提取出需要的数据并进行处理的过程。

二、自动抓取原理

自动抓取主要依靠两个技术:HTTP请求和HTML解析。

HTTP请求是指向服务器发送请求,并从服务器获取响应的过程。通过HTTP请求,我们可以获取到网页源代码。

HTML解析是指对网页源代码进行解析,并提取出需要的数据。HTML解析通常使用XPath、CSS Selector等技术。

三、Python实现自动抓取

Python是一门简单易学、功能强大的编程语言,在自动抓取领域有着广泛应用。下面以Python为例,介绍如何实现自动抓取。

1.安装requests和lxml库

requests库是Python中常用的HTTP请求库,lxml库是Python中常用的HTML解析库。可以通过以下命令安装:

pip install requests

pip install lxml

2.编写Python程序

下面是一个简单的Python程序,可以自动抓取指定网页中的下载地址:

python

import requests

from lxml import etree

url ='https://www.example.com'

response = requests.get(url)

html = etree.HTML(response.text)

download_links = html.xpath('//a[@class="download-link"]/@href')

for link in download_links:

print(link)

四、自动抓取工具

除了编写程序实现自动抓取外,还有一些自动抓取工具可以帮助我们快速地实现这个功能。

1. Scrapy

Scrapy是一个基于Python的开源网络爬虫框架,可用于快速、高效地从网站上获取结构化数据。Scrapy支持多线程、分布式等高级功能。

2. BeautifulSoup

BeautifulSoup是一个Python库,用于从HTML或XML文件中提取数据。它可以处理糟糕的HTML代码,并能够遍历文档树。

五、自动抓取的注意事项

在进行自动抓取时,需要注意以下事项:

1.遵守网站规则:不要进行未经授权的自动抓取,遵守robots协议等规则。

2.避免对服务器造成过大负担:不要进行过于频繁的抓取,以免对服务器造成过大负担。

六、自动抓取的应用场景

自动抓取在很多领域都有广泛应用,例如:

1.数据采集:从互联网上采集数据,用于分析和研究。

2.网络监控:监控网站是否正常运行,是否有异常情况。

3.网络营销:通过自动抓取获取用户信息,进行精准营销。

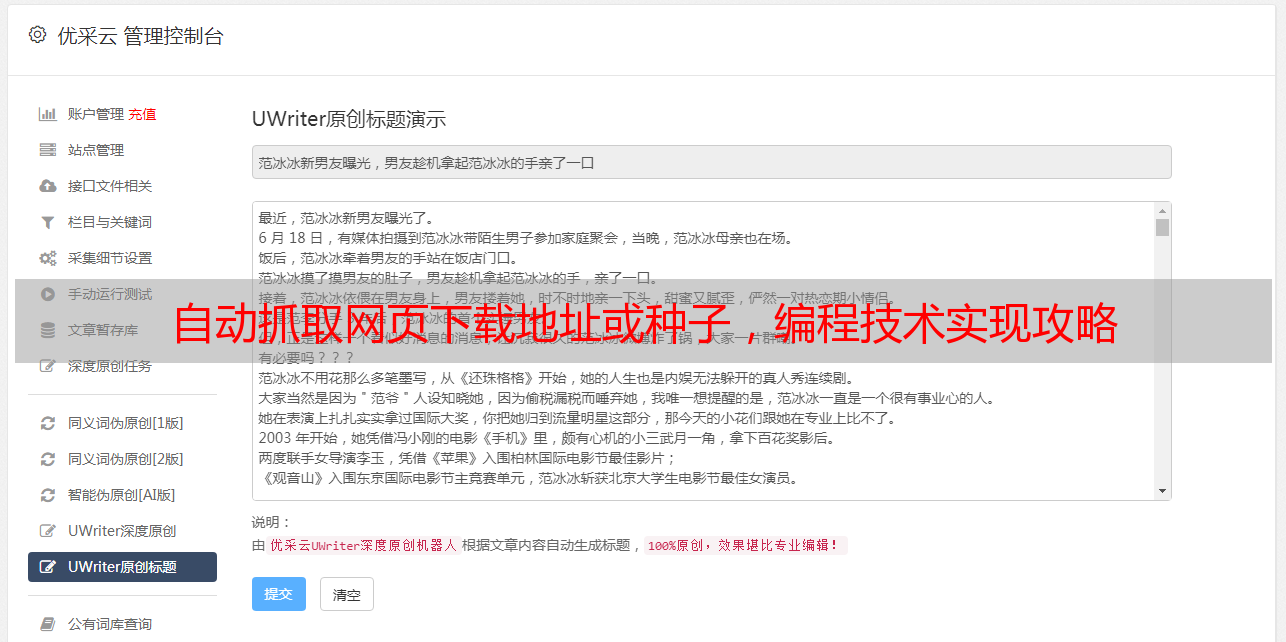

七、优采云

优采云是一家专注于提供优质网络爬虫服务的公司。我们提供高效、稳定、安全的自动抓取服务,帮助客户快速获取所需数据。同时,我们还提供SEO优化服务,帮助客户提升网站排名。欢迎访问我们的官网了解更多信息:www.ucaiyun.com。

八、结语

本文介绍了自动抓取的原理、Python实现方法、自动抓取工具、注意事项和应用场景等方面的内容。通过学习本文,相信读者已经对自动抓取有了更深入的了解。