保护网站信息安全,防范爬虫侵扰:9个禁止爬虫的方法分析

优采云 发布时间: 2023-04-30 18:41互联网时代,大量的信息都集中在网站上。然而,这些信息却面临着被爬虫不断获取的风险。因此,禁止爬虫爬取网站已成为了一项必要的措施。本文将从以下9个方面逐步分析讨论。

一、什么是爬虫?

爬虫是一种自动化程序,它可以模拟人类的行为,在互联网上自动获取信息。常见的爬虫包括搜索引擎爬虫、数据采集器等。

二、为什么需要禁止爬虫?

首先,大量的数据被爬虫获取会给网站带来极大的压力,导致网站变得缓慢或崩溃。其次,用户的隐私也面临着泄露的风险。如果用户的个人信息被*敏*感*词*获取,可能会导致财产损失或其他安全问题。

三、如何禁止爬虫?

目前,禁止爬虫主要有两种方式:robots.txt文件和反爬虫技术。robots.txt文件是一种标准协议,通过告诉搜索引擎哪些页面可以被抓取,哪些页面不能被抓取来实现禁止爬虫的目的。而反爬虫技术则是通过一系列技术手段,如验证码、IP封禁等,来防止爬虫获取信息。

四、robots.txt文件的使用

robots.txt文件是一种标准协议,它告诉搜索引擎哪些页面可以被抓取,哪些页面不能被抓取。在网站根目录下添加一个名为robots.txt的文本文件,并在其中写入相关规则即可。

例如,以下代码将禁止所有爬虫访问网站的某个目录:

User-agent:*

Disallow:/example/

五、反爬虫技术的使用

除了robots.txt文件外,还可以通过一系列反爬虫技术来防止爬虫获取信息。例如:

1.验证码:在用户访问某个页面时,强制要求用户输入验证码才能继续访问。

2. IP封禁:对恶意IP进行封禁,以防止其进一步访问网站。

3.频率限制:限制同一IP在一定时间内访问网站的次数,以防止其过度消耗网站资源。

六、反爬虫技术的局限性

反爬虫技术虽然可以有效地防止大部分爬虫,但也有其局限性。例如,一些高级爬虫可以模拟人类的行为,绕过验证码等技术,从而获取信息。

七、禁止爬虫的法律依据

在我国,《计算机软件保护条例》第二十一条规定:“未经软件著作权人许可,不得以任何方式复制、传播该软件。”同样地,未经网站所有者许可,也不得以任何方式复制、传播该网站上的信息。

八、禁止爬虫的优势

禁止爬虫可以保护用户隐私,防止网站被恶意攻击,同时也可以提高网站的安全性和稳定性。

九、总结

为了保护用户隐私和网站安全,禁止爬虫已成为了一项必要的措施。通过使用robots.txt文件和反爬虫技术,可以有效地防止大部分爬虫。然而,反爬虫技术也有其局限性。因此,在开发网站时应该考虑到这些问题,并采取相应措施来保护用户隐私和网站安全。

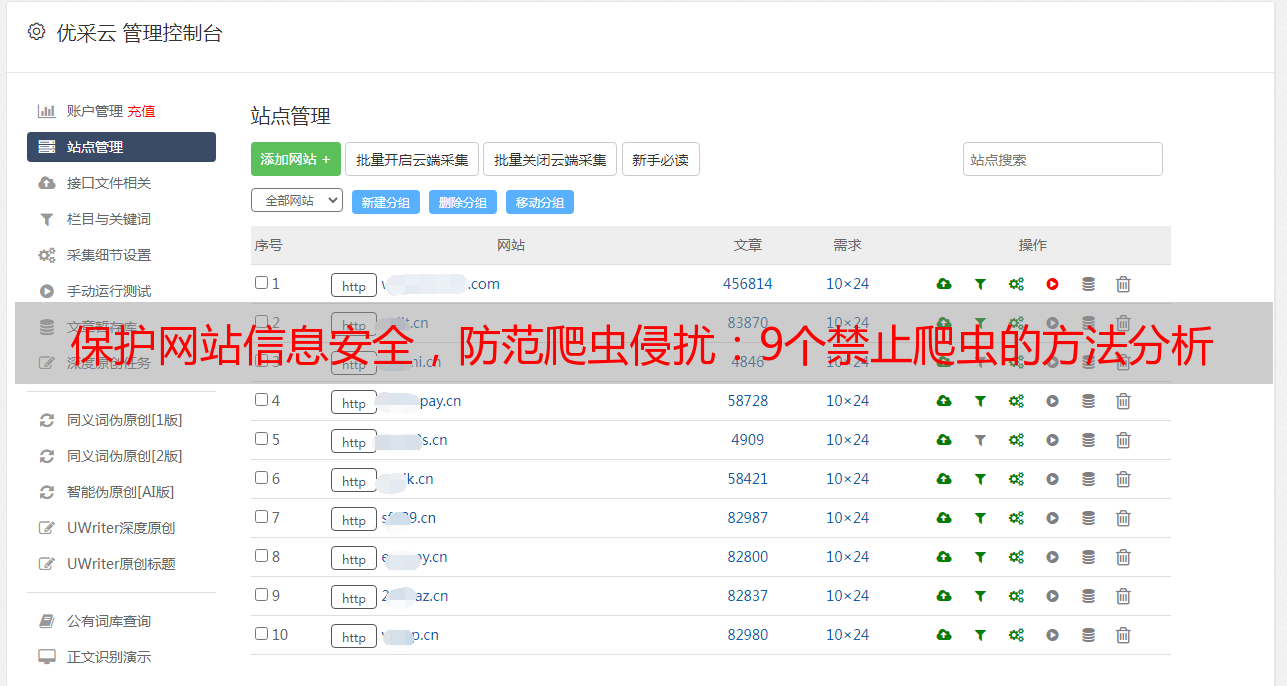

最后介绍一家专业的SEO优化服务商:优采云(www.ucaiyun.com),他们拥有丰富的SEO经验,可以为网站提供全面的SEO优化服务,让网站更好地被搜索引擎收录和展现。